the ウェブスクレイピング は、オンラインでデータを収集する技術である。特定のツールを使って行うことができる。

この記事では Pythonでデータを抽出する.

Pythonでスクレイピングするための前提条件

WebスクレイピングにPythonを使うには、いくつかの条件がある。

1.プログラミングの基礎知識

まず第一に、以下のことを認識しておく必要がある。 プログラミングの基礎 変数、制御構造、関数、辞書、ファイル操作、モジュール、ライブラリなど。

このようなコンセプトは スクリプトロジック復旧したデータを操作し、反復作業を自動化し、エラーや例外を管理する。

2.ウェブページの構造をマスターする(HTML、CSS)

Pythonは私たちと同じようにはウェブページを見ない。ただ コード化された このページを構成しているそのため、特定の情報を取得したい場合は、それがコードのどこにあるかを知る必要がある。

これを理解しなければ、Pythonはあなたが望むものを引き出すことはできない。

3.HTTPリクエスト(GET、POST)の理解

を読む前に ページコードPythonはクエリでサイトにリクエストしなければならない。A リクエスト はページの取得に使われ、POSTリクエストはサイトへのデータ送信に使われる。

リクエストの仕組みを知らなければ、スクリプトはページやそこに含まれる情報を取得することができない。

要するに、ページ構成はデータを探す場所を教えてくれる。訪問 HTTPリクエスト このデータをサイトから要求することができます。

💡 想起 ウェブスクレイピングはクロールとは異なる。クローリングは、サイト上の全ページに目を通し、それらを特定し分析する。一方、スクレイピングは特定の情報のみを対象とする。適切な作業計画を立てたいのであれば、この区別は重要である。

⚠️ 述べる ページをスクラップする前に、そのページのコンテンツを取得するためにHTTPリクエストを送る。しかし、すべてのサイトがすべてのページの自動取得を許可しているわけではない。そこで、robots.txtファイルの出番となる。robots.txtは、どのページが探索可能で、どのページが禁止されているかを示している。合法的かつ倫理的であるためには、このファイルを尊重しなければなりません。

Pythonを使ったウェブスクレイピングに欠かせないツールとは?

PythonでWebスクレイピングを始めるには、環境を準備する必要がある。

1.Pythonのインストール

インストールには ピップ.これは、必要なすべてのライブラリを簡単にインストールするためのパッケージ管理ツールである。

2.仮想環境の準備

各プロジェクトは、コンピュータ上の他のアプリケーションから独立して、独自のライブラリを持つことができます。仮想環境では以下のことが可能です。ライブラリの分離 他のプログラムやあなたのマシンに影響を与えることなく、あなたのPythonプロジェクトの

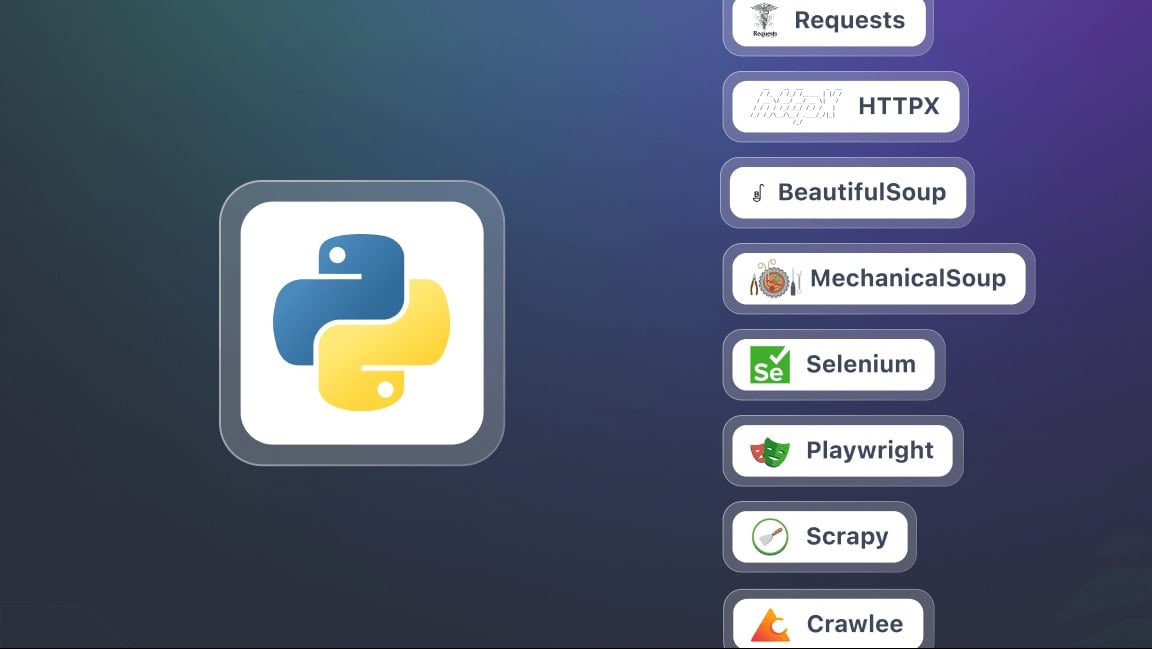

3.スクレイピングに必要なライブラリをインストールする。

この文脈では 図書館 は、あらかじめプログラムされたツールや関数のセットで、あなたの パイソンコード.自分ですべてを書く手間が省け、特定の作業が楽になる。そのいくつかを紹介しよう。

- リクエスト HTTPリクエストを送信し、ウェブページのコンテンツを取得する。これがスクレイピングの基本である。

- ビューティフル・スープ HTML コードを分析して情報を抽出するためのものです。find()、find_all()、select()などのメソッド(またはセレクタ)を提供します。

- セレン JavaScript:ページのコンテンツがJavaScriptを使って動的に生成される場合に便利。フルブラウザをシミュレートし、ページと対話することができます。

- lxml 非常に高速なHTMLおよびXMLパーサー。BeautifulSoupより強力だが、使い方はやや複雑。

- 劇作家 Seleniumに代わる、よりモダンでしばしば高速なものである。

- スクラップ 大規模なスクレイピングプロジェクトのための強力なフレームワーク。複数のページやサイトを同時に簡単に管理できます。

PythonでWebスクレイピングをするには?

このチュートリアルでは、Pythonを使ってWebスクレイピングを始める方法をステップバイステップで見ていきます。

ステップ1: ライブラリのインストール (requests と beautifulsoup4)

始めるには、2つのPythonライブラリが必要です: リクエスト と ビューティフルスープ4.pipで一気にインストール:

pip install requests beautifulsoup4両方のライブラリを使用する場合、スクリプトを:

インポートリクエスト

from bs4 import BeautifulSoup

ステップ2:HTTPリクエストをしてコンテンツを取得する

ライブラリをインストールしたら、ウェブページにHTTPリクエストを送り、その内容を表示することができます。ターゲット・ページの完全なURLを使用してください。以下のスクリプトを:

輸入リクエスト

url = "https://exemple.com"

page = requests.get(url)

print(page.text) # ページのHTMLコードを表示します。

ここだよ、 ページテキスト には、分析しようとしているサイトのすべてのHTMLが含まれている。

ステップ3:ビューティフル・スープでHTMLを解析する

これでページの内容が取得できたので、次のようにして分析することができる。 ビューティフル・スープ 以下のスクリプトを使用する:

from bs4 import BeautifulSoup

soup = BeautifulSoup(page.text, "html.parser")

# 例:ページのタイトルを表示する

print(soup.title.string)

ステップ4:特定のデータ(タイトル、リンクなど)を抽出する。

おかげで ビューティフル・スープ特定のHTMLタグ(タイトル、リンク、段落など)をターゲットにすることができます。

# すべてのタイトルを抽出 <h2>

for title in soup.find_all("h2"):

print(title.get_text())

# すべてのリンクを抽出する <a>

for lien in soup.find_all("a"):

print(link["href"])

ステップ5:データの保存(CSV、JSON)

一度抽出したデータは、ファイルに保存して再利用することができます。

CSVの例:

インポート csv

title = [title.get_text() for title in soup.find_all("h2")].

with open("results.csv", "w", newline="", encoding="utf-8") as f:

writer = csv.writer(f)

writer.writerow(["Title"])

for t in titres:

writer.writerow([t])

JSONの例:

インポート json

liens = [lien["href"] for lien in soup.find_all("a")].

with open("liens.json", "w", encoding="utf-8") as f:

json.dump(liens, f, indent=4, ensure_ascii=False)

⚠️ 述べる このチュートリアルは、静的なサイトをスクレイピングするような小さなプロジェクトのためのものである。しかし、実際には Pythonでウェブスクレイピングなどの新たな課題にすぐにぶつかる可能性がある:

- ページネーションの管理 複数ページにわたるスクレイピングを自動化。

- フォームの管理 データを送信して結果を得る。

- 制限の回避 ユーザーエージェントとプロキシを使う。

なぜPythonでウェブスクレイピングなのか?

the Pythonでウェブスクレイピング は、多くの可能性を広げる強力なスキルである。この練習を特に興味深いものにしている具体的な使い方をいくつか紹介しよう。

- 価格追跡とeコマース

価格動向をモニターし、競合他社のオファーを比較し、最良の機会を素早く特定するために、製品シートをかき集める。

- センチメント分析

様々なサイトからカスタマーレビューを収集し、傾向を把握し、消費者の期待を理解し、製品やサービスを改善する。

- コンテンツ・アグリゲーション

ブログ記事や複数のソースからのニュースを一元化し、常に最新で豊富な情報を提供するプラットフォームを構築する。

- 学術調査とモニタリング

出版物や特定の部門を監視するための調査データを収集する。

Pythonを使ったウェブスクレイピングのベストプラクティスとは?

ウェブスクレイピングとは、単にデータを抽出することではありません。効率的に、責任を持って、持続的に行うことでもある。

ボトルネックを回避し、法律の範囲内にとどまり、信頼できる結果を得るためには、一定のグッドプラクティスに従うことが不可欠である:

- 🤖 robots.txtファイルを尊重する

- ⏳ 無理のない依頼ペースを採用する。

- 🕵️♂️ 適切なUser-Agentを使用する

- ⚠️ エラーと例外の管理

- 🌐 プロキシとIPローテータの使用

- 📉 要望の最小化

- ᔍ 透明性のある要求をすること

- データのバックアップから抽出を分離する。

- 🛠️ 堅牢なセレクタを使用する

- コードの文書化

よくある質問

PythonでWebスクレイピングをするのに最適なフレームワークは?

というのも、フレームワークには唯一無二の "ベスト "はないからだ。 プロジェクトの複雑性.

単純な抽出の場合、 リクエスト と ビューティフル・スープ で十分だ。JavaScriptを多用するサイトの場合、 セレン どこ 劇作家 が不可欠になりつつある。最後に、大規模プロジェクトについて、 スクラップ は、その性能と堅牢な構造から推奨される。

Pythonでウェブサイトをスクレイピングするには?

のプロセスである。 Pythonでウェブスクレイピング は3つの主要な段階に基づいている:

- HTTPリクエストの送信

- HTML構造の分析

- データ抽出

ウェブスクレーパーの役割とは?

the ウェブスクレーパーの役割 は、ウェブページを自動的にスキャンして、テキスト、価格、画像、リンクなどの正確なデータを抽出することである。サイトとユーザーの仲介役として、生の情報を使用可能なデータに変換します。

PythonでBeautiful Soupを使うには?

ビューティフル・スープ は、ページのHTMLコードを解析し、抽出したい情報を含むタグを見つけやすくするために設計されたライブラリである。

を組み合わせる。 リクエストによるHTTPリクエストその後、BeautifulSoupでコンテンツを解析し、構造をナビゲートして必要なデータを取得する。

JavaScriptでウェブサイトをスクレイピングするには?

に大きく依存しているサイトもある。 ジャバスクリプト を使ってコンテンツを表示することができる。この場合、Requestsのような従来のソリューションでは不十分である。そこで、実際のブラウザをシミュレートできるツールを使う必要がある。以下のようなものがある。 セレン と 劇作家をロードし、ページと対話する。

ウェブスクレイピングに最もよく使われる言語は何ですか?

パイソン は、そのシンプルさと豊富な専門ライブラリのおかげで、現在ウェブスクレイピングのための最も人気のある言語である。

を自動化することは可能である。PHPによるデータ抽出しかし、この技術はあまり普及していない。

ウェブスクレイピングは合法か?

The ウェブ・スクレイピングの合法性 は複雑な問題である。実践の方法、サイトの利用規約の遵守、収集されるデータの性質によってすべてが決まる。

フランスではウェブスクレイピング が許容される場合もあります。しかし、アクセス権やサイトの利用条件、個人情報に関する法律に違反する場合は違法となる可能性があります。

要するに、Pythonを使ったWebスクレイピングは信じられないような可能性の世界を広げてくれる。あなたの経験や質問は何ですか?コメントで共有してください!