С ScraperAPIВы можете забыть о CAPTCHA, прокси-серверах и заблокированных IP-адресах. С помощью этого API от скраппинг, достаточно отправить запрос, и данные быстро доходят до вас. Сегодня ScraperAPI используют тысячи пользователей.

📌 Вот таблица, в которой собраны сильные и слабые стороны ScraperAPI по мнению пользователей:

| ✔️ Основные моменты | ❌ Слабые стороны |

|---|---|

| Эффективный обход CAPTCHA | Неясное ценообразование |

| Автоматическое и эффективное управление прокси-серверами | Периодические ограничения на пропускную способность и запросы |

| Надежный рендеринг JavaScript | Не подходит для очень больших объемов |

| Поддержка нескольких языков | Расширенная документация может быть улучшена |

| Простота интеграции и простой API |

Глобальное мнение о ScraperAPI

Пользователи описывают ScraperAPI в трех словах: быстро, надежный, эффективный.

Согласно всем отзывам, собранным на Trustpilot, G2 и Capterra, ScraperAPI имеет средний рейтинг:

4,6 ⭐⭐⭐⭐⭐

| 📊 Платформа | ⭐ Оценка из 5 |

|---|---|

| Trustpilot | 4,7 |

| G2 | 4,4 |

| Capterra | 4,6 |

✔️ Часто цитируемые достоинства :

- Надежность и эффективность скребка

- Простота использования и интеграции

- Исключительная поддержка клиентов

- Цена денег

- Специфические и расширенные функциональные возможности

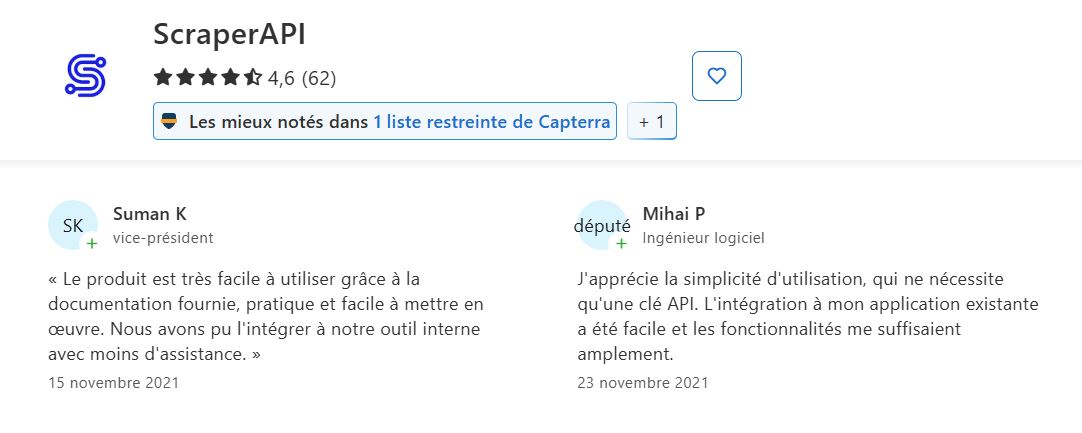

➡️ Согласно Суман К а также Михай П на Capterra :

“Продукт очень прост в использовании благодаря прилагаемой документации, удобен и легко внедряется...”

“Мне нравится простота использования, для которой требуется только API-ключ. Интеграция с моим существующим приложением прошла легко, а функциональность вполне меня устраивала”.”

➡️ Акиф Подтверждает на Trustpilot :

“Их клиентский сервис просто отличный...”

➡️ Возвращение Мухаммад Х. на G2 :

“Он упрощает веб-парсинг, управляя прокси-серверами, CAPTCHA и рендерингом браузера, что позволяет мне сосредоточиться на извлечении данных, а не на технических проблемах. API идеально интегрируется в мой существующий код, а скорость впечатляет даже при работе с крупномасштабными проектами”.”

❌ Проблемы и недостатки, отмеченные пользователями:

- Ясность ценообразования и воспринимаемая стоимость Система ценообразования: пользователи иногда путаются в ценах.

- Необходимо улучшить документацию для расширенной функциональности.

- Периодические проблемы с Ограничение потока/недостатки запросов.

- Качество поддержки.

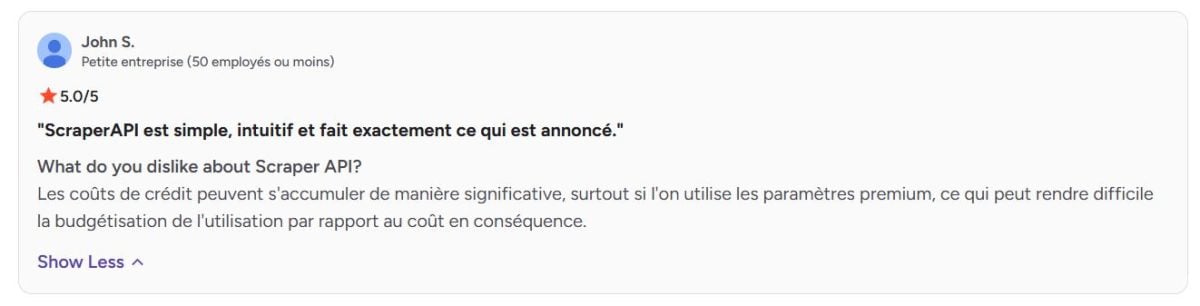

➡️ Согласно Джон С. на G2:

“Затраты на кредит могут значительно накапливаться, особенно при использовании премиальных параметров, что может затруднить составление бюджета использования в соотношении с затратами”.”

Мнение об услугах, предлагаемых ScraperAPI

Узнайте больше о ключевых услугах ScraperAPI и о том, что говорят пользователи.

1. Автоматическая ротация прокси-серверов

ScraperAPI располагает обширным пулом прокси-серверов, которые автоматически меняются при каждом запросе.

➡️ Согласно Адитья Пратап Сингх на Trustpilot:

“ScraperAPI революционизировал мои проекты по веб-парсингу. До того, как я нашел этот сервис, я постоянно сталкивался с CAPTCHA и блокировкой IP-адресов. Теперь я могу сосредоточиться на использовании данных, а не на борьбе за их получение. Ротация прокси проходит плавно, и мне нравится автоматическое управление рендерингом JavaScript”.”

2. Управление защитой от обхода

Инструмент умеет обходить сложные антибот-механизмы, брандмауэры, CAPTCHA и другие ограничения доступа, что гарантирует бесперебойную экстракцию даже на сайтах с высоким уровнем защиты.

➡️ Согласно Арун К.научный сотрудник:

“Google удалось заблокировать программные запросы, даже для некоммерческих целей и самоархивирования, а ScraperAPI оказался чрезвычайно эффективным в их обходе. Хотя маршрутизация запросов через ScraperAPI происходит гораздо медленнее, чем, например, через бесплатный прокси-сервер”.”

3. Рендеринг JavaScript

Благодаря встроенному безголовому браузеру, ScraperAPI может скрести динамические сайты, содержимое которых загружается с помощью JavaScript.

➡️ Возвращение Фаст Тек на Trustpilot:

“ScraperAPI значительно улучшил наши процессы веб-парсинга. API легко интегрируется и берет на себя большинство трудоемких задач, таких как ротация IP-адресов и управление прокси-серверами, что позволяет нам сэкономить драгоценное время. Автоматическая обработка капч — это большое преимущество, которое значительно упрощает сбор данных”.”

4. Настройка запросов

HTTP-запросы можно настраивать, изменяя заголовки, куки или пользовательские агенты, что позволяет имитировать различные модели поведения и избегать обнаружения.

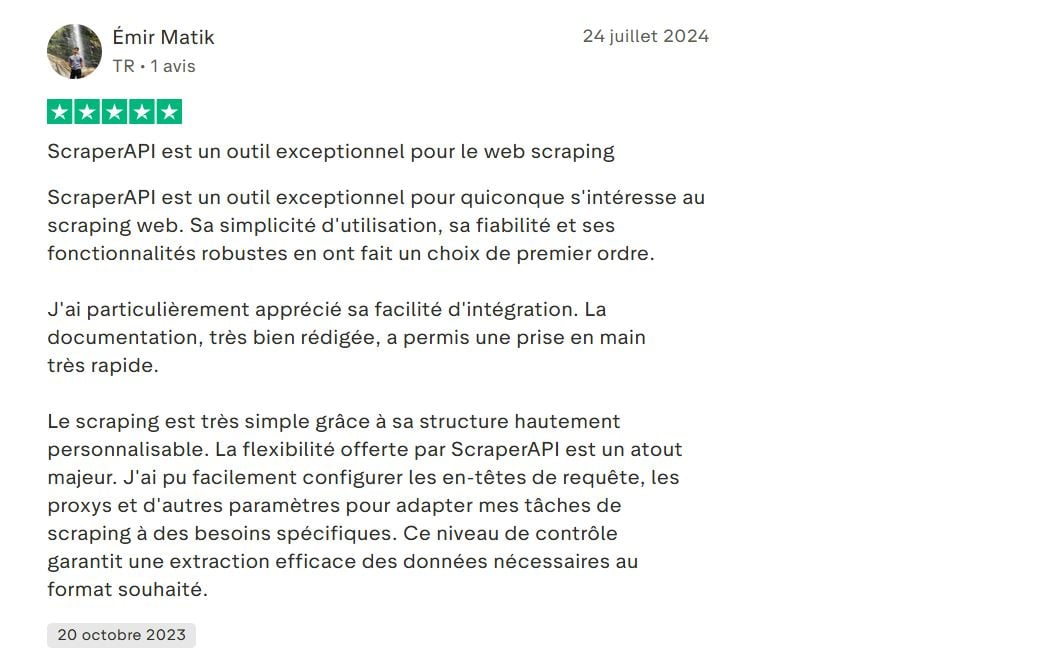

➡️ Вот мнение Эмир Матик на Trustpilot:

“…Скрапинг очень прост благодаря высоко настраиваемой структуре. Гибкость, которую предлагает ScraperAPI, является большим преимуществом. Я смог легко настроить заголовки запросов, прокси и другие параметры, чтобы адаптировать свои задачи скрапинга к конкретным потребностям…”

5. Геолокация прокси-серверов

ScraperAPI предлагает возможность выбора географического местоположения прокси-серверов (по странам). Это полезно для получения локализованных данных или для тестирования результатов, специфичных для определенного региона.

➡️ Возвращение Мелих Крс на Trustpilot:

“…Кроме того, его поддержка рендеринга JavaScript и IP-геолокации оказалась очень ценной…”

6. Приборная панель и статистика

Полная панель управления позволяет отслеживать использование, количество запросов, коэффициент успешности и оставшиеся кредиты. Это упрощает управление и оптимизацию скрапинга.

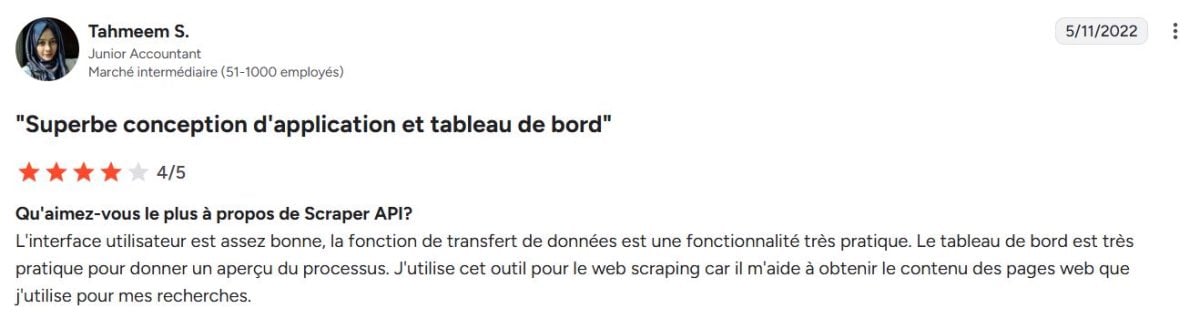

➡️ Согласно Тахмим С. на G2 :

“Пользовательский интерфейс довольно хороший, функция передачи данных очень удобна. Панель управления очень удобна для просмотра процесса. Я использую этот инструмент для веб-парсинга, потому что он помогает мне получать контент веб-страниц, которые я использую для своих исследований”.”

7. Интеграция и многоязыковая поддержка

ScraperAPI предлагает простой REST API, который может быть легко интегрирован с несколькими языками (Python, Node.js, PHP, Java и т.д.), что делает его легко применимым в различных средах.

➡️ Вот что здесь написано Дени Х. на G2 :

“Опыт для API Scraper, вероятно, соответствует опыту разработчика, имеющего опыт в веб-парсинге и знания в области различных технологий парсинга, включая Python (BeautifulSoup и Selenium), JavaScript (Puppeteer или Cheerio) и Node.js (Demand и Cheerio) ...”

8. Расширенные возможности для работы с данными

- Асинхронный сервис скрапинга : позволяет асинхронно отправлять миллионы запросов для скрапинга в очень больших масштабах.

- Структурированные данные прямой вывод в JSON или CSV для облегчения обработки данных.

- DataPipeline Поиск данных: полная автоматизация без кодирования для непрерывного поиска данных.

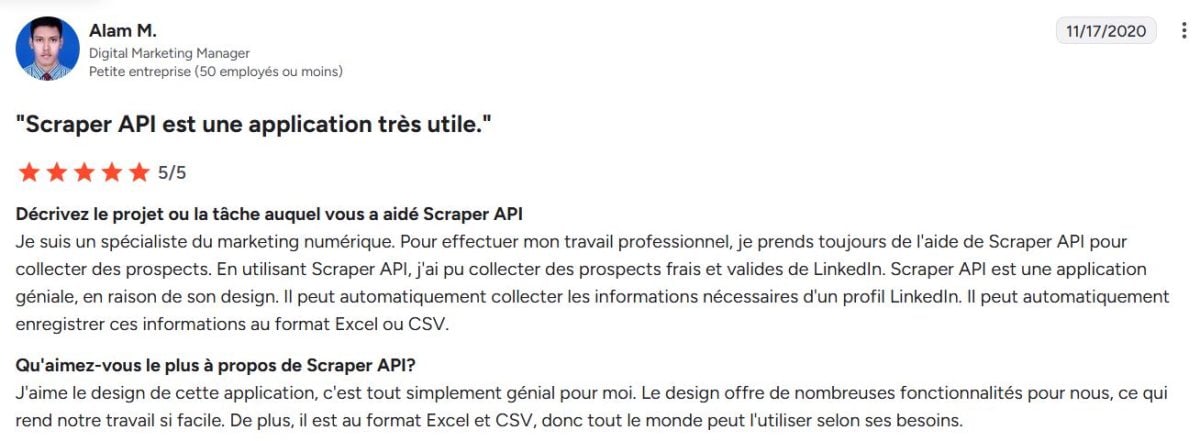

➡️ Согласно Алам М.Менеджер по цифровому маркетингу в G2:

“…Он может автоматически сохранять эту информацию в формате Excel или CSV…”

ScraperAPI : Альтернативы

ScraperAPI — не единственный игрок на рынке веб-парсинга. Существует несколько альтернативных решений, которые отличаются подходами, ценами или функциональными возможностями:

- Яркие данные самая полная платформа для сбора данных в Интернете.

- ScrapingBee главный конкурент ScraperAPI.

- Octoparse Визуальный подход без кода.

- Apify Платформа для разработки скраппера.

| 🌐 Инструмент | 📌 Специальная функция | 💬Отзывы пользователей | ⭐Средний рейтинг |

|---|---|---|---|

| ScraperAPI | Автоматическая ротация прокси-серверов, рендеринг JavaScript, настройка | Надежный и простой в использовании, но иногда запутанный в ценообразовании | 4,6 |

| Яркие данные | Самая комплексная платформа с премиальными прокси и передовым конвейером данных | Очень мощный и гибкий, но сложный в использовании | 4,6 |

| ScrapingBee | Простой API с JS-рендерингом и ротацией прокси. | Легко интегрируется и имеет хорошее соотношение цены и качества, но меньше расширенных опций. | 4,9 |

| Octoparse | Визуальный скраппинг без кода, подход, не требующий программирования | Идеально подходит для нетехнических пользователей, но ограничено большими объемами | 4,4 |

| Apify | Платформа для разработки пользовательских скребков | Очень гибкая и настраиваемая, но требует высокого уровня технических знаний. | 4,8 |

ScraperAPI - популярное и сбалансированное решение. Хотя несколько альтернатив предлагают интересные решения, адаптированные под разные профили, Яркие данные остаётся платформа веб-данных самый полный и мощный из представленных на рынке.

Рейтинг Bright Data иногда немного ниже, потому что его премиальное позиционирование что подходит не всем пользователям.

➡️ Никлас говорит Каптерра:

“Bright Data — это более дорогой сервис, но лучший в своем классе”.”

Часто задаваемые вопросы

Является ли ScraperAPI бесплатным?

ScraperAPI не является бесплатным, но предлагает бесплатная пробная версия ограниченный.

Сколько стоит ScraperAPI?

Цены на ScraperAPI обычно варьируются от 49$ а также 475$ в месяц.

Как работает ScraperAPI?

Технически ScraperAPI действует как промежуточный между вашим приложением и веб-сайтами, с которых нужно собирать данные. Он автоматически управляет ротацией прокси, IP-адресами, рендерингом JavaScript и обходом защиты. Инструмент позволяет вам восстановление данных без блокировки.

Как использовать ScraperAPI с Python?

Интеграция с Python проста благодаря хорошо документированному REST API. Достаточно отправить HTTP-запрос на адрес API ScraperAPI с вашим API-ключом и целевым URL-адресом.

1. Укажите URL ScraperAPI с вашим API-ключом и целевым URL.

запросы на импорт

url = "http://api.scraperapi.com"

параметры = {

'api_key': 'YOUR_API_CLE',

'url': 'https://exemple.com'

}2. Отправьте запрос

response = requests.get(url, params=params)3. Отображение содержимого найденной страницы

print(response.text)Может ли ScraperAPI обойти CAPTCHA?

Да. Одной из сильных сторон ScraperAPI является его способность автоматически обходить CAPTCHA и другие системы защиты от ботов.

🔚 Подводя итог, можно сказать, что ScraperAPI является эффективным решением для автоматизации сбора данных в Интернете. Но для более полного обслуживания, Bright Data — идеальный вариант.

Не стесняйтесь задавать вопросы в комментариях и делиться своим опытом!