Med ScraperAPIDu kan glemme alt om CAPTCHA'er, proxyer og blokerede IP-adresser. Med denne API fra web scraping, il suffit d’envoyer une requête et les data vous parviennent rapidement. Aujourd’hui, ScraperAPI est adopté par des milliers d’utilisateurs.

📌 Her er en tabel, der opsummerer styrker og svagheder ved ScraperAPI ifølge brugerne:

| ✔️ Højdepunkter | ❌ Svage punkter |

|---|---|

| Effektiv omgåelse af CAPTCHA'er | Uklar prissætning |

| Automatisk og effektiv styring af fuldmagter | Lejlighedsvise begrænsninger på gennemstrømning og anmodninger |

| Pålidelig JavaScript-rendering | Ikke egnet til meget store mængder |

| Understøttelse af flere sprog | Avanceret dokumentation kan forbedres |

| Facilité d’intégration et API simple |

Global mening om ScraperAPI

Brugerne opsummerer ScraperAPI med tre ord: hurtig, pålidelig, effektiv.

D’après tous les avis récoltés sur Trustpilot, G2 et Capterra, ScraperAPI présente une note moyenne de :

4,6 ⭐⭐⭐⭐⭐

| 📊 Platform | ⭐ Score ud af 5 |

|---|---|

| Trustpilot | 4,7 |

| G2 | 4,4 |

| Capterra | 4,6 |

✔️ Ofte citerede styrker :

- Pålidelig og effektiv skrabning

- Facilité d’utilisation et d’intégration

- Enestående kundesupport

- Værdi for pengene

- Specifikke og avancerede funktioner

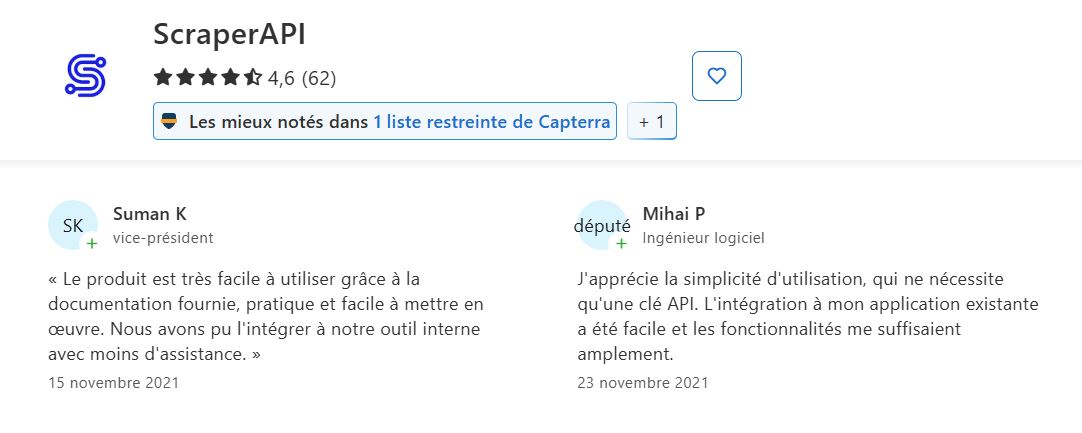

➡️ Ifølge Suman K og Mihai P på Capterra:

“Le produit est très facile à utiliser grâce à la documentation fournie, pratique et facile à mettre en œuvre…”

“J’apprécie la simplicité d’utilisation, qui ne nécessite qu’une clé API. L’intégration à mon application existante a été facile et les fonctionnalités me suffisaient amplement.”

➡️ Akif bekræfter på Trustpilot :

“Leur service client est excellent…”

➡️ Tilbagevenden af Muhammad H. på G2:

“Il simplifie le web scraping en gérant la gestion des proxys, les CAPTCHAs et le rendu du navigateur, me permettant de me concentrer sur l’extraction de données plutôt que sur les problèmes techniques. L’API s’intègre parfaitement dans mon code existant, et la vitesse est impressionnante, même pour des projets à grande échelle.”

❌ Udfordringer og svagheder, som brugerne har bemærket:

- Klarhed over priser og opfattede omkostninger Prissystemet: Brugerne er nogle gange forvirrede over priserne.

- Dokumentation skal forbedres for avanceret funktionalitet.

- Lejlighedsvise problemer med flowbegrænsning/forespørgselsfejl.

- Støtte til kvalitet.

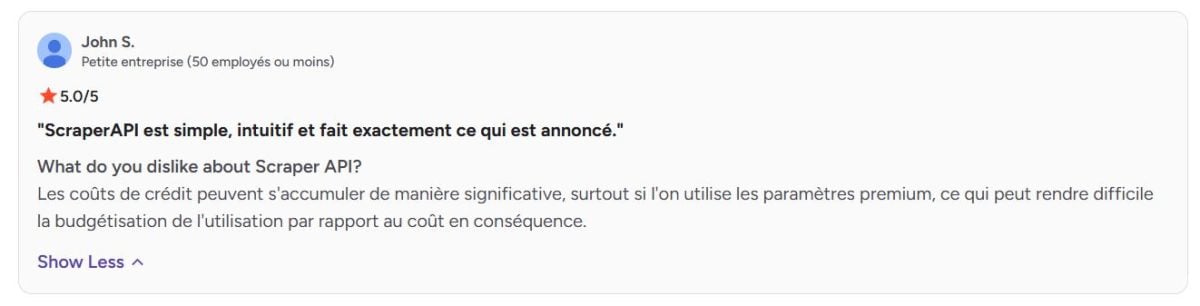

➡️ Ifølge John S. på G2 :

“Les coûts de crédit peuvent s’accumuler de manière significative, surtout si l’on utilise les paramètres premium, ce qui peut rendre difficile la budgétisation de l’utilisation par rapport au coût en conséquence.”

Udtalelse om de tjenester, der tilbydes af ScraperAPI

Få mere at vide om ScraperAPI's vigtigste tjenester, og hvad brugerne har at sige.

1. Automatisk rotation af proxyer

ScraperAPI dispose d’un vaste pool de proxys qu’il fait pivoter automatiquement à chaque requête.

➡️ Ifølge Aditya Pratap Singh på Trustpilot :

“ScraperAPI a révolutionné mes projets de web scraping. J’étais constamment aux prises avec des CAPTCHA et des blocages d’adresses IP avant de trouver ce service. Maintenant, je peux me concentrer sur l’utilisation des données au lieu de me battre pour les obtenir. La rotation du proxy est fluide et j’apprécie la gestion automatique du rendu JavaScript.”

2. Håndtering af bypass-beskyttelse

L’outil sait contourner les mécanismes anti-bot complexes, les pare-feu, les CAPTCHA et autres restrictions d’accès, ce qui garantit une extraction fluide, même sur des sites très protégés.

➡️ D’après Arun K.en forskningsmedarbejder:

“Google a réussi à bloquer les requêtes programmatiques, même à des fins non commerciales et d’auto-archivage, et ScraperAPI s’est montré extrêmement efficace pour les contourner. Bien que le routage des requêtes via ScraperAPI soit beaucoup plus lent que, par exemple, via un serveur proxy gratuit.”

3. JavaScript-rendering

Takket være en integreret headless-browser kan ScraperAPI scrape dynamiske websteder, hvis indhold indlæses via JavaScript.

➡️ Tilbagevenden af Fazt Tech på Trustpilot :

“ScraperAPI a considérablement amélioré nos processus de scraping web. L’API est simple à intégrer et prend en charge la plupart des tâches lourdes, comme la rotation des adresses IP et la gestion des proxys, ce qui nous fait gagner un temps précieux. La gestion automatique des captchas est un atout majeur et simplifie considérablement notre collecte de données.”

4. Tilpasning af forespørgsler

HTTP-anmodninger kan tilpasses ved at ændre headers, cookies eller user-agents, hvilket hjælper med at simulere forskellig adfærd og undgå at blive opdaget.

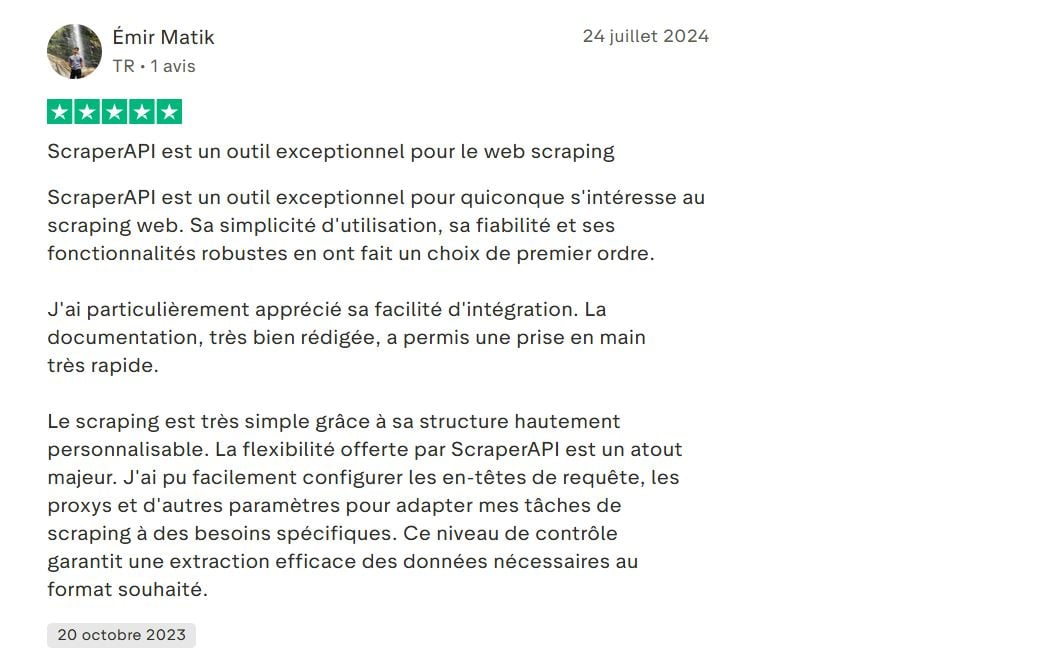

➡️ Voici l’avis de Emir Matik på Trustpilot :

“…Le scraping est très simple grâce à sa structure hautement personnalisable. La flexibilité offerte par ScraperAPI est un atout majeur. J’ai pu facilement configurer les en-têtes de requête, les proxys et d’autres paramètres pour adapter mes tâches de scraping à des besoins spécifiques…”

5. Geolokalisering af fuldmagter

ScraperAPI offre la possibilité de choisir l’emplacement géographique des proxys (par pays). Cela s’avère utile pour récupérer des données localisées ou pour tester des résultats spécifiques à une région.

➡️ Tilbagevenden af Melih Krs på Trustpilot :

“…De plus, sa prise en charge du rendu JavaScript et de la géolocalisation IP a été précieuse…”

6. Dashboard og statistik

Un tableau de bord complet permet de suivre l’utilisation, le nombre de requêtes, le taux de réussite et les crédits restants. Cela facilite la gestion et l’optimisation du scraping.

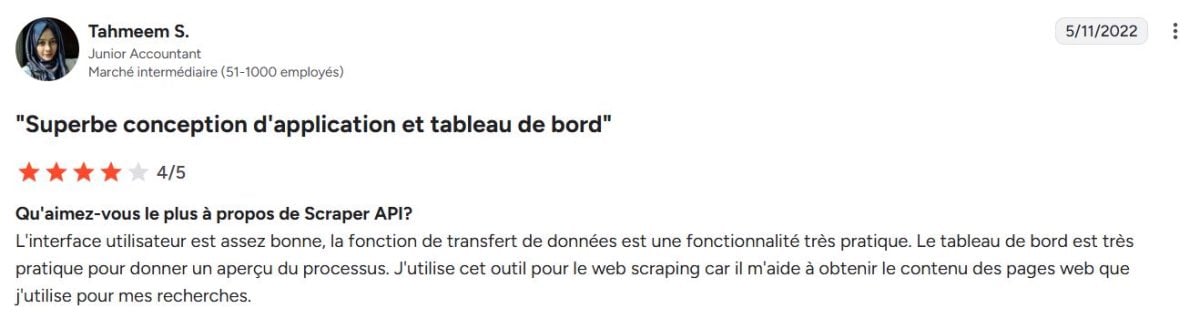

➡️ Ifølge Tahmeem S. på G2:

“L’interface utilisateur est assez bonne, la fonction de transfert de données est une fonctionnalité très pratique. Le tableau de bord est très pratique pour donner un aperçu du processus. J’utilise cet outil pour le web scraping car il m’aide à obtenir le contenu des pages web que j’utilise pour mes recherches.”

7. Integration og understøttelse af flere sprog

ScraperAPI tilbyder et simpelt REST API, der nemt kan integreres med flere sprog (Python, Node.js, PHP, Java osv.), hvilket gør det nemt at anvende i forskellige miljøer.

➡️ Her er, hvad der står Deni H. på G2:

“L’expérience pour l’API Scraper est probablement celle d’un développeur expérimenté en scraping web avec des connaissances de diverses technologies de scraping, y compris Python (BeautifulSoup et Selenium), JavaScript (Puppeteer ou Cheerio), et Node.js (Demand et Cheerio)…”

8. Avancerede funktioner til data

- Asynkron scraping-tjeneste : permet d’envoyer des millions de requêtes de manière asynchrone pour des besoins de scraping à très grande échelle.

- Strukturerede data direkte output i JSON eller CSV for at lette databehandlingen.

- DataPipeline Datahentning: komplet automatisering uden kodning til kontinuerlig datahentning.

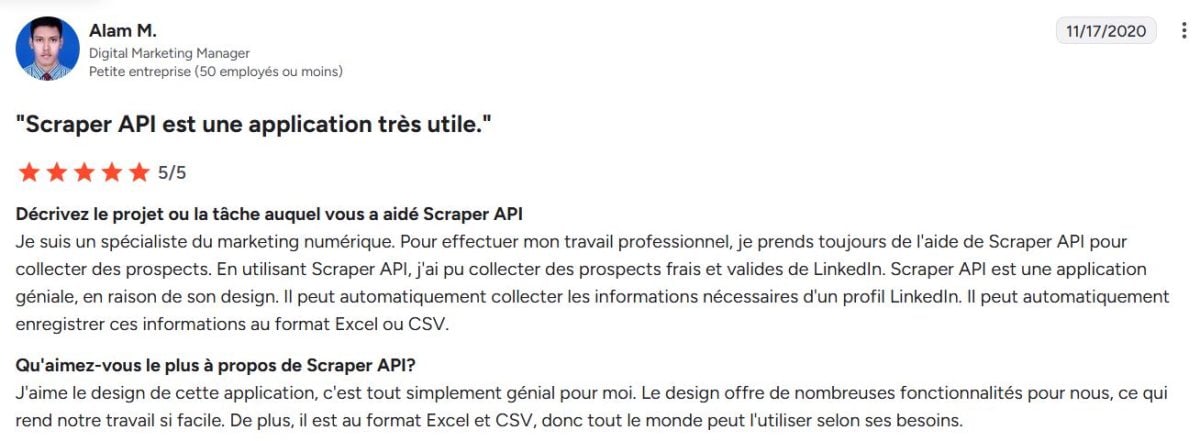

➡️ Ifølge Alam M.Digital Marketing Manager hos G2 :

“…Il peut automatiquement enregistrer ces informations au format Excel ou CSV…”

ScraperAPI : Alternativer

ScraperAPI n’est pas le seul acteur sur le marché du web scraping. Plusieurs alternatives se distinguent par leurs approches, leurs prix ou leurs fonctionnalités :

- Lyse data den mest omfattende webdataplatform.

- ScrapingBee den største konkurrent til ScraperAPI.

- Oktoparse Visuel tilgang uden kode.

- Apify Scrapper-udviklingsplatform.

| 🌐 Værktøj | 📌 Særlig funktion | 💬Brugeranmeldelser | ⭐Gennemsnitlig vurdering |

|---|---|---|---|

| ScraperAPI | Automatisk rotation af proxyer, JavaScript-rendering, tilpasning | Fiable et simple d’utilisation, mais parfois confuse sur la tarification | 4,6 |

| Lyse data | Den mest omfattende platform med førsteklasses proxyer og avanceret datapipeline | Meget kraftfuld og fleksibel, men kompleks at bruge | 4,6 |

| ScrapingBee | Enkel API med JS-rendering og proxy-rotation | Facile à intégrer et bon rapport qualité/prix, mais moins d’options avancées | 4,9 |

| Oktoparse | Visuel scraping uden kode, en programmeringsfri tilgang | Ideel til ikke-tekniske brugere, men begrænset til store mængder | 4,4 |

| Apify | Platform til udvikling af brugerdefinerede scrapere | Meget fleksibel og tilpasningsdygtig, men kræver et højt niveau af teknisk ekspertise | 4,8 |

ScraperAPI er en populær og afbalanceret løsning. Selvom flere alternativer tilbyder interessante løsninger tilpasset forskellige profiler, Lyse data forbliver den web-dataplatform den mest komplette og kraftfulde på markedet.

Bright Datas rating er nogle gange lidt lavere på grund af dens Førsteklasses positionering som ikke er egnet til alle brugere.

➡️ Niklas siger Capterra:

“Bright Data est un service plus cher mais le meilleur de sa catégorie.”

Ofte stillede spørgsmål

Er ScraperAPI gratis?

ScraperAPI er ikke gratis, men tilbyder en Gratis prøveversion begrænset.

Hvor meget koster ScraperAPI?

ScraperAPI-priserne ligger generelt fra 49$ og 475$ om måneden.

Hvordan fungerer ScraperAPI?

Teknisk set fungerer ScraperAPI som en Mellemliggende entre votre application et les sites web à scraper. Il gère automatiquement la rotation des proxys, la gestion des IP, le rendu JavaScript et le contournement des protections. L’outil vous permet de Gendan data uden at blokere.

Hvordan bruger jeg ScraperAPI med Python?

L’intégration avec Python est simple grâce à une API REST bien documentée. Il suffit d’envoyer une requête HTTP à l’adresse de l’API de ScraperAPI avec votre clé API et l’URL cible.

1. Définir l’URL ScraperAPI avec votre clé API et l’URL cible

importanmodninger

url = "http://api.scraperapi.com"

params = {

'api_key': 'YOUR_API_CLE',

'url': 'https://exemple.com'

}2. Send anmodningen

response = requests.get(url, params=params)3. Vis indholdet af den hentede side

print(svar.tekst)Kan ScraperAPI omgå CAPTCHA'er?

Ja. L’un des points forts de ScraperAPI est sa capacité à contourner automatiquement les CAPTCHA et d’autres systèmes anti-bot.

🔚 Pour tout résumer, ScraperAPI s’impose comme une solution performante pour automatiser la collecte de données en ligne. Mais pour un service plus complet, Bright Data est l’option idéale.

N’hésitez pas à poser vos questions en commentaire et à partager votre expérience !