Mit ScraperAPIkönnen Sie CAPTCHAs, Proxys und gesperrte IPs vergessen. Mit dieser API von Web ScrapingSie müssen nur eine Anfrage senden und die Daten erreichen Sie schnell. Heute wird ScraperAPI von Tausenden von Anwendern eingesetzt.

📌 Hier ist eine zusammenfassende Tabelle mit den Stärken und Schwächen von ScraperAPI aus Sicht der Nutzer :

| ✔️ Stärken | ❌ Schwächen |

|---|---|

| Effektive Umgehung von CAPTCHAs | Unklare Preisgestaltung |

| Automatische und effiziente Verwaltung von Proxys | Gelegentliche Einschränkungen von Datenübertragungen und Abfragen |

| Zuverlässiges JavaScript-Rendering | Wenig geeignet für sehr große Mengen |

| Mehrsprachige Unterstützung | Verbesserungswürdige erweiterte Dokumentation |

| Einfache Integration und einfache API |

Allgemeine Meinung zu ScraperAPI

Die Nutzer fassen ScraperAPI in drei Worten zusammen: schnell, zuverlässig, Wirksam.

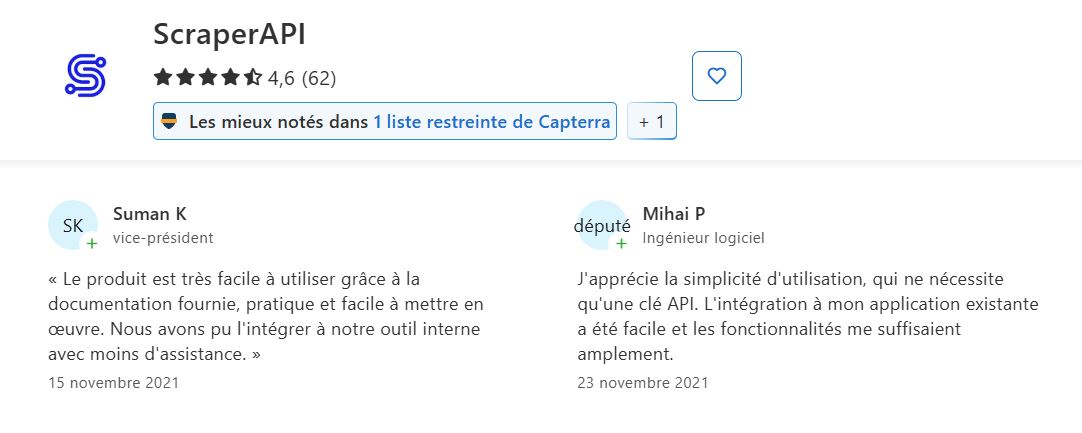

Auf der Grundlage der Bewertungen auf Trustpilot, G2 und Capterra hat ScraperAPI eine durchschnittliche Bewertung von :

4,6 ⭐⭐⭐⭐⭐

| 📊 Plattform | ⭐ Note von 5 |

|---|---|

| Trustpilot | 4,7 |

| G2 | 4,4 |

| Capterra | 4,6 |

✔️ Häufig genannte Stärken :

- Zuverlässigkeit und Effektivität des Scrapings

- Einfache Nutzung und Integration

- Hervorragender Kundensupport

- Preis-Leistungs-Verhältnis

- Spezifische und erweiterte Funktionen

➡️ Nach Suman K und Mihai P auf Capterra :

"Das Produkt ist dank der mitgelieferten Dokumentation sehr benutzerfreundlich, praktisch und einfach zu implementieren..."

"Ich schätze die einfache Bedienung, für die man nur einen API-Schlüssel benötigt. Die Integration in meine bestehende Anwendung war einfach und die Funktionen haben mir völlig ausgereicht."

➡️ Akif bestätigt auf Trustpilot :

"Ihr Kundenservice ist hervorragend ..."

➡️ Hier kommt die Rückkehr von Muhammad H. auf G2 :

"Es vereinfacht das Web-Scraping, indem es die Verwaltung von Proxys, CAPTCHAs und Browser-Rendering übernimmt, sodass ich mich auf die Datenextraktion konzentrieren kann, anstatt mich mit technischen Problemen herumzuschlagen. Die API fügt sich nahtlos in meinen bestehenden Code ein, und die Geschwindigkeit ist beeindruckend, selbst bei großen Projekten."

❌ Die von den Nutzern bewerteten Herausforderungen und Schwächen :

- Klarheit der Preisgestaltung und wahrgenommene Kosten : Die Nutzer sind manchmal verwirrt, was die Preisgestaltung angeht.

- Verbesserungswürdige Dokumentation für erweiterte Funktionen.

- Gelegentliche Probleme mit Begrenzung des Durchsatzes/fehlgeschlagene Abfragen.

- Qualität der Unterstützung.

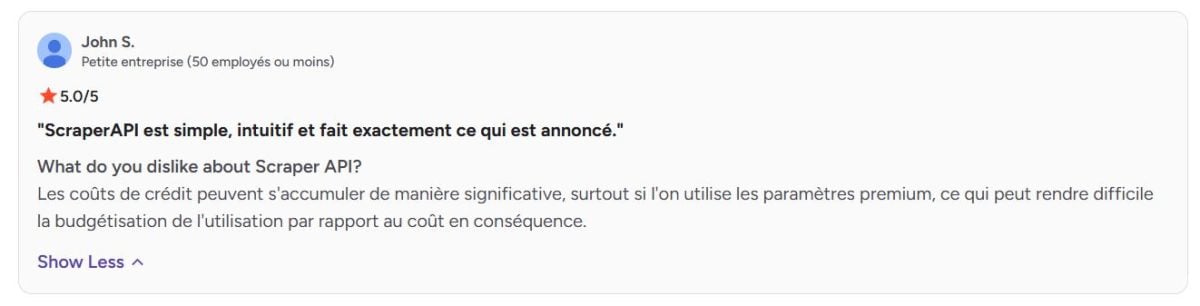

➡️ Nach John S. auf G2 :

"Die Kreditkosten können sich erheblich summieren, insbesondere wenn man die Premium-Einstellungen nutzt, was die Budgetierung der Nutzung im Verhältnis zu den Kosten entsprechend erschweren kann."

Meinungen zu den von ScraperAPI angebotenen Diensten

Erfahren Sie mehr über die Schlüsseldienste von ScraperAPI und was die Benutzer darüber denken.

1. Automatische Rotation von Proxys

ScraperAPI verfügt über einen großen Pool von Proxys, die es bei jeder Anfrage automatisch rotiert.

➡️ Nach Aditya Pratap Singh auf Trustpilot :

"ScraperAPI hat meine Web-Scraping-Projekte revolutioniert. Ich hatte ständig mit CAPTCHAs und IP-Sperrungen zu kämpfen, bevor ich diesen Dienst fand. Jetzt kann ich mich darauf konzentrieren, die Daten zu nutzen, anstatt darum zu kämpfen, sie zu bekommen. Die Proxy-Rotation ist flüssig und ich schätze die automatische Verwaltung des JavaScript-Renderings".

2. Verwaltung der Schutzumgehung (Bypass)

Das Tool kann komplexe Anti-Bot-Mechanismen, Firewalls, CAPTCHAs und andere Zugangsbeschränkungen umgehen, sodass selbst auf streng geschützten Websites ein reibungsloser Abruf gewährleistet ist.

➡️ Nach Arun K.ein assoziierter Forscher :

"Google hat es geschafft, programmatische Anfragen auch für nicht-kommerzielle Zwecke und zur Selbstarchivierung zu blockieren, und ScraperAPI hat sich als äußerst effektiv erwiesen, um diese zu umgehen. Obwohl das Routing von Anfragen über ScraperAPI viel langsamer ist als beispielsweise über einen kostenlosen Proxyserver".

3. JavaScript-Rendering

Mithilfe eines integrierten Headless Browsers kann ScraperAPI dynamische Websites scrapen, deren Inhalte über JavaScript geladen werden.

➡️ Hier kommt die Rückkehr von Fazt Tech auf Trustpilot :

"ScraperAPI hat unsere Web-Scraping-Prozesse erheblich verbessert. Die API ist einfach zu integrieren und übernimmt die meisten schwerfälligen Aufgaben, wie die Rotation von IP-Adressen und die Verwaltung von Proxys, was uns wertvolle Zeit spart. Die automatische Verwaltung von Captchas ist ein großer Vorteil und vereinfacht unsere Datenerfassung erheblich."

4. Anpassen von Abfragen

Es ist möglich, HTTP-Anfragen durch Änderung von Headern, Cookies oder User-Agents anzupassen, was dabei hilft, verschiedene Verhaltensweisen zu simulieren und eine Entdeckung zu verhindern.

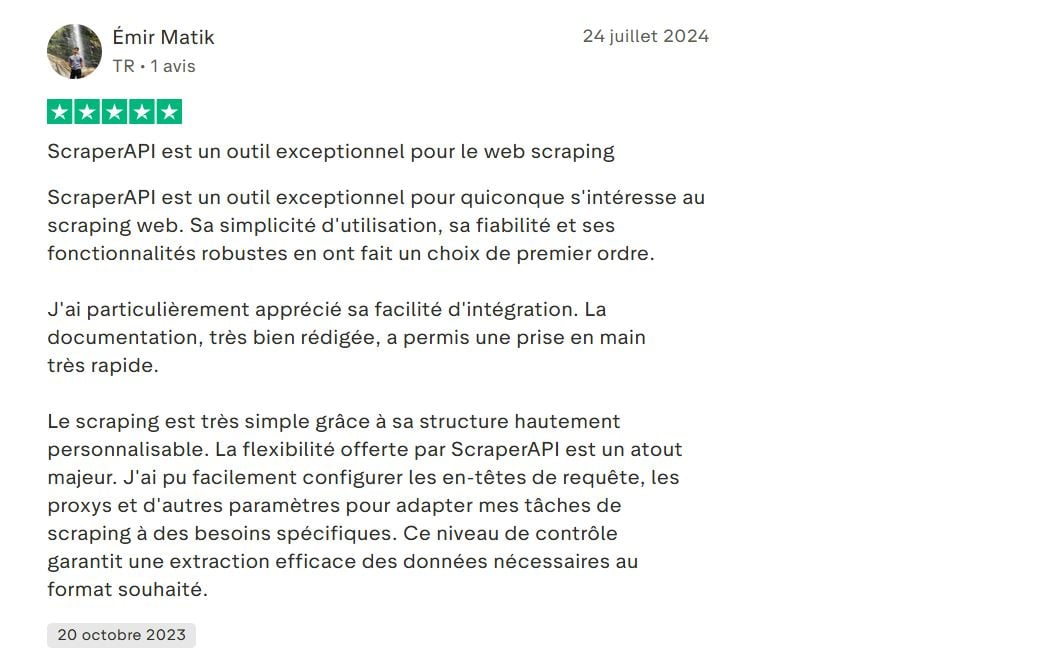

➡️ Hier ist die Meinung von Emir Matik auf Trustpilot :

"...Scraping ist dank der hochgradig anpassbaren Struktur sehr einfach. Die von ScraperAPI gebotene Flexibilität ist ein großer Vorteil. Ich konnte Abfrageköpfe, Proxys und andere Parameter einfach konfigurieren, um meine Scraping-Aufgaben an spezifische Bedürfnisse anzupassen...".

5. Geolokalisierung von Proxys

ScraperAPI bietet die Möglichkeit, den geografischen Standort der Proxys (nach Ländern) auszuwählen. Dies ist nützlich, um lokalisierte Daten abzurufen oder um regionalspezifische Ergebnisse zu testen.

➡️ Hier kommt die Rückkehr von Melih Krs auf Trustpilot :

"...Darüber hinaus war seine Unterstützung für JavaScript-Rendering und IP-Geolocation wertvoll...".

6. Anzeiger und Statistiken

In einem umfassenden Dashboard können Sie die Nutzung, die Anzahl der Anfragen, die Erfolgsquote und die verbleibenden Credits verfolgen. Dies erleichtert die Verwaltung und Optimierung des Scrapings.

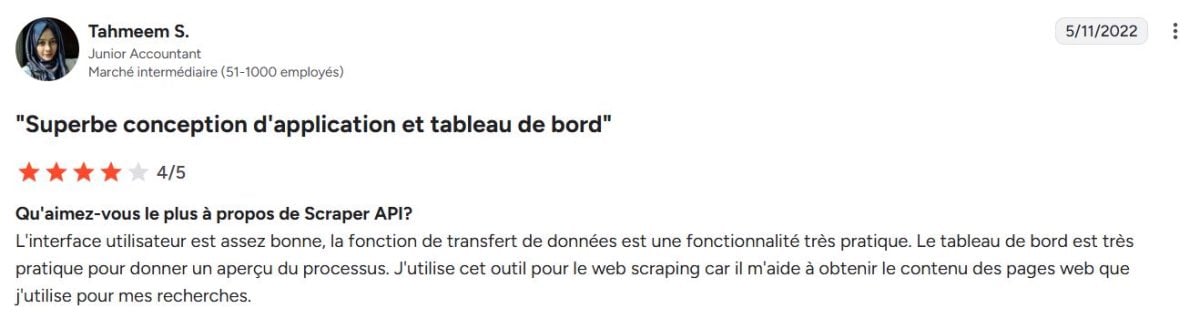

➡️ Nach Tahmeem S. auf G2 :

"Die Benutzeroberfläche ist ziemlich gut, die Datenübertragungsfunktion ist ein sehr praktisches Feature. Das Dashboard ist sehr praktisch, um einen Überblick über den Prozess zu geben. Ich verwende dieses Tool für das Web-Scraping, da es mir hilft, den Inhalt der Webseiten zu erhalten, die ich für meine Recherchen verwende".

7. Mehrsprachige Integration und Unterstützung

ScraperAPI bietet eine einfache REST-API, die sich leicht in verschiedene Sprachen (Python, Node.js, PHP, Java usw.) integrieren lässt, was die Übernahme in verschiedene Umgebungen erleichtert.

➡️ Das sagt Deni H. auf G2 :

"Die Erfahrung für die Scraper-API ist wahrscheinlich die eines erfahrenen Web-Scraping-Entwicklers mit Kenntnissen in verschiedenen Scraping-Technologien, einschließlich Python (BeautifulSoup und Selenium), JavaScript (Puppeteer oder Cheerio) und Node.js (Demand und Cheerio)...".

8. Erweiterte Funktionen für Daten

- Asynchroner Scraping-Dienst : ermöglicht das asynchrone Senden von Millionen von Anfragen für Scraping-Anforderungen in sehr großem Umfang.

- Strukturierte Daten : Direkte Ausgabe in JSON oder CSV, um die Verarbeitung der Daten zu erleichtern.

- DataPipeline : Vollständige Automatisierung ohne Codierung, um kontinuierlich Daten abzurufen.

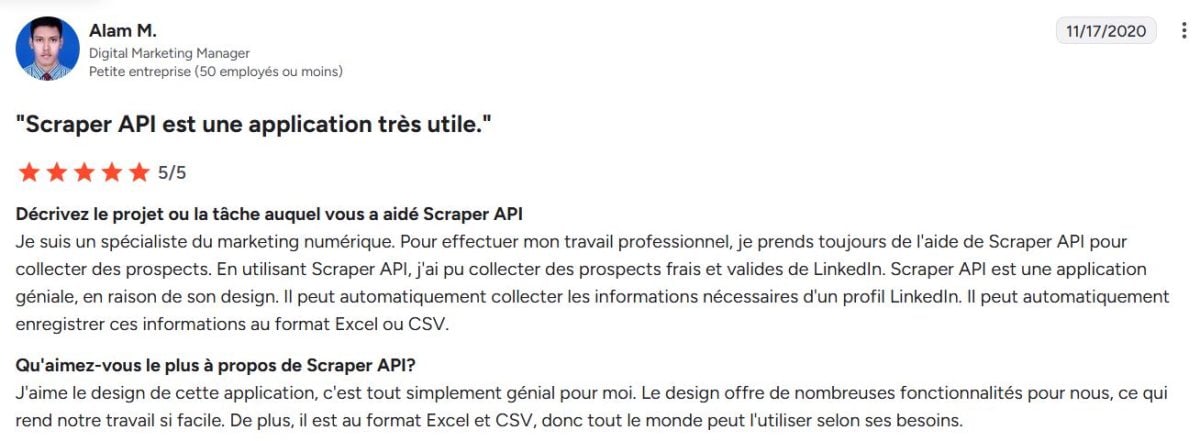

➡️ Nach Alam M.Ein Digital Marketing Manager auf G2 :

"...Er kann diese Informationen automatisch im Excel- oder CSV-Format speichern...".

ScraperAPI: Alternativen

ScraperAPI ist nicht der einzige Akteur auf dem Markt für Web Scraping. Mehrere Alternativen unterscheiden sich durch ihre Ansätze, Preise oder Funktionen:

- Bright Data : die umfassendste webbasierte Datenplattform.

- ScrapingBee : der Hauptkonkurrent von ScraperAPI.

- Octoparse : visueller Ansatz ohne Code.

- Apify : Plattform für die Entwicklung von Scrapern.

| 🌐 Werkzeug | 📌 Besonderheit | 💬Benutzermeinungen | ⭐Durchschnittsnote |

|---|---|---|---|

| ScraperAPI | Proxys automatisch drehen, JavaScript-Rendering, Anpassen | Zuverlässig und einfach zu bedienen, aber manchmal verwirrend in Bezug auf die Preisgestaltung | 4,6 |

| Bright Data | Umfassendste Plattform mit Premium-Proxys und erweiterter Datenpipeline | Sehr leistungsstark und flexibel, aber komplex in der Handhabung | 4,6 |

| ScrapingBee | Einfache API mit JS-Rendering und Proxy-Rotation | Einfach zu integrieren und gutes Preis-Leistungs-Verhältnis, aber weniger erweiterte Optionen | 4,9 |

| Octoparse | Visuelles Scraping ohne Code, Ansatz ohne Programmierung | Ideal für Nicht-Techniker, aber auf große Mengen beschränkt | 4,4 |

| Apify | Plattform für die Entwicklung maßgeschneiderter Scraper | Sehr flexibel und anpassbar, erfordert jedoch hohe technische Fähigkeiten | 4,8 |

ScraperAPI ist eine beliebte und ausgewogene Lösung. Obwohl mehrere Alternativen interessante Lösungen bieten, die für verschiedene Profile geeignet sind, Bright Data bleibt die webbasierte Datenplattform die umfassendste und leistungsstärkste auf dem Markt.

Die Bewertung von Bright Data ist manchmal etwas niedriger aufgrund seiner Premium-Positionierung die nicht auf alle Nutzer zutrifft.

➡️ Niklas auf Capterra bestätigen:

"Bright Data ist ein teurerer Dienst, aber der beste in seiner Klasse".

Häufig gestellte Fragen

Ist ScraperAPI ein kostenloses Tool?

ScraperAPI ist kostenpflichtig, bietet aber einen kostenlose Probe begrenzt.

Wie viel kostet ScraperAPI?

Die Preise für ScraperAPI liegen in der Regel zwischen 49$ und 475$ pro Monat.

Wie funktioniert ScraperAPI?

Technisch gesehen agiert ScraperAPI wie ein Intermediär zwischen Ihrer Anwendung und den zu scrapenden Webseiten. Es verwaltet automatisch die Proxy-Rotation, die IP-Verwaltung, das JavaScript-Rendering und die Umgehung von Schutzmechanismen. Das Tool ermöglicht Ihnen Daten ohne Sperrung wiederherstellen.

Wie kann ich ScraperAPI mit Python verwenden?

Die Integration mit Python ist dank einer gut dokumentierten REST-API einfach. Senden Sie einfach eine HTTP-Anfrage an die Adresse der ScraperAPI mit Ihrem API-Schlüssel und der Ziel-URL.

1. Definieren Sie die ScraperAPI-URL mit Ihrem API-Schlüssel und der Ziel-URL

import requests

url = "http://api.scraperapi.com"

params = {

'api_key': 'YOUR_CLE_API',

'url': 'https://exemple.com'

}2. Senden Sie die Anfrage

response = requests.get(url, params=params)3. Zeigen Sie den Inhalt der abgerufenen Seite an

print(response.text)Kann ScraperAPI CAPTCHAs umgehen?

Ja. Eine der Stärken von ScraperAPI ist seine Fähigkeit, CAPTCHA und andere Anti-Bot-Systeme automatisch zu umgehen.

🔚 Zusammenfassend lässt sich sagen, dass ScraperAPI sich als leistungsfähige Lösung zur Automatisierung der Online-Datenerhebung durchsetzt. Allerdings für einen umfassenderen Service, Bright Data ist die ideale Option.

Zögern Sie nicht, Ihre Fragen als Kommentar zu stellen und Ihre Erfahrungen zu teilen!