Com API do raspadorPode esquecer os CAPTCHAs, os proxies e os IPs bloqueados. Com esta API da raspagem da web, basta enviar um pedido e os dados cheguem rapidamente até si. Atualmente, o ScraperAPI é utilizado por milhares de utilizadores.

Eis um quadro que resume os pontos fortes e fracos da ScraperAPI de acordo com os utilizadores:

| ✔️ Destaques | Pontos fracos |

|---|---|

| Contornar eficazmente os CAPTCHAs | Preços pouco claros |

| Gestão automática e eficiente de proxies | Restrições ocasionais ao débito e aos pedidos |

| Renderização fiável de JavaScript | Não é adequado para volumes muito grandes |

| Suporte multilingue | A documentação avançada poderia ser melhorada |

| Facilidade de integração e API simples |

Opinião global sobre a ScraperAPI

Os utilizadores resumem o ScraperAPI em três palavras: velozes, fiável, eficaz.

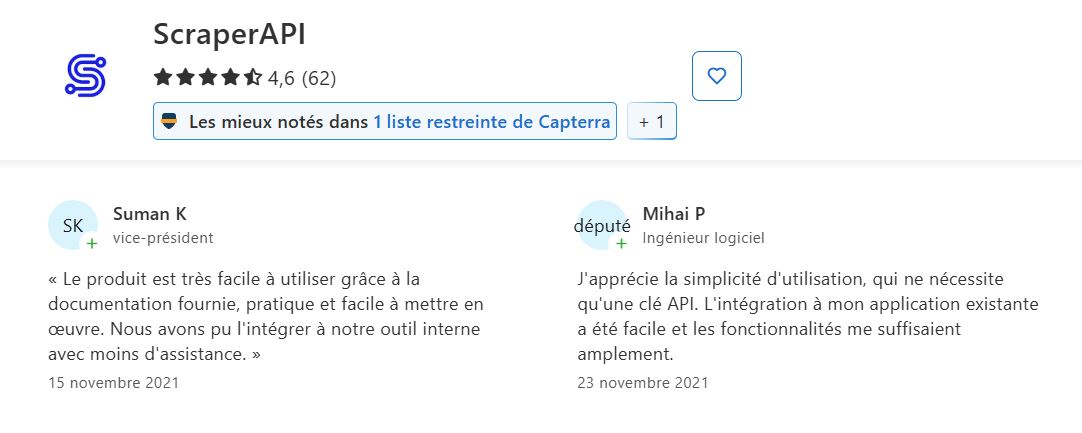

De acordo com todas as avaliações recolhidas no Trustpilot, G2 e Capterra, o ScraperAPI apresenta uma nota média de:

4,6 ⭐⭐⭐⭐⭐

| 📊 Plataforma | ⭐ Pontuação de 5 |

|---|---|

| Trustpilot | 4,7 |

| G2 | 4,4 |

| Capterra | 4,6 |

✔️ Pontos fortes citados com frequência :

- Fiabilidade e eficiência da raspagem

- Facilidade de utilização e integração

- Apoio ao cliente excecional

- Custo-benefício

- Funcionalidades específicas e avançadas

➡️ De acordo com Suman K e Mihai P em Capterra :

“O produto é muito fácil de usar graças à documentação fornecida, prática e fácil de implementar…”

“Gosto da facilidade de utilização, que requer apenas uma chave API. A integração na minha aplicação existente foi fácil e as funcionalidades foram mais do que suficientes para mim.”

➡️ Akif confirma na Trustpilot :

“O atendimento ao cliente deles é excelente…”

➡️ O regresso de Muhammad H. no G2 :

“Simplifica o web scraping ao gerir proxies, CAPTCHAs e renderização do navegador, permitindo-me concentrar-me na extração de dados em vez de problemas técnicos. A API integra-se perfeitamente no meu código existente e a velocidade é impressionante, mesmo para projetos de grande escala.”

Desafios e pontos fracos assinalados pelos utilizadores:

- Clareza dos preços e perceção dos custos O sistema de preços: por vezes, os utilizadores confundem-se com os preços.

- Documentação a melhorar para funcionalidades avançadas.

- Problemas ocasionais com limitação de fluxo/falhas de consulta.

- Qualidade do apoio.

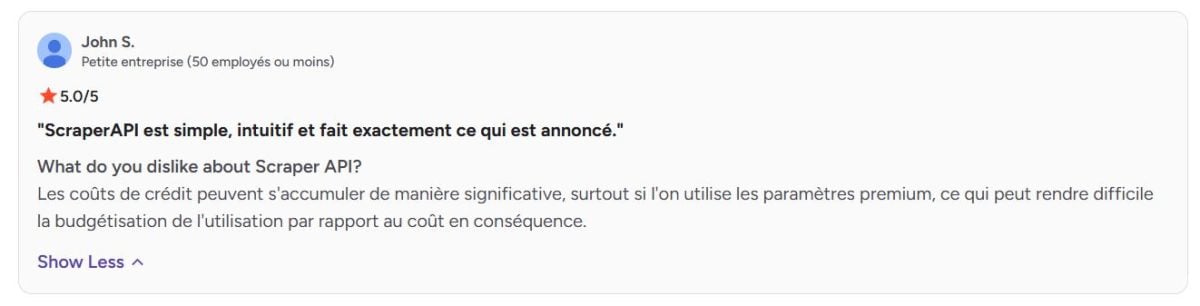

➡️ De acordo com João S. no G2 :

“Os custos de crédito podem acumular-se significativamente, especialmente se forem utilizados parâmetros premium, o que pode dificultar o orçamento da utilização em relação ao custo consequente.”

Opinião sobre os serviços oferecidos pela ScraperAPI

Saiba mais sobre os principais serviços da ScraperAPI e o que os utilizadores têm a dizer.

1. Rotação automática de proxies

O ScraperAPI dispõe de um vasto conjunto de proxies que alterna automaticamente a cada solicitação.

➡️ De acordo com Aditya Pratap Singh na Trustpilot :

“O ScraperAPI revolucionou os meus projetos de web scraping. Eu estava constantemente a lidar com CAPTCHAs e bloqueios de endereços IP antes de encontrar este serviço. Agora, posso concentrar-me em usar os dados em vez de lutar para obtê-los. A rotação do proxy é fluida e aprecio a gestão automática da renderização JavaScript.”

2. Gestão da proteção contra desvios

A ferramenta sabe contornar mecanismos anti-bot complexos, firewalls, CAPTCHAs e outras restrições de acesso, garantindo uma extração fluida, mesmo em sites altamente protegidos.

➡️ De acordo com Arun K.um investigador associado :

“O Google conseguiu bloquear as solicitações programáticas, mesmo para fins não comerciais e de autoarquivamento, e o ScraperAPI mostrou-se extremamente eficaz para contorná-las. Embora o encaminhamento das solicitações através do ScraperAPI seja muito mais lento do que, por exemplo, através de um servidor proxy gratuito.”

3. Renderização JavaScript

Graças a um navegador sem cabeça integrado, o ScraperAPI pode fazer scraping de sites dinâmicos cujo conteúdo é carregado através de JavaScript.

➡️ O regresso de Fazt Tech na Trustpilot :

“A ScraperAPI melhorou consideravelmente os nossos processos de scraping na web. A API é fácil de integrar e suporta a maioria das tarefas pesadas, como a rotação de endereços IP e a gestão de proxies, o que nos poupa um tempo precioso. A gestão automática de captchas é uma grande vantagem e simplifica consideravelmente a nossa recolha de dados.”

4. Personalizar as consultas

Os pedidos HTTP podem ser personalizados através da modificação de cabeçalhos, cookies ou agentes do utilizador, o que ajuda a simular diferentes comportamentos e a evitar a deteção.

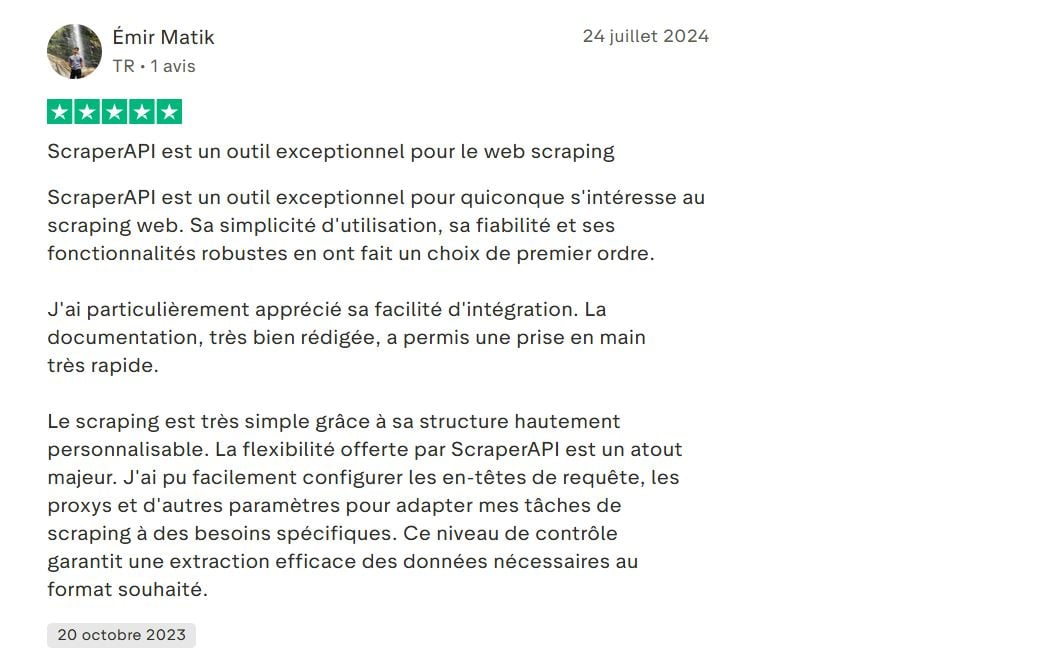

➡️ Aqui está a opinião de Emir Matik na Trustpilot :

“…O scraping é muito simples graças à sua estrutura altamente personalizável. A flexibilidade oferecida pelo ScraperAPI é uma grande vantagem. Consegui configurar facilmente os cabeçalhos de solicitação, proxies e outros parâmetros para adaptar as minhas tarefas de scraping a necessidades específicas…”

5. Geolocalização de proxies

A ScraperAPI oferece a possibilidade de escolher a localização geográfica dos proxies (por país). Isso é útil para recuperar dados localizados ou para testar resultados específicos de uma região.

➡️ O regresso de Melih Krs na Trustpilot :

“…Além disso, o seu suporte para renderização JavaScript e geolocalização IP foi muito valioso…”

6. Painel de controlo e estatísticas

Um painel completo permite acompanhar a utilização, o número de solicitações, a taxa de sucesso e os créditos restantes. Isso facilita a gestão e a otimização do scraping.

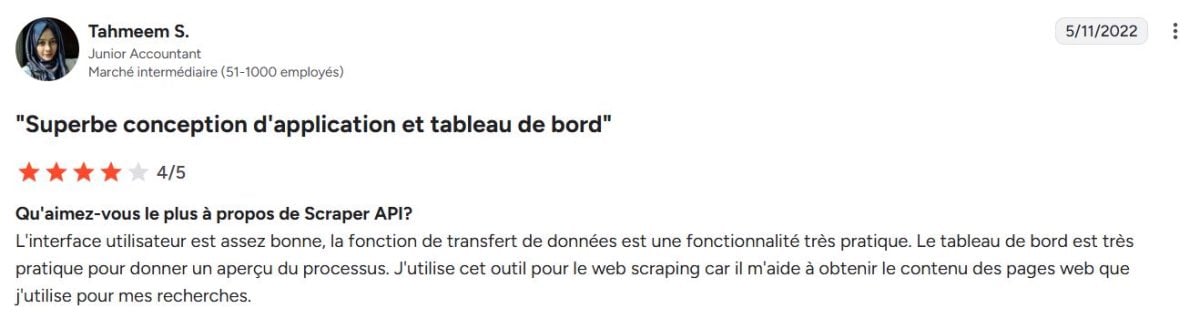

➡️ De acordo com Tahmeem S. no G2 :

“A interface do utilizador é bastante boa, a função de transferência de dados é uma funcionalidade muito prática. O painel de controlo é muito prático para dar uma visão geral do processo. Utilizo esta ferramenta para web scraping porque me ajuda a obter o conteúdo das páginas web que utilizo para as minhas pesquisas.”

7. Integração e suporte multilingue

O ScraperAPI oferece uma API REST simples que pode ser facilmente integrada com várias linguagens (Python, Node.js, PHP, Java, etc.), facilitando a sua adoção em diferentes ambientes.

➡️ Diz o seguinte Deni H. no G2 :

“A experiência necessária para a API Scraper é provavelmente a de um programador experiente em web scraping, com conhecimentos de várias tecnologias de scraping, incluindo Python (BeautifulSoup e Selenium), JavaScript (Puppeteer ou Cheerio) e Node.js (Demand e Cheerio)…”

8. Funcionalidades avançadas para dados

- Serviço de recolha de dados assíncrono : permite enviar milhões de solicitações de forma assíncrona para necessidades de scraping em grande escala.

- Dados estruturados saída direta em JSON ou CSV para facilitar o processamento de dados.

- Linha de dados Recuperação de dados: automatização completa sem codificação para recuperação contínua de dados.

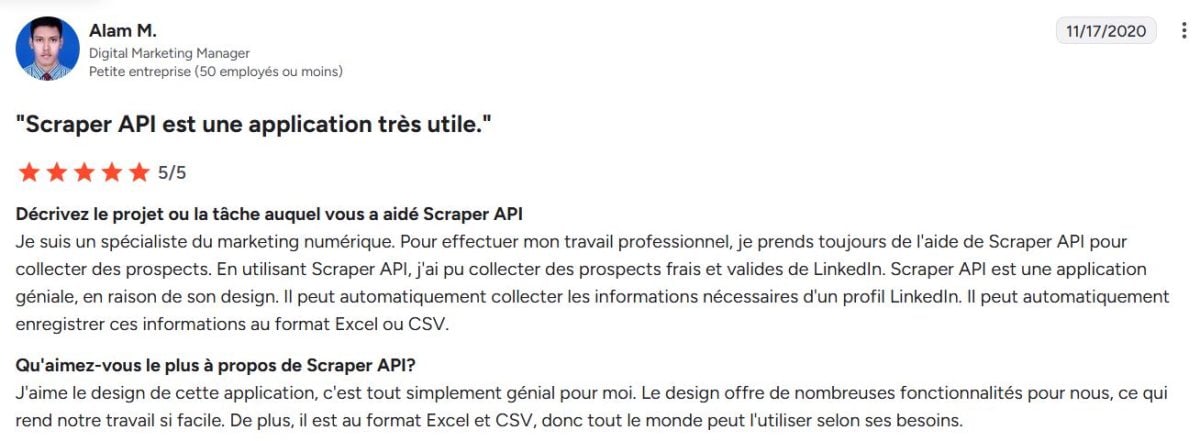

➡️ De acordo com Alam M.Diretor de Marketing Digital na G2 :

“…Ele pode gravar automaticamente essas informações no formato Excel ou CSV…”

ScraperAPI : Alternativas

A ScraperAPI não é a única empresa no mercado de web scraping. Existem várias alternativas que se distinguem pelas suas abordagens, preços ou funcionalidades:

- Dados brilhantes a mais completa plataforma de dados da Web.

- ScrapingBee o principal concorrente da ScraperAPI.

- Octoparse Abordagem visual sem código.

- Apify Plataforma de desenvolvimento do Scrapper.

| 🌐 Ferramenta | Caraterística especial | 💬Revisões dos utilizadores | Classificação média |

|---|---|---|---|

| API do raspador | Rotação automática de proxies, renderização JavaScript, personalização | Confiável e fácil de usar, mas às vezes confuso em relação aos preços | 4,6 |

| Dados brilhantes | A plataforma mais completa com proxies de primeira qualidade e um pipeline de dados avançado | Muito poderoso e flexível, mas de utilização complexa | 4,6 |

| ScrapingBee | API simples com renderização JS e rotação de proxy | Fácil de integrar e com boa relação qualidade/preço, mas menos opções avançadas | 4,9 |

| Octoparse | Visual scraping sem código, uma abordagem sem programação | Ideal para utilizadores não técnicos, mas limitado a grandes volumes | 4,4 |

| Apify | Plataforma para desenvolver scrapers personalizados | Altamente flexível e personalizável, mas requer um elevado nível de conhecimentos técnicos | 4,8 |

O ScraperAPI é uma solução popular e equilibrada. Embora várias alternativas ofereçam soluções interessantes adaptadas a diferentes perfis, Dados brilhantes continua a ser o plataforma de dados web o mais completo e potente do mercado.

A classificação da Bright Data é por vezes um pouco mais baixa devido à sua posicionamento premium o que não é adequado para todos os utilizadores.

➡️ Niklas afirma Capterra :

“A Bright Data é um serviço mais caro, mas é o melhor da sua categoria.”

Perguntas frequentes

O ScraperAPI é gratuito?

O ScraperAPI não é gratuito, mas oferece uma teste gratuito limitado.

Quanto custa o ScraperAPI?

Os preços da ScraperAPI variam geralmente entre 49$ e 475$ por mês.

Como é que a ScraperAPI funciona?

Tecnicamente, a ScraperAPI actua como um intermediário entre a sua aplicação e os sites a serem rastreados. Ele gerencia automaticamente a rotação de proxies, o gerenciamento de IPs, a renderização de JavaScript e a contornagem de proteções. A ferramenta permite que você recuperar dados sem bloquear.

Como é que utilizo a ScraperAPI com Python?

A integração com Python é simples graças a uma API REST bem documentada. Basta enviar uma solicitação HTTP para o endereço da API da ScraperAPI com a sua chave API e a URL de destino.

1. Defina a URL ScraperAPI com a sua chave API e a URL de destino

pedidos de importação

url = "http://api.scraperapi.com"

params = {

'api_key': 'SEU_API_CLE',

'url': 'https://exemple.com'

}2. Enviar o pedido

response = requests.get(url, params=params)3. Mostrar o conteúdo da página recuperada

print(response.text)A ScraperAPI pode contornar CAPTCHAs?

Sim. Um dos pontos fortes do ScraperAPI é a sua capacidade de contornar automaticamente CAPTCHAs e outros sistemas anti-bot.

🔚 Resumindo, o ScraperAPI se destaca como uma solução eficiente para automatizar a recolha de dados online. Mas para um serviço mais completo, A Bright Data é a opção ideal.

Não hesite em colocar as suas perguntas nos comentários e partilhar a sua experiência!