Эксклюзивный опрос IFOP для Alucare.fr.

Аналогичный предмет:

Определение Deepfake :

Deepfake - это технология синтеза изображений на основе искусственного интеллекта, позволяющая создавать или изменять видео и аудиозаписи с высокой степенью реалистичности. Эта технология использует методы глубокого обучения, в частности генеративные состязательные сети (GAN), для наложения и комбинирования изображений и звуков. Глубокие подделки часто используются для создания контента, в котором люди, как правило, знаменитости или общественные деятели, кажутся говорящими или делающими то, чего они на самом деле никогда не говорили и не делали.

Хотя глубокие подделки могут иметь законное применение в сфере развлечений или создания контента (например Candy.ai чтобы создать свою виртуальную девушку), они создают серьезные этические и юридические проблемы из-за их потенциала для дезинформации, манипулирования и вторжения в частную жизнь (как, например, в этом случае приложение для раздевания человека). Способность создавать ложный, но убедительный контент повышает риск обмана и имеет серьезные последствия для доверия к СМИ и информации (такие примеры, как " Deepnude" )

Благодаря головокружительному прогрессу в области искусственного интеллекта мир ежедневно сталкивается с deepfakes - вымышленными изображениями и видео, которые поражают своей реалистичностью и могут использоваться не только в развлекательных целях, но и для масштабных кампаний по дезинформации и клевете.

В то время как многие общественные деятели регулярно становятся жертвами незаконного присвоения их образов, анонимные лица не остаются в стороне, как это было недавно показано в Испании в случае с очень молодыми девушками, ставшими жертвами сексуальных фотомонтажей, размещенных в социальных сетях.

Осознают ли французы этот феномен? Чувствуют ли они себя способными справиться с ним? Боятся ли они этого для себя и для демократии?

Чтобы измерить его, Компания Alucare поручила IFOP провести опрос более 2 000 человек. о происходящем перевороте в том, как мы воспринимаем и будем воспринимать реальность в будущем. Их ответы отражают неопределенность, в которую их ввергают эти грозные технологические достижения, их стремление к четкой идентификации соответствующего контента и их страх столкнуться с ним лично или во время следующих президентских выборов.

Отличить правду от лжи: проблема для двух третей французов

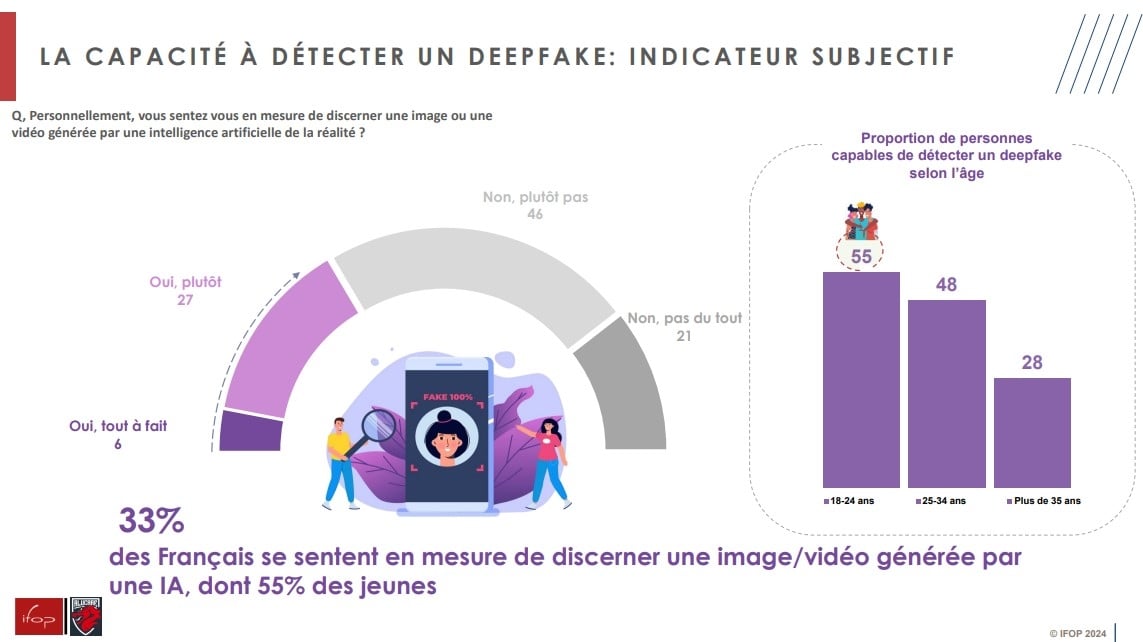

То ли они не очень хорошо представляют себе возможности искусственного интеллекта, то ли, наоборот, знают, насколько мощным он может быть, только треть французов (33%) чувствуют себя способными распознать изображение или видео, созданное искусственным интеллектом. Только 6% уверены в этом, демонстрируя неопределенность, царящую среди населения по этому вопросу. Молодые люди, как правило, более спокойно относятся к появляющимся технологиям, чем их старшие коллеги, и именно они говорят, что лучше всего способны распознать фейк: так считают более половины (55%) 18-24-летних, по сравнению с 28% среди людей старше 35 лет и 12% среди людей старше 65 лет. Мужчины также гораздо более уверены в своей наблюдательности, чем женщины: 40% из них считают, что могут заметить подобные изображения, по сравнению с 28% из женщин..

Тест: некоторые изображения вводят в заблуждение больше, чем другие

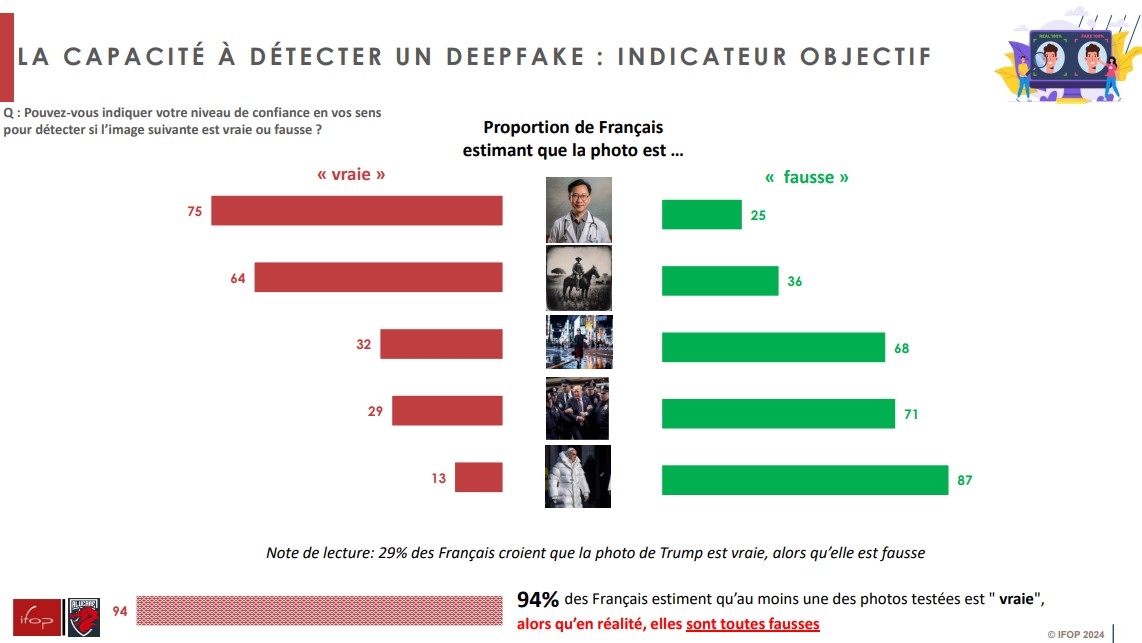

Тест, предложенный IFOP, прекрасно иллюстрирует сложность отличия изображения, созданного искусственным интеллектом, от фотографии, сделанной в реальной жизни. Участников попросили рассмотреть пять изображений и указать, какие из них, по их мнению, были или не были сгенерированы искусственным интеллектом. Но в действительности все представленные изображения были "ложными".

Особенно реалистичный портрет врача одурачил три четверти (75%) респондентов.Почти две трети опрошенных (64%) поверили в то, что старая фотография мужчины на лошади, типичная для снимков начала прошлого века, является правдивой, но полностью составлена искусственным интеллектом. С другой стороны, только 32% поверили в правдивость изображения женщины, идущей по улицам Токио, которое широко использовалось компанией Open AI для объявления о выпуске своего видеогенератора Sora. Бывший президент Дональд Трамп, который регулярно попадает в новости из-за своих столкновений с американской судебной системой, был изображен в окружении нескольких полицейских. Эту "фотографию" посчитали достоверной более чем каждый четвертый француз (29%), причем женщин (32%) поверило в ее подлинность чуть больше, чем мужчин (27%). Наконец, изображение Папы Франциска в белом пуховике, широко опубликованное в социальных сетях несколько месяцев назад, обмануло лишь 13% опрошенных. Наконец, 94% респондентов поверили в правдивость хотя бы одного из клише, представленных на их рассмотрение.

90% из Франции для упоминания о происхождении

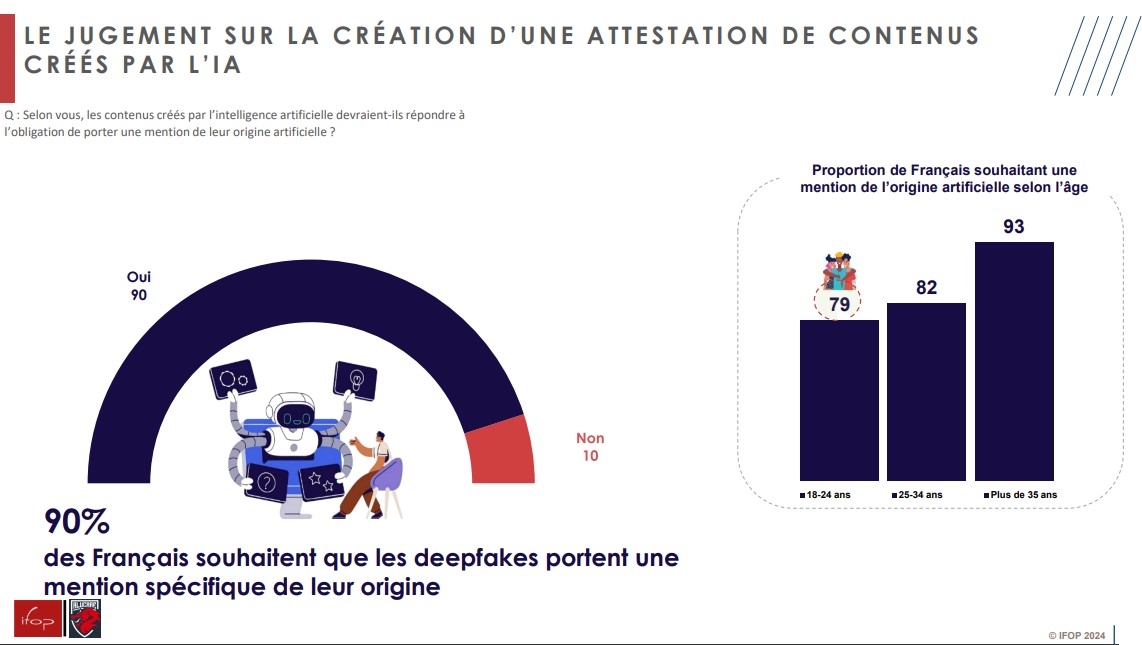

Очевидно, что они предупреждали о рисках дезинформации, присущих распространению абсолютно реалистичных изображений, созданных искусственным интеллектом, подавляющее большинство французов (90%) выступают за принятие закона о выявлении фальшивок как созданные искусственно. Эти ожидания выше среди людей старше 35 лет (93% выступают за), чем среди их более молодых сверстников (79% среди 18-24-летних).

Подсказки, которые не всегда легко заметить

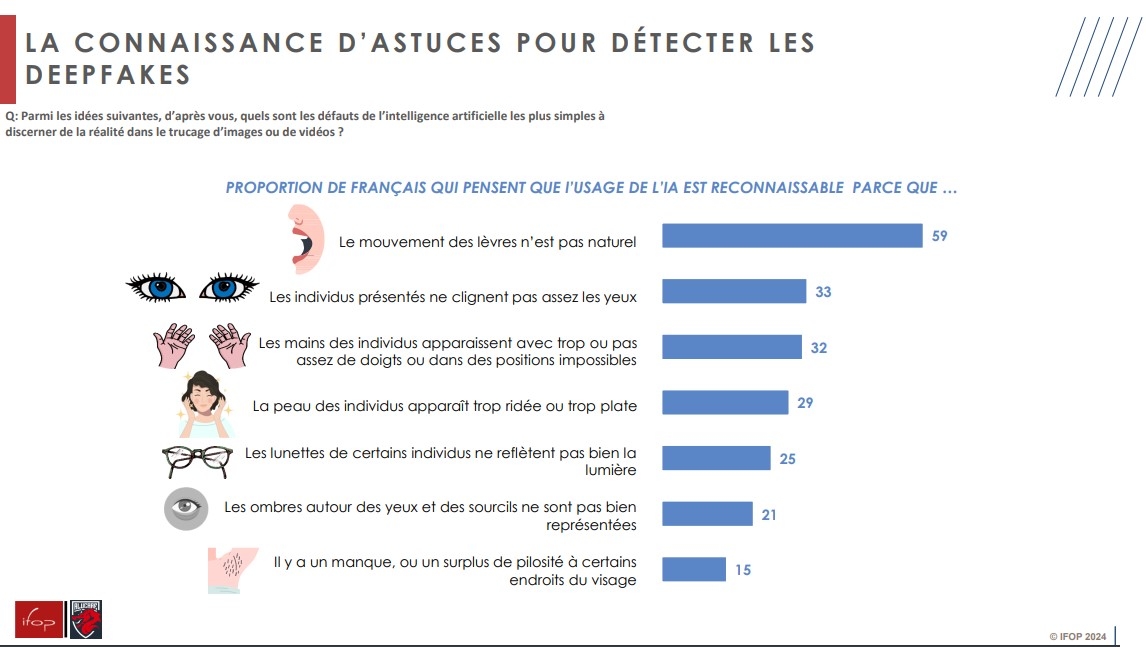

За несколько лет, а для кого-то даже за несколько месяцев, инструменты искусственного интеллекта добились впечатляющих успехов, сделав свои визуальные произведения еще более реалистичными. Однако некоторые детали все еще могут выдать их истинную природу, даже если французы остаются осмотрительными в отношении многих из них. Для 59% французов неестественное движение губ персонажа, говорящего на видео, - это подсказка, которую, по их мнению, довольно легко заметить.. Аналогично, тот факт, что представленные лица не моргают достаточно часто, является хорошим показателем для трети (33%) французов.

В такой же пропорции 32% указывают на известные, но все менее актуальные трудности, с которыми сталкивается ИИ, генерирующий изображения, при правильном воспроизведении рук. Морщинистая или слишком плоская кожа (29%), очки, которые неправильно отражают свет (25%), недостаточно четкие тени вокруг глаз (21%) или отсутствие волос на некоторых участках лица (15%) - все эти недостатки рассматриваются в качестве потенциальных предупреждающих знаков. Однако лишь меньшинство респондентов считают, что их легко заметить.

Частичное знание глубоких подделок

От певицы Тейлор Свифт, ставшей жертвой порнографических фейков в начале этого года, до ложного заявления президента Владимира Зеленского о капитуляции украинских войск и недавнего, тоже фальшивого, заявления Урсулы фон дер Ляйен о предстоящих европейских выборах - видео, сгенерированные ИИ, в которых фигурируют реальные люди, множатся. Звезды и другие политики - не единственные, кого это касается: в сентябре прошлого года в Альмендралехо (Испания) около тридцати девочек в возрасте от 11 до 17 лет стали жертвами фальшивок, на которых они были изображены обнаженными.

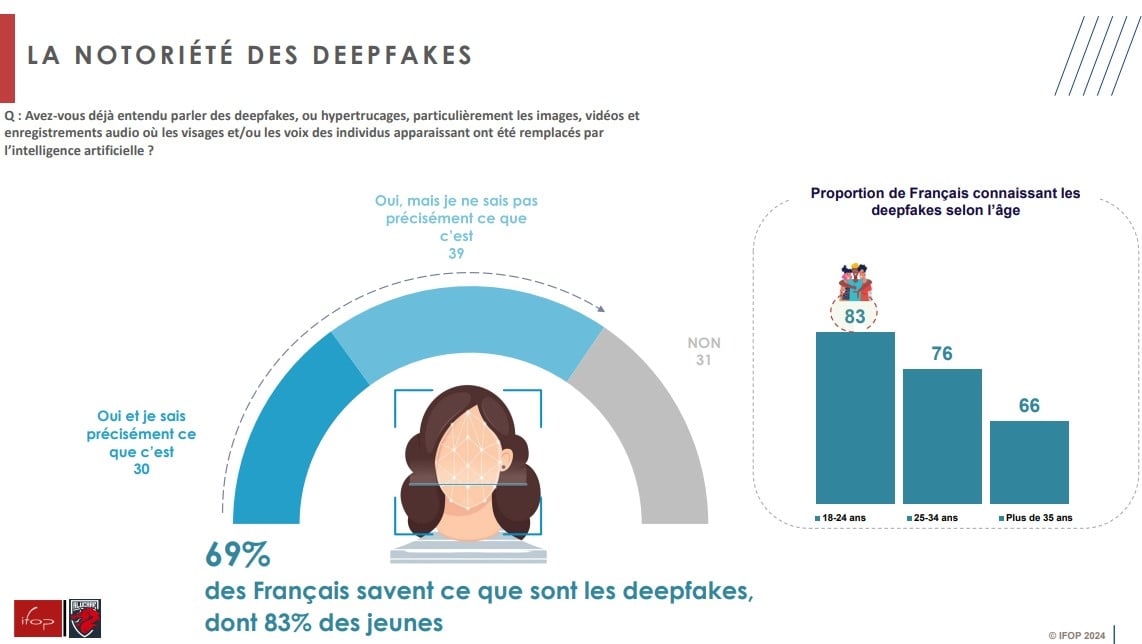

Столкнувшись с этим растущим и тревожным явлением, почти 7 из 10 французов (69%) говорят, что уже слышали о deepfakes, но только 30% знают, что именно они собой представляют. И опять же, именно молодые поколения наиболее осведомлены об этом движении: 831ТП36Т из 18-24-летних (по сравнению с 661ТП36Т среди более 35-летних) знают о нем и 501ТП36Т (по сравнению с 151ТП36Т среди более 65-летних) имеют четкое представление о нем.. Разрыв между женщинами и мужчинами немаленький: если 24% женщин четко знают, что такое deepfakes, то 37% мужчин знают.

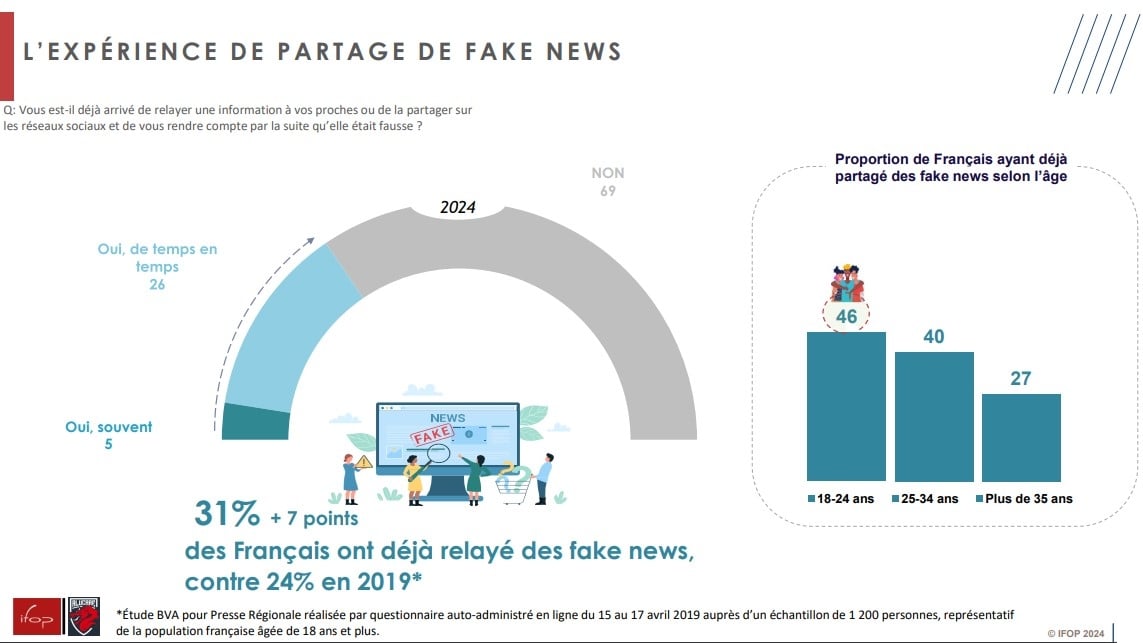

Каждый третий француз уже распространял фальшивые новости

Дипфейки и фальшивые новости принадлежат к одной семье, которая питает дезинформацию и манипулирует общественным мнением. Манипуляция, в которой некоторые французы признаются, что участвуют, даже невольно. И так оно и есть, 31% опрошенных (на 7 пунктов больше, чем в исследовании BVA 2019 года) уже передавали окружающим информацию, которая впоследствии оказалась ложной.Молодые люди делали это чаще (46%), чем другие возрастные группы. С другой стороны, более трех четвертей людей старше 50 лет говорят, что никогда этого не делали.

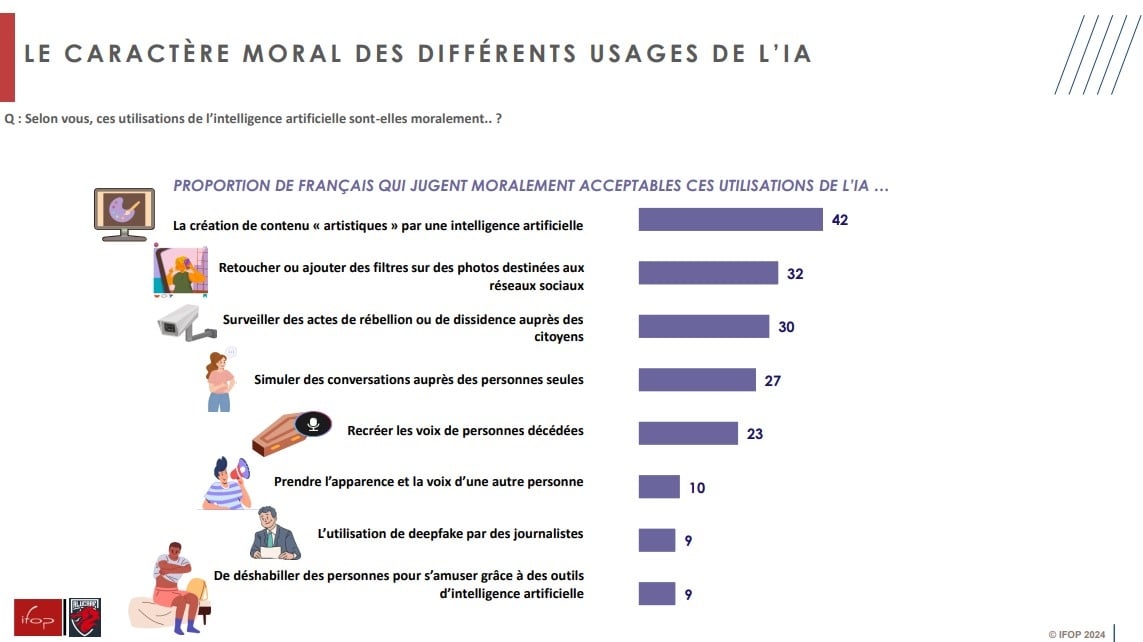

Иногда сомнительное моральное одобрение

Как мы уже видели, искусственный интеллект сегодня предоставляет богатейшие ресурсы в виде изображений, видео и даже клонирования голоса. Из всех вариантов использования искусственного интеллекта, представленных в этом опросе, ни один не кажется большинству французов морально приемлемым. Наиболее приемлемыми являются создание "художественного" контента искусственным интеллектом (42% считают это морально приемлемым) и ретуширование фотографий в социальных сетях с помощью фильтров (32%).

Еще более удивительным - и, конечно, вызывающим беспокойство - является тот факт, что 30% опрошенных согласились с тем, что ИИ следует использовать для отслеживания актов восстания или инакомыслия со стороны граждан. Молодые люди менее критичны к этой практике, чем их старшие: 34% молодых людей до 35 лет считают ее приемлемой, по сравнению с 29% людей старше 35 лет. Существуют также значительные различия между поколениями и полами, когда речь заходит о том, чтобы раздеть людей с помощью искусственного интеллекта для развлечения. В то время как только 9% французов в целом не шокированы таким использованием, эта цифра возрастает до 17% среди молодых людей до 35 лет (и 26% мужчин в этой возрастной категории) по сравнению с 6% среди старших. Аналогичным образом, 13% мужчин считают это искусственное воздействие морально приемлемым, по сравнению с 4% женщин.

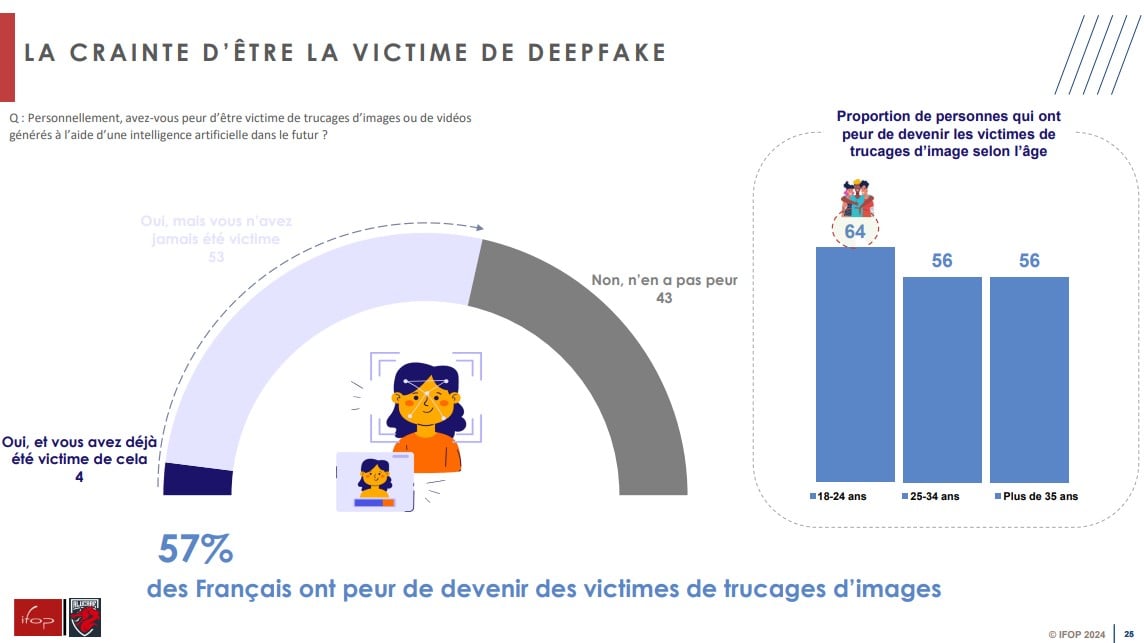

13% молодых людей в возрасте до 25 лет стали жертвами фальшивок

Осознайте широкое распространение инструментов, позволяющих легко создавать глубокие подделки, более половины респондентов (57%) выразили опасение, что они тоже станут жертвами, что уже произошло с 4% из них и 13% из молодых людей в возрасте до 25 лет. В то время как самые молодые возрастные группы действительно наиболее обеспокоены (64% из 18-24-летних боятся ложных изображений), другие возрастные группы на самом деле не более спокойны: 56% из тех, кому за 25, также выражают беспокойство.

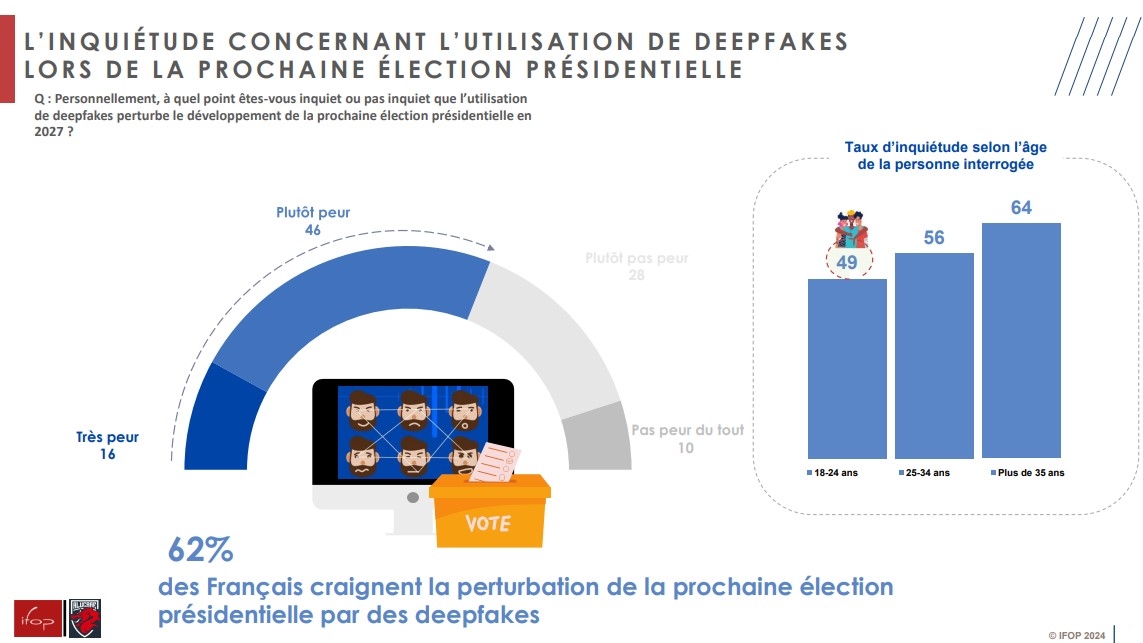

Угроза президентским выборам?

Опасаясь за себя, французы также опасаются, что подобная практика может помешать следующим президентским выборам, тем более что инструменты искусственного интеллекта наверняка станут еще более мощными в период до этого времени. Более 6 из 10 французов (62%) говорят, что обеспокоены тем, что фальшивки могут сорвать голосование в 2027 году, в том числе 16% говорят, что очень боятся. Молодые люди больше, чем в среднем, обеспокоены злоупотреблением собственным имиджем, но гораздо меньше - потенциальным воздействием ложных образов во время избирательной кампании: этого боятся менее половины (49%) молодых людей в возрасте до 25 лет, в то время как среди людей старше 65 лет таких опасений 70%.

Исследование, проведенное IFOP для Alucare.fr с 5 по 8 марта 2024 года путем самостоятельного заполнения анкеты среди выборки из 2 191 человека, представляющих население Франции в возрасте 18 лет и старше, включая 551 молодого человека в возрасте до 35 лет.

В коробке

Глубокие подделки в законопроекте SREN

Во вторник, 26 марта, совместный комитет избранных представителей Национальной ассамблеи и Сената рассмотрит законопроект о безопасности и регулировании цифрового пространства (SREN). Этот законопроект, внесенный правительством и принятый депутатами 17 октября 2023 года, направлен на снижение рисков, связанных с повседневным использованием интернета для частных лиц и предприятий. Он включает в себя положения по широкому кругу вопросов, таких как защита несовершеннолетних в сети, защита граждан в цифровой среде, соблюдение конкуренции в экономике данных и усиление цифрового регулирования. В ходе осенней работы Сенат добавил две статьи, предусматривающие наказание за публикацию фейков без согласия и за публикацию фейков сексуального характера.. Наказание может составить до двух лет лишения свободы и штраф в размере 60 000 евро.