Avec ScraperAPI, vous pouvez oublier les CAPTCHAs, les proxys et les IP bloqués. Avec cette API de web scraping, il suffit d’envoyer une requête et les données vous parviennent rapidement. Aujourd’hui, ScraperAPI est adopté par des milliers d’utilisateurs.

📌 Voici un tableau récapitulatif des points forts et des points faibles de ScraperAPI selon les utilisateurs :

| ✔️ Points forts | ❌ Points faibles |

|---|---|

| Contournement efficace des CAPTCHAs | Tarification peu claire |

| Gestion automatique et efficace des proxys | Limitations occasionnelles de débit et de requêtes |

| Rendu JavaScript fiable | Peu adapté aux très gros volumes |

| Support multi-langages | Documentation avancée perfectible |

| Facilité d’intégration et API simple |

Avis global sur ScraperAPI

Les utilisateurs résument ScraperAPI en trois mots : rapide, fiable, efficace.

D’après tous les avis récoltés sur Trustpilot, G2 et Capterra, ScraperAPI présente une note moyenne de :

4,6 ⭐⭐⭐⭐⭐

| 📊 Plateforme | ⭐ Note sur 5 |

|---|---|

| Trustpilot | 4,7 |

| G2 | 4,4 |

| Capterra | 4,6 |

✔️ Les points forts fréquemment cités :

- Fiabilité et efficacité du scraping

- Facilité d’utilisation et d’intégration

- Support client exceptionnel

- Rapport qualité-prix

- Fonctionnalités spécifiques et avancées

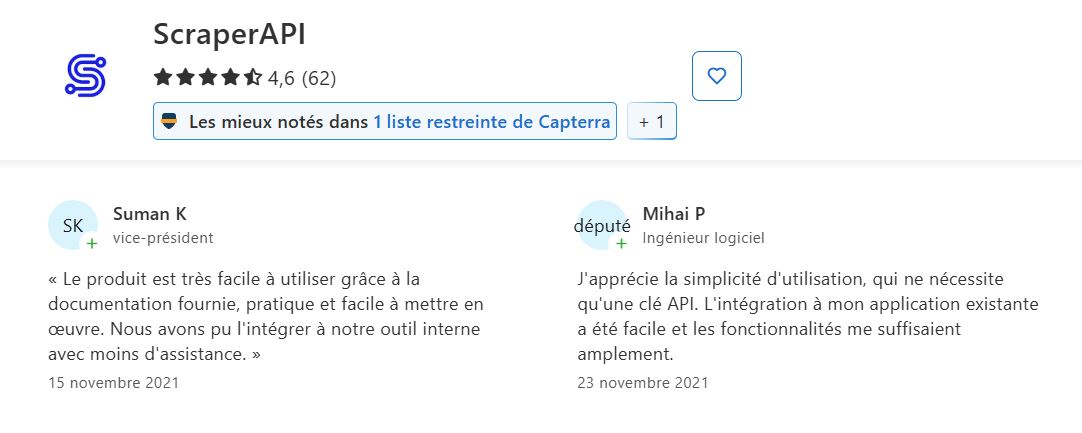

➡️ Selon Suman K et Mihai P sur Capterra :

“Le produit est très facile à utiliser grâce à la documentation fournie, pratique et facile à mettre en œuvre…”

“J’apprécie la simplicité d’utilisation, qui ne nécessite qu’une clé API. L’intégration à mon application existante a été facile et les fonctionnalités me suffisaient amplement.”

➡️ Akif confirme sur Trustpilot :

“Leur service client est excellent…”

➡️ Voici le retour de Muhammad H. sur G2 :

“Il simplifie le web scraping en gérant la gestion des proxys, les CAPTCHAs et le rendu du navigateur, me permettant de me concentrer sur l’extraction de données plutôt que sur les problèmes techniques. L’API s’intègre parfaitement dans mon code existant, et la vitesse est impressionnante, même pour des projets à grande échelle.”

❌ Les défis et les points faibles notés par les utilisateurs :

- Clarté de la tarification et coût perçu : les utilisateurs sont parfois confus sur la tarification.

- Documentation à améliorer pour les fonctionnalités avancées.

- Problèmes occasionnels de limitation de débit/échecs de requêtes.

- Qualité du support.

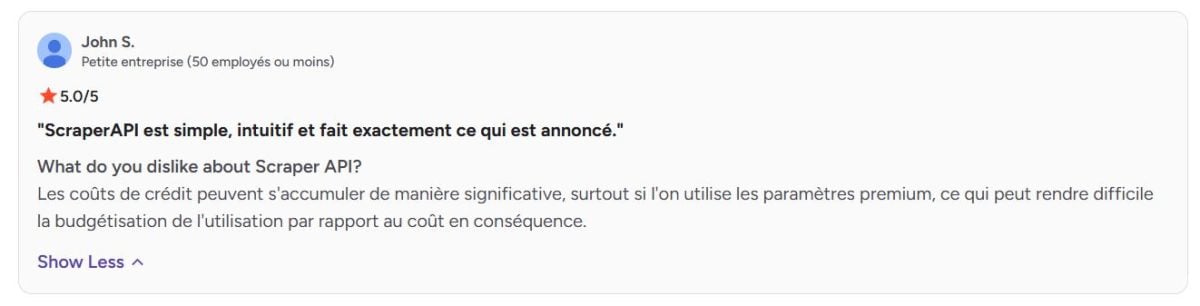

➡️ Selon John S. sur G2 :

“Les coûts de crédit peuvent s’accumuler de manière significative, surtout si l’on utilise les paramètres premium, ce qui peut rendre difficile la budgétisation de l’utilisation par rapport au coût en conséquence.”

Avis sur les services proposés par ScraperAPI

Découvrez en détail les services clés de ScraperAPI et ce que les utilisateurs en pensent.

1. Rotation automatique des proxys

ScraperAPI dispose d’un vaste pool de proxys qu’il fait pivoter automatiquement à chaque requête.

➡️ Selon Aditya Pratap Singh sur Trustpilot :

“ScraperAPI a révolutionné mes projets de web scraping. J’étais constamment aux prises avec des CAPTCHA et des blocages d’adresses IP avant de trouver ce service. Maintenant, je peux me concentrer sur l’utilisation des données au lieu de me battre pour les obtenir. La rotation du proxy est fluide et j’apprécie la gestion automatique du rendu JavaScript.”

2. Gestion du contournement des protections (Bypass)

L’outil sait contourner les mécanismes anti-bot complexes, les pare-feu, les CAPTCHA et autres restrictions d’accès, ce qui garantit une extraction fluide, même sur des sites très protégés.

➡️ D’après Arun K., un chercheur associé :

“Google a réussi à bloquer les requêtes programmatiques, même à des fins non commerciales et d’auto-archivage, et ScraperAPI s’est montré extrêmement efficace pour les contourner. Bien que le routage des requêtes via ScraperAPI soit beaucoup plus lent que, par exemple, via un serveur proxy gratuit.”

3. Rendu JavaScript

Grâce à un navigateur sans tête intégré, ScraperAPI peut scraper des sites dynamiques dont le contenu est chargé via JavaScript.

➡️ Voici le retour de Fazt Tech sur Trustpilot :

“ScraperAPI a considérablement amélioré nos processus de scraping web. L’API est simple à intégrer et prend en charge la plupart des tâches lourdes, comme la rotation des adresses IP et la gestion des proxys, ce qui nous fait gagner un temps précieux. La gestion automatique des captchas est un atout majeur et simplifie considérablement notre collecte de données.”

4. Personnalisation des requêtes

Il est possible de personnaliser les requêtes HTTP en modifiant les en-têtes, les cookies ou les user-agent, ce qui aide à simuler différents comportements et éviter la détection.

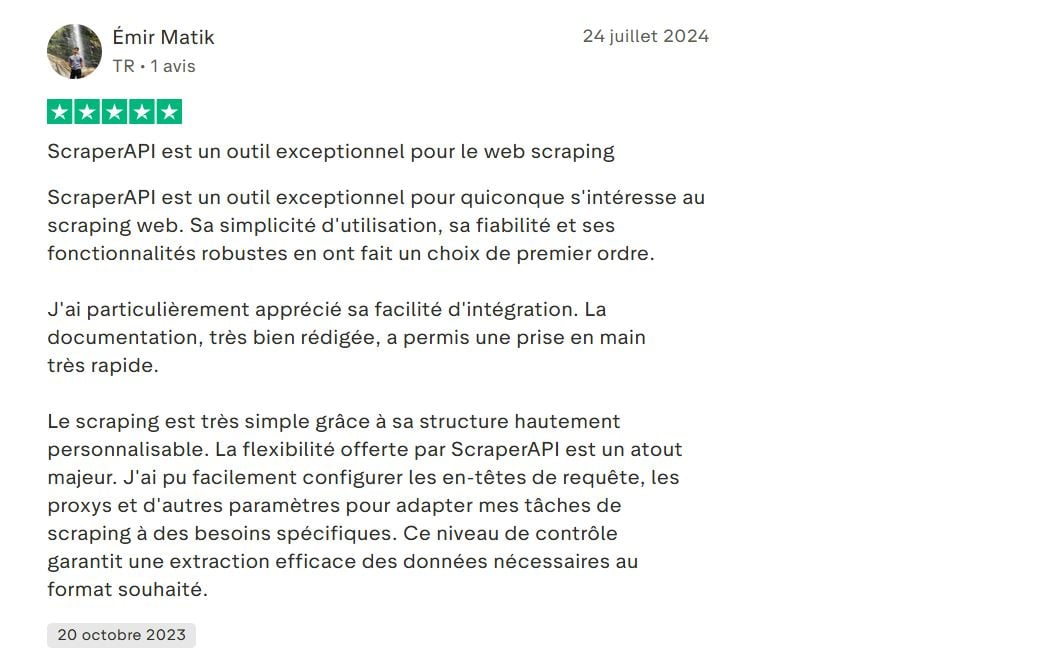

➡️ Voici l’avis de Émir Matik sur Trustpilot :

“…Le scraping est très simple grâce à sa structure hautement personnalisable. La flexibilité offerte par ScraperAPI est un atout majeur. J’ai pu facilement configurer les en-têtes de requête, les proxys et d’autres paramètres pour adapter mes tâches de scraping à des besoins spécifiques…”

5. Géolocalisation des proxys

ScraperAPI offre la possibilité de choisir l’emplacement géographique des proxys (par pays). Cela s’avère utile pour récupérer des données localisées ou pour tester des résultats spécifiques à une région.

➡️ Voici le retour de Melih Krs sur Trustpilot :

“…De plus, sa prise en charge du rendu JavaScript et de la géolocalisation IP a été précieuse…”

6. Tableau de bord et statistiques

Un tableau de bord complet permet de suivre l’utilisation, le nombre de requêtes, le taux de réussite et les crédits restants. Cela facilite la gestion et l’optimisation du scraping.

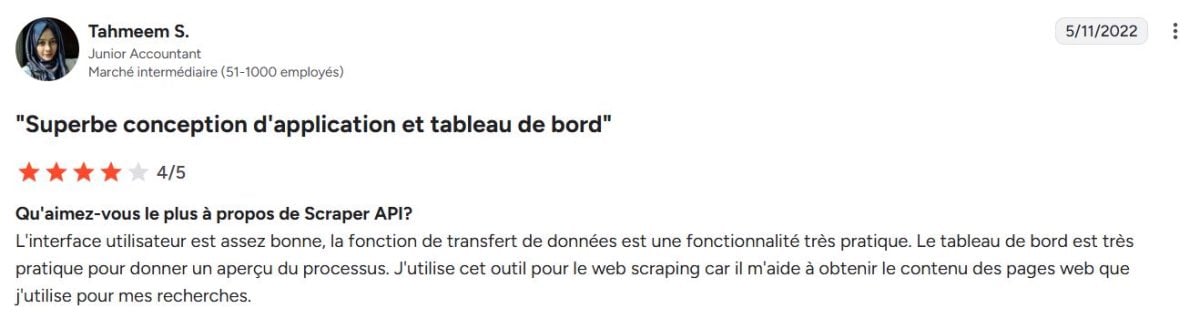

➡️ Selon Tahmeem S. sur G2 :

“L’interface utilisateur est assez bonne, la fonction de transfert de données est une fonctionnalité très pratique. Le tableau de bord est très pratique pour donner un aperçu du processus. J’utilise cet outil pour le web scraping car il m’aide à obtenir le contenu des pages web que j’utilise pour mes recherches.”

7. Intégration et support multi-langages

ScraperAPI propose une API REST simple, facilement intégrable avec plusieurs langages (Python, Node.js, PHP, Java, etc.), ce qui facilite son adoption dans différents environnements.

➡️ Voici ce que dit Deni H. sur G2 :

“L’expérience pour l’API Scraper est probablement celle d’un développeur expérimenté en scraping web avec des connaissances de diverses technologies de scraping, y compris Python (BeautifulSoup et Selenium), JavaScript (Puppeteer ou Cheerio), et Node.js (Demand et Cheerio)…”

8. Fonctionnalités avancées pour les données

- Service de scraping asynchrone : permet d’envoyer des millions de requêtes de manière asynchrone pour des besoins de scraping à très grande échelle.

- Données structurées : sortie directe en JSON ou CSV pour faciliter le traitement des données.

- DataPipeline : automatisation complète sans codage pour récupérer des données en continu.

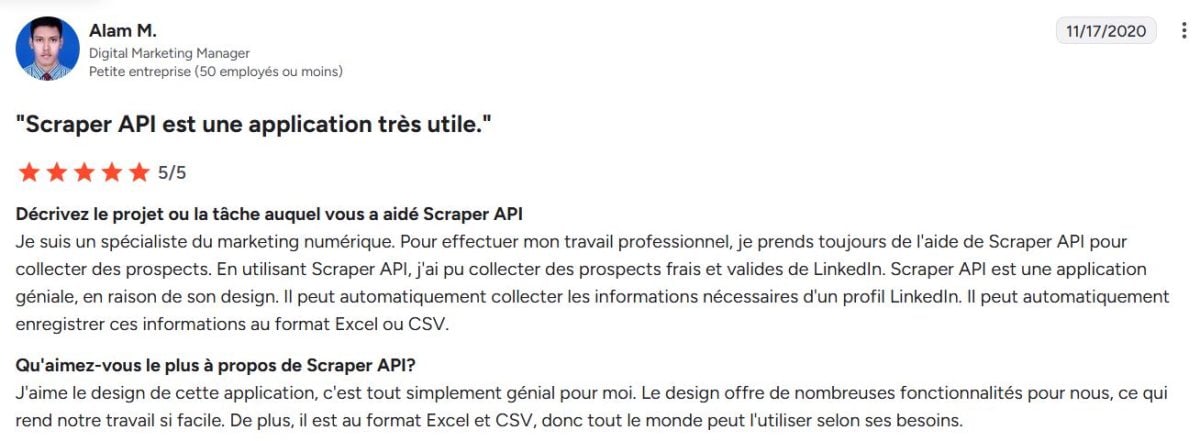

➡️ Selon Alam M., un Digital Marketing Manager sur G2 :

“…Il peut automatiquement enregistrer ces informations au format Excel ou CSV…”

ScraperAPI : Alternatives

ScraperAPI n’est pas le seul acteur sur le marché du web scraping. Plusieurs alternatives se distinguent par leurs approches, leurs prix ou leurs fonctionnalités :

- Bright Data : la plateforme de données web la plus complète.

- ScrapingBee : le principal concurrent de ScraperAPI.

- Octoparse : approche visuelle sans code.

- Apify : plateforme de développement de scrapers.

| 🌐 Outil | 📌 Particularité | 💬Avis utilisateurs | ⭐Note moyenne |

|---|---|---|---|

| ScraperAPI | Rotation automatique des proxys, rendu JavaScript, personnalisation | Fiable et simple d’utilisation, mais parfois confuse sur la tarification | 4,6 |

| Bright Data | Plateforme la plus complète avec proxys premium et data pipeline avancé | Très puissant et flexible, mais complexe à prendre en main | 4,6 |

| ScrapingBee | API simple avec rendu JS et rotation de proxys | Facile à intégrer et bon rapport qualité/prix, mais moins d’options avancées | 4,9 |

| Octoparse | Scraping visuel sans code, approche sans programmation | Idéal pour les non-techniciens, mais limité aux gros volumes | 4,4 |

| Apify | Plateforme de développement de scrapers sur mesure | Très flexible et personnalisable, mais nécessite des compétences techniques élevées | 4,8 |

ScraperAPI est une solution populaire et équilibrée. Bien que plusieurs alternatives offrent des solutions intéressantes adaptées à différents profils, Bright Data demeure la plateforme de données web la plus complète et puissante du marché.

La note de Bright Data est parfois un peu inférieure en raison de son positionnement premium qui ne correspond pas à tous les utilisateurs.

➡️ Niklas affirme sur Capterra :

“Bright Data est un service plus cher mais le meilleur de sa catégorie.”

FAQ

ScraperAPI est-il un outil gratuit ?

ScraperAPI est payant, mais propose un essai gratuit limité.

Combien coûte ScraperAPI ?

Les tarifs de ScraperAPI varient généralement entre 49$ et 475$ par mois.

Comment fonctionne ScraperAPI ?

Techniquement, ScraperAPI agit comme un intermédiaire entre votre application et les sites web à scraper. Il gère automatiquement la rotation des proxys, la gestion des IP, le rendu JavaScript et le contournement des protections. L’outil vous permet de récupérer les données sans bloquage.

Comment utiliser ScraperAPI avec Python ?

L’intégration avec Python est simple grâce à une API REST bien documentée. Il suffit d’envoyer une requête HTTP à l’adresse de l’API de ScraperAPI avec votre clé API et l’URL cible.

1. Définir l’URL ScraperAPI avec votre clé API et l’URL cible

import requests

url = "http://api.scraperapi.com"

params = {

'api_key': 'VOTRE_CLE_API',

'url': 'https://exemple.com'

}2. Envoyer la requête

response = requests.get(url, params=params)3. Afficher le contenu de la page récupérée

print(response.text)Est-ce que ScraperAPI peut contourner les CAPTCHA ?

Oui. L’un des points forts de ScraperAPI est sa capacité à contourner automatiquement les CAPTCHA et d’autres systèmes anti-bot.

🔚 Pour tout résumer, ScraperAPI s’impose comme une solution performante pour automatiser la collecte de données en ligne. Mais pour un service plus complet, Bright Data est l’option idéale.

N’hésitez pas à poser vos questions en commentaire et à partager votre expérience !