il scraping del web è una tecnica di raccolta dei dati online. Può essere effettuata utilizzando strumenti specifici.

In questo articolo vedremo come estrarre dati con Python.

Prerequisiti per lo scraping con Python

Ci sono alcune condizioni da soddisfare prima di poter utilizzare Python per lo scraping del web.

1. Conoscenza di base della programmazione

Prima di tutto, è necessario essere consapevoli di alcune basi di programmazione variabili, strutture di controllo, funzioni, dizionari, manipolazione di file, moduli, librerie, ecc.

Questi concetti vi aiuteranno a capire il logica di script, manipolare i dati recuperati, automatizzare le attività ripetitive e gestire errori ed eccezioni.

2. Padroneggiare la struttura di una pagina web (HTML, CSS)

Python non vede le pagine web come le vediamo noi. Vede solo le pagine codificato che compongono la pagina. Quindi, se si vuole recuperare un'informazione specifica, è necessario sapere dove si trova nel codice.

Senza capire questo, Python non può estrarre ciò che si vuole.

3. Comprendere le richieste HTTP (GET, POST)

Prima di poter leggere il codice di una paginaPython deve richiederlo al sito tramite una query. A Richiesta GET consente di recuperare la pagina e una richiesta POST consente di inviare dati al sito.

Senza sapere come funzionano le richieste, il tuo script non sarà in grado di ottenere la pagina né le informazioni in essa contenute.

In breve, la struttura della pagina indica dove cercare i dati. Visita Richieste HTTP consentono di richiedere questi dati al sito.

💡 Ricordo : il web scraping è diverso dal crawling. Quest'ultimo consiste nel percorrere tutte le pagine di un sito per censirle e analizzarle. Lo scraping, invece, si concentra solo su informazioni precise. Questa distinzione è importante per pianificare correttamente il lavoro.

⚠️ Nota : Prima di eseguire lo scraping di una pagina, inviate una richiesta HTTP per ottenerne il contenuto. Tuttavia, non tutti i siti consentono il recupero automatico di tutte le loro pagine. È qui che entra in gioco il file robots.txt. Esso indica quali pagine possono essere esplorate e quali sono vietate. È necessario rispettare questo file per rimanere legali ed etici.

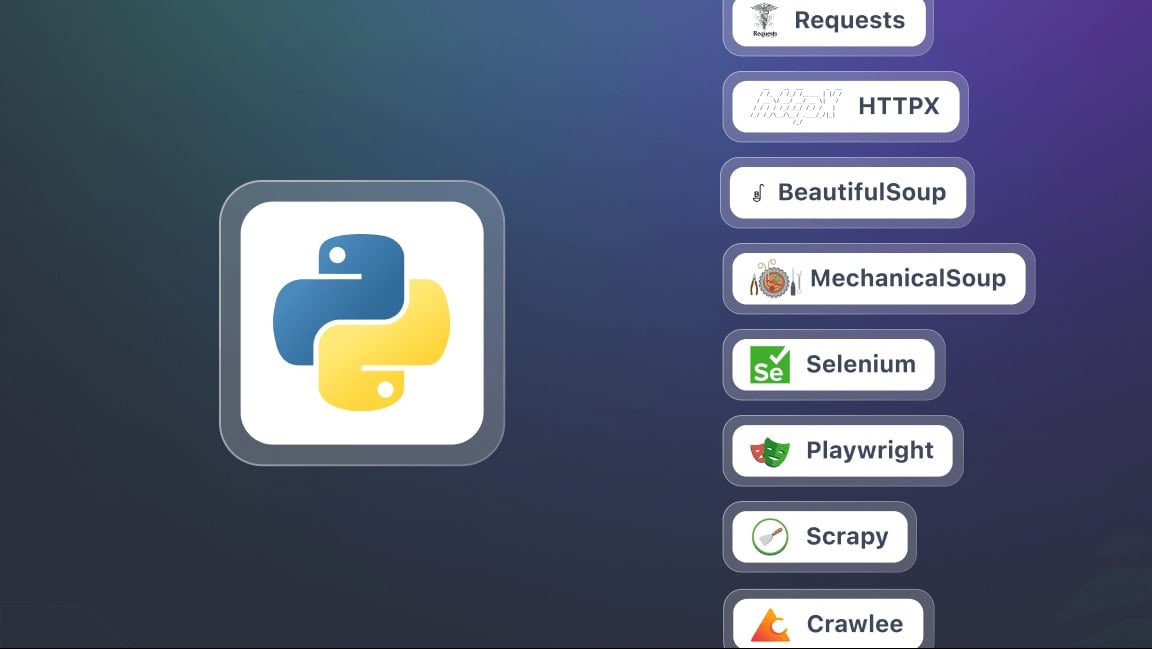

Quali sono gli strumenti essenziali per il web scraping con Python?

Per iniziare a fare web scraping con Python, è necessario preparare l'ambiente.

1. Installazione di Python

Per l'installazione, si consiglia di utilizzare pip. Si tratta di uno strumento di gestione dei pacchetti utilizzato per installare facilmente tutte le librerie necessarie.

2. Preparazione di un ambiente virtuale

Ogni progetto può avere le proprie librerie, indipendentemente dalle altre applicazioni presenti sul computer. L'ambiente virtuale consentirà diisolare le biblioteche del vostro progetto Python senza influenzare altri programmi o la vostra macchina.

3. Installare le librerie chiave per lo scraping

In questo contesto, un biblioteca è un insieme di strumenti e funzioni già programmati che puoi utilizzare direttamente nel tuo Codice Python. Vi evita di dover scrivere tutto da soli e facilita alcuni compiti. Eccone alcuni.

- Richieste : per inviare richieste HTTP e recuperare il contenuto delle pagine web. È la base per qualsiasi operazione di scraping.

- Bella Zuppa per analizzare il codice HTML ed estrarre informazioni. Offre metodi (o selettori) come find(), find_all(), select().

- Selenio : utile quando il contenuto della pagina è generato dinamicamente con JavaScript. Consente di simulare un browser completo e di interagire con la pagina.

- lxml Un parser HTML e XML molto veloce. Più potente di BeautifulSoup, ma leggermente più complesso da usare.

- Drammaturgo un'alternativa più moderna e spesso più veloce di Selenium.

- Scarti Un potente framework per progetti di scraping su larga scala. Consente di gestire facilmente diverse pagine e siti contemporaneamente.

Come si può fare web scraping con Python?

In questo tutorial vedremo passo dopo passo come iniziare a fare web scraping con Python.

Passo 1: installare le librerie (requests e beautifulsoup4)

Per iniziare, sono necessarie due librerie Python : richieste e beautifulsoup4. Installali con pip in un unico passaggio:

pip installa le richieste di beautifulsoup4Quando si utilizzano entrambe le librerie, ricordarsi di iniziare lo script con:

importare le richieste

da bs4 importa BeautifulSoup

Passo 2: effettuare una richiesta HTTP e recuperare i contenuti

Una volta installate le librerie, è possibile inviare una richiesta HTTP a una pagina web e visualizzarne il contenuto. Utilizzare l'URL completo della pagina di destinazione. Per la richiesta, utilizzare il seguente script:

richieste di importazione

url = "https://exemple.com"

pagina = requests.get(url)

print(page.text) # Visualizza il codice HTML della pagina

Qui, pagina.testo contiene tutto l'HTML del sito che si intende analizzare.

Passo 3: analizzare l'HTML con Beautiful Soup

Ora che avete recuperato il contenuto della pagina, potete analizzarlo con Bella Zuppa utilizzando il seguente script:

da bs4 importa BeautifulSoup

soup = BeautifulSoup(page.text, "html.parser")

# Esempio: visualizzazione del titolo della pagina

print(soup.title.string)

Fase 4: Estrazione di dati specifici (titoli, link, ecc.)

Grazie a Bella Zuppaè possibile indirizzare tag HTML specifici: titoli, collegamenti, paragrafi, ecc.

# Estrarre tutti i titoli <h2>

per titolo in soup.find_all("h2"):

print(titolo.get_text())

# Estrarre tutti i collegamenti <a>

per lien in soup.find_all("a"):

print(link["href"])

Passo 5: salvare i dati (CSV, JSON)

Una volta estratti i dati, è possibile salvarli in un file per riutilizzarli.

Esempio in CSV :

importare csv

titles = [title.get_text() for title in soup.find_all("h2")]

con open("results.csv", "w", newline="", encoding="utf-8") as f:

writer = csv.writer(f)

writer.writerow(["Titolo"])

per t in titoli:

writer.writerow([t])

Esempio in JSON :

importare json

lien = [lien["href"] for lien in soup.find_all("a")]

con open("liens.json", "w", encoding="utf-8") as f:

json.dump(liens, f, indent=4, ensure_ascii=False)

⚠️ Nota Questa esercitazione si riferisce a un piccolo progetto come lo scraping di un sito statico. Tuttavia, nella pratica di scraping del web con Pythonè possibile imbattersi rapidamente in ulteriori sfide, come :

- Gestione della paginazione Automatizzare lo scraping su più pagine.

- Gestione dei moduli Inviare i dati per ottenere i risultati.

- Come aggirare le restrizioni utilizzando user-agent e proxy.

Perché fare web scraping con Python?

il scraping del web con Python è un'abilità potente che apre molte possibilità. Ecco alcuni usi concreti che rendono questa pratica particolarmente interessante.

- Tracciamento dei prezzi e commercio elettronico

Scraper delle schede prodotto per monitorare l'andamento dei prezzi, confrontare le offerte della concorrenza e identificare rapidamente le migliori opportunità.

- Analisi del sentimento

Raccogliere le recensioni dei clienti da diversi siti per identificare le tendenze, comprendere le aspettative dei consumatori e migliorare i propri prodotti o servizi.

- Aggregazione di contenuti

Centralizzate gli articoli del blog o le notizie provenienti da diverse fonti per creare una piattaforma sempre aggiornata e ricca di informazioni.

- Ricerca e monitoraggio accademico

Raccogliere dati per studi, per monitorare le pubblicazioni o un settore specifico.

Quali sono le migliori pratiche per il web scraping con Python?

Il web scraping non consiste solo nell'estrarre dati. Si tratta anche di farlo in modo efficiente, responsabile e sostenibile.

Per evitare colli di bottiglia, rispettare la legge e ottenere risultati affidabili, è essenziale seguire alcune buone pratiche:

- 🤖 Rispettare il file robots.txt

- Adottare un ritmo ragionevole per le richieste.

- 🕵️♂️ Utilizzare un User-Agent pertinente

- ⚠️ Gestione di errori ed eccezioni

- 🌐 Utilizzo di proxy e rotatori IP

- 📉 Ridurre al minimo le richieste

- 🔍 Siate trasparenti nelle vostre richieste

- 📂 Separare l'estrazione dal backup dei dati

- 🛠️ Utilizzare selettori robusti

- 📖 Documentare il codice

Domande frequenti

Qual è il miglior framework per il web scraping in Python?

Non esiste un unico framework "migliore", poiché tutto dipende dalla complessità del progetto.

Per estrazioni semplici, Richieste e Bella Zuppa sono più che sufficienti. Quando un sito utilizza molto JavaScript, Selenio Dove Drammaturgo stanno diventando essenziali. Infine, per i progetti su larga scala, Scarti è consigliato per le sue prestazioni e la sua struttura robusta.

Come si effettua lo scrape di un sito web in Python?

Il processo di scraping del web con Python si basa su tre fasi principali:

- Invio di una richiesta HTTP

- Analisi della struttura HTML

- Estrazione dei dati

Qual è il ruolo del web scraper?

il ruolo del web scraper è quello di scorrere automaticamente le pagine web per estrarre dati precisi, che si tratti di testi, prezzi, immagini o link. Funge da intermediario tra il sito e l'utente trasformando le informazioni grezze in dati utilizzabili.

Come si usa Beautiful Soup in Python?

Bella Zuppa è una libreria progettata per analizzare il codice HTML di una pagina e facilitare la ricerca dei tag che contengono le informazioni da estrarre.

È sufficiente combinare un Richiesta HTTP con Richiestepoi analizzare il contenuto con BeautifulSoup per navigare nella struttura e recuperare i dati necessari.

Come si effettua lo scrape di un sito web con JavaScript?

Alcuni siti si basano molto su JavaScript per visualizzarne il contenuto. In questo caso, le soluzioni classiche come Requests non sono sufficienti. È quindi necessario utilizzare strumenti in grado di simulare un vero browser. Citiamo Selenio e Drammaturgo, per caricare e interagire con la pagina.

Qual è il linguaggio più comune utilizzato per il web scraping?

Pitone è oggi il linguaggio più diffuso per il web scraping grazie alla sua semplicità e alla ricchezza delle sue librerie specializzate.

Tuttavia, è possibile automatizzare l'estrazione dei dati con PHPanche se questa tecnica è meno diffusa.

Il web scraping è legale?

Il legalità del web scraping è una questione complessa. Tutto dipende dal modo in cui viene praticato, dal rispetto delle condizioni di utilizzo dei siti e dalla natura dei dati raccolti.

In Francia, il web scraping è tollerato in alcuni casi. Tuttavia, può diventare illegale se viola i diritti di accesso, le condizioni d'uso di un sito o la legislazione sui dati personali.

In breve, il web scraping con Python apre un mondo di possibilità incredibili. Quali sono le vostre esperienze o domande? Condividetele nei commenti, non vediamo l'ora di ascoltarvi!