в скраппинг это техника сбора данных в Интернете. Для этого можно использовать специальные инструменты.

В этой статье мы рассмотрим, как Извлечение данных с помощью Python.

Необходимые условия для работы с Python

Чтобы использовать Python для веб-скраппинга, необходимо выполнить несколько условий.

1. Базовые знания в области программирования

Прежде всего, вам необходимо знать о некоторых основы программирования переменные, управляющие структуры, функции, словари, работа с файлами, модули, библиотеки и т.д.

Эти понятия помогут вам понять логика сценария, манипулировать полученными данными, автоматизировать повторяющиеся задачи и управлять ошибками и исключениями.

2. Освоить структуру веб-страницы (HTML, CSS)

Python видит веб-страницы не так, как мы. Он просто видит закодированный из которых состоит эта страница. Поэтому, если вы хотите получить определенный фрагмент информации, вам нужно знать, где он находится в коде.

Не понимая этого, Python не сможет извлечь то, что вы хотите.

3. Понимание HTTP-запросов (GET, POST)

Прежде чем вы сможете прочитать код страницыPython должен запросить его у сайта с помощью запроса. A GET-запрос позволяет загрузить страницу, а запрос POST позволяет отправить данные на сайт.

Не зная, как работают запросы, ваш скрипт не сможет получить страницу и содержащуюся на ней информацию.

Одним словом, структура страницы указывает вам, где искать данные. Посетите HTTP-запросы позволяют запрашивать эти данные на сайте.

💡 Отзывать : веб-скрапинг отличается от краулинга. Краулинг заключается в прохождении всех страниц сайта для их индексации и анализа. Скрапинг же нацелен только на конкретную информацию. Это различие важно для правильного планирования работы.

⚠️ Примечание : Перед тем, как сканировать страницу, вы отправляете HTTP-запрос, чтобы получить ее содержимое. Однако не все сайты разрешают автоматическое сканирование всех своих страниц. Здесь на помощь приходит файл robots.txt. Он указывает, какие страницы можно сканировать, а какие запрещены. Вы должны соблюдать этот файл, чтобы оставаться в рамках закона и этики.

Какие инструменты необходимы для веб-скраппинга с помощью Python?

Чтобы начать заниматься веб-скраппингом с помощью Python, вам нужно подготовить среду.

1. Установка Python

Для установки рекомендуется использовать pip. Это инструмент для управления пакетами, который используется для простой установки всех необходимых библиотек.

2. Подготовка виртуальной среды

Каждый проект может иметь свои собственные библиотеки, независимо от других приложений на вашем компьютере. Виртуальная среда позволитизолировать библиотеки вашего проекта на Python, не затрагивая другие программы или ваш компьютер.

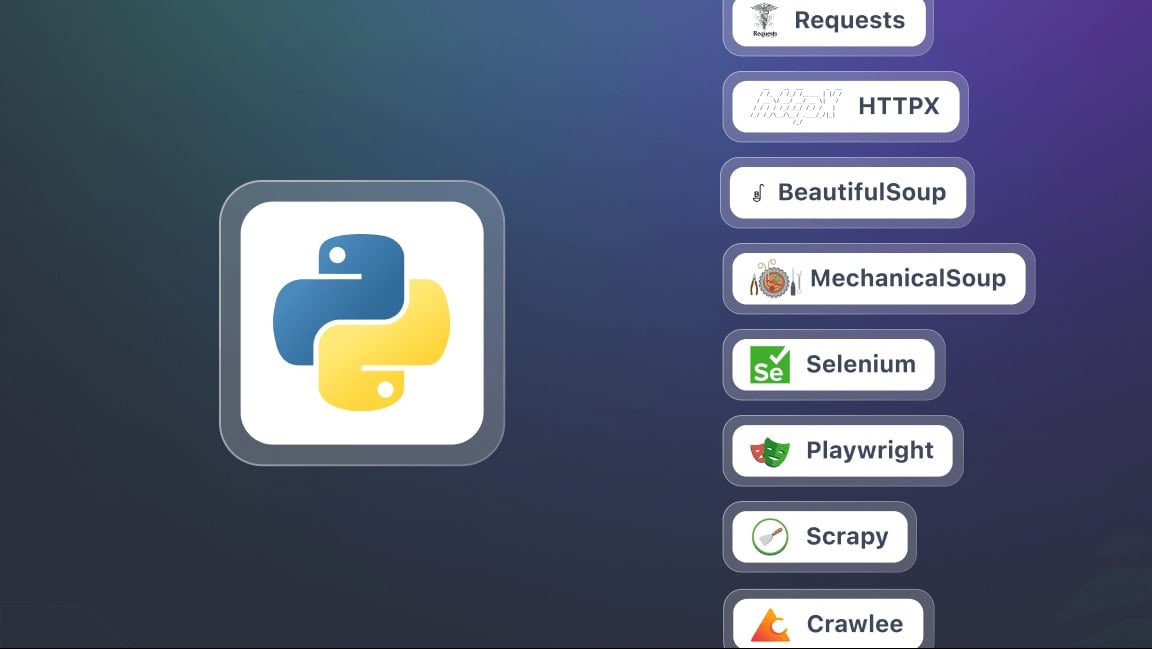

3. Установите ключевые библиотеки для скрапбукинга

В этом контексте библиотека — это набор заранее запрограммированных инструментов и функций, которые вы можете использовать непосредственно в своем Код Python. Это избавит вас от необходимости писать все самостоятельно и облегчит выполнение некоторых задач. Вот лишь некоторые из них.

- Запросы : для отправки HTTP-запросов и получения содержимого веб-страниц. Это основа для любой операции скрапинга.

- BeautifulSoup Для анализа HTML-кода и извлечения информации. Он предлагает такие методы (или селекторы), как find(), find_all(), select().

- Селен : полезно, когда содержимое страницы генерируется динамически с помощью JavaScript. Позволяет имитировать полнофункциональный браузер и взаимодействовать со страницей.

- lxml Очень быстрый парсер HTML и XML. Более мощный, чем BeautifulSoup, но немного более сложный в использовании.

- Драматург более современная и зачастую более быстрая альтернатива Selenium.

- Scrapy Мощный фреймворк для масштабных проектов по скрапбукингу. Он позволяет легко управлять несколькими страницами и сайтами одновременно.

Как сделать веб-скраппинг с помощью Python?

В этом руководстве мы рассмотрим шаг за шагом, как начать заниматься веб-скреппингом с помощью Python.

Шаг 1: Установка библиотек (requests и beautifulsoup4)

Для начала работы вам понадобятся две библиотеки Python : Запросы а также красивый суп4. Установите их с помощью pip за один раз:

pip install requests beautifulsoup4При использовании обеих библиотек не забудьте начать свой скрипт со следующего кода:

импортировать запросы

из bs4 import BeautifulSoup

Шаг 2: Выполните HTTP-запрос и получите содержимое

После установки библиотек вы можете отправить HTTP-запрос на веб-страницу и отобразить ее содержимое. Используйте полный URL-адрес целевой страницы. Для запроса вы будете использовать следующий скрипт:

запросы на импорт

url = "https://exemple.com"

страница = requests.get(url)

print(page.text) # Отображает HTML-код страницы

Вот, страница.текст содержит весь HTML для сайта, который вы собираетесь анализировать.

Шаг 3: Разбор HTML с помощью Beautiful Soup

Теперь, когда вы получили содержимое страницы, вы можете проанализировать его с помощью BeautifulSoup с помощью следующего сценария:

из bs4 import BeautifulSoup

soup = BeautifulSoup(page.text, "html.parser")

# Пример: отображение заголовка страницы

print(soup.title.string)

Шаг 4: Извлечение конкретных данных (заголовки, ссылки и т. д.)

Благодаря BeautifulSoupВы можете нацеливаться на определенные HTML-теги: заголовки, ссылки, абзацы и т.д.

# Извлечь все названия <h2>

for title in soup.find_all("h2"):

print(title.get_text())

# Извлечение всех ссылок <a>

for lien in soup.find_all("a"):

print(link["href"])

Шаг 5: Сохраните данные (CSV, JSON)

После извлечения данных вы можете сохранить их в файл для повторного использования.

Пример в формате CSV :

импорт csv

заголовки = [title.get_text() for title in soup.find_all("h2")]

with open("results.csv", "w", newline="", encoding="utf-8") as f:

writer = csv.writer(f)

writer.writerow(["Название"])

for t in titres:

writer.writerow([t])

Пример в JSON :

импортировать json

liens = [lien["href"] for lien in soup.find_all("a")]

with open("liens.json", "w", encoding="utf-8") as f:

json.dump(liens, f, indent=4, ensure_ascii=False)

⚠️ Примечание Это руководство предназначено для небольшого проекта, такого как скраппинг статического сайта. Однако на практике Веб-скраппинг с помощью PythonВы можете быстро столкнуться с дополнительными проблемами, такими как :

- Управление пагинацией Автоматизируйте поиск по нескольким страницам.

- Управление формами Отправьте данные для получения результатов.

- Обход ограничений с помощью пользователей-агентов и прокси.

Зачем нужен веб-скраппинг с помощью Python?

в Веб-скраппинг с помощью Python это мощный навык, открывающий множество возможностей. Вот несколько конкретных вариантов использования, которые делают эту практику особенно интересной.

- Отслеживание цен и электронная коммерция

Сбор информации о продуктах для отслеживания изменения цен, сравнения предложений конкурентов и быстрого выявления лучших возможностей.

- Анализ настроения

Собирайте отзывы клиентов с различных сайтов, чтобы выявить тенденции, понять ожидания потребителей и улучшить свои продукты или услуги.

- Агрегация контента

Централизуйте статьи из блога или новости из нескольких источников, чтобы создать платформу, которая всегда будет актуальной и насыщенной информацией.

- Академические исследования и мониторинг

Сбор данных для исследований, мониторинга публикаций или определенного сектора.

Каковы лучшие практики для веб-скреппинга с помощью Python?

Веб-парсинг — это не только извлечение данных. Это еще и эффективность, ответственность и устойчивость.

Чтобы избежать узких мест, не выходить за рамки закона и получить надежные результаты, необходимо следовать определенным передовым практикам:

- 🤖 Уважайте файл robots.txt

- ⏳ Примите разумный темп выполнения запросов

- 🕵️♂️ Используйте соответствующий User-Agent.

- ⚠️ Управление ошибками и исключениями

- 🌐 Использование прокси-серверов и ротаторов IP-адресов

- 📉 Минимизация запросов

- 🔍 Будьте прозрачны в своих просьбах

- 📂 Разделение извлечения и резервного копирования данных

- 🛠️ Используйте надежные селекторы.

- 📖 Документирование вашего кода

Часто задаваемые вопросы

Какой фреймворк лучше всего подходит для веб-скреппинга на Python?

Не существует единственного «лучшего» фреймворка, поскольку все зависит от сложность проекта.

Для простой экстракции, Запросы а также BeautifulSoup вполне достаточно. Когда сайт использует много JavaScript, Селен Где Драматург становятся крайне важными. Наконец, для масштабных проектов, Scrapy рекомендуется благодаря своей производительности и прочной конструкции.

Как скреативить сайт в Python?

Процесс Веб-скраппинг с помощью Python состоит из трех основных этапов:

- Отправка HTTP-запроса

- Анализ структуры HTML

- Извлечение данных

Какова роль веб-скрепера?

в роль веб-скрепера занимается автоматическим просмотром веб-страниц с целью извлечения конкретных данных, будь то тексты, цены, изображения или ссылки. Он действует как посредник между сайтом и пользователем, преобразуя необработанную информацию в данные, пригодные для использования.

Как использовать Beautiful Soup в Python?

BeautifulSoup — это библиотека, предназначенная для анализа HTML-кода страницы и облегчения поиска тегов, содержащих информацию, которую необходимо извлечь.

Просто соедините HTTP-запрос с запросамиЗатем разберите содержимое с помощью BeautifulSoup, чтобы сориентироваться в структуре и получить нужные данные.

Как скреативить сайт с помощью JavaScript?

Некоторые сайты в значительной степени полагаются на JavaScript для отображения их содержимого. В этом случае классические решения, такие как Requests, не подходят. Необходимо использовать инструменты, способные имитировать работу реального браузера. Среди них можно назвать Селен а также Драматург, чтобы загрузить страницу и взаимодействовать с ней.

Какой язык чаще всего используется для веб-скреппинга?

Python сегодня является самым популярным языком для веб-парсинга благодаря своей простоте и богатству специализированных библиотек.

Однако можно автоматизироватьизвлечение данных с помощью PHPхотя эта техника менее распространена.

Законен ли веб-скрепинг?

La Законность веб-скреппинга — это сложный вопрос. Все зависит от того, как он осуществляется, от соблюдения условий использования сайтов и характера собираемых данных.

Во Франции веб-скребок допускается в некоторых случаях. Однако он может стать незаконным, если нарушает права доступа, условия использования сайта или законодательство о персональных данных.

Одним словом, веб-скраппинг с помощью Python открывает мир невероятных возможностей. А какой у вас опыт или вопросы? Поделитесь ими в комментариях, мы с нетерпением ждем ваших ответов!