det web scraping er en teknik til at indsamle data online. Det kan gøres ved hjælp af specifikke værktøjer.

I denne artikel ser vi på, hvordan Udtræk af data med Python.

Forudsætninger for scraping med Python

Der er nogle få betingelser, der skal opfyldes, før du kan bruge Python til webscraping.

1. En grundlæggende viden om programmering

Først og fremmest skal du være opmærksom på visse Grundlæggende programmering variabler, kontrolstrukturer, funktioner, ordbøger, filmanipulation, moduler, biblioteker osv.

Disse begreber vil hjælpe dig med at forstå Scriptlogik, manipulere de hentede data, automatisere gentagne opgaver og håndtere fejl og undtagelser.

2. Beherske strukturen på en webside (HTML, CSS)

Python ser ikke websider på samme måde som os. Den ser bare kodet der udgør denne side. Så hvis du vil hente et bestemt stykke information, skal du vide, hvor det er i koden.

Uden at forstå dette kan Python ikke udtrække det, du ønsker.

3. Forståelse af HTTP-anmodninger (GET, POST)

Før du kan læse sidekodePython skal anmode om det fra webstedet via en forespørgsel. A GET-anmodning gør det muligt at hente siden, og en POST-forespørgsel gør det muligt at sende data til webstedet.

Uden at vide, hvordan forespørgsler fungerer, vil dit script ikke kunne hente siden eller de oplysninger, den indeholder.

Kort sagt fortæller sidestrukturen dig, hvor du skal lede efter data. Besøg HTTP-anmodninger giver dig mulighed for at anmode om disse data fra webstedet.

💡 Minde om : Webscraping adskiller sig fra crawling. Crawling består i at gennemgå alle siderne på et websted for at registrere og analysere dem. Scraping er derimod kun rettet mod bestemte oplysninger. Denne forskel er vigtig for at kunne planlægge arbejdet korrekt.

⚠️ Bemærkning : Inden du scraper en side, sender du en HTTP-anmodning for at få dens indhold. Imidlertid tillader ikke alle websteder, at alle deres sider hentes automatisk. Det er her, robots.txt-filen kommer ind i billedet. Den angiver, hvilke sider der kan gennemgås, og hvilke sider der er forbudt. Du skal overholde denne fil for at overholde lovgivningen og etiske regler.

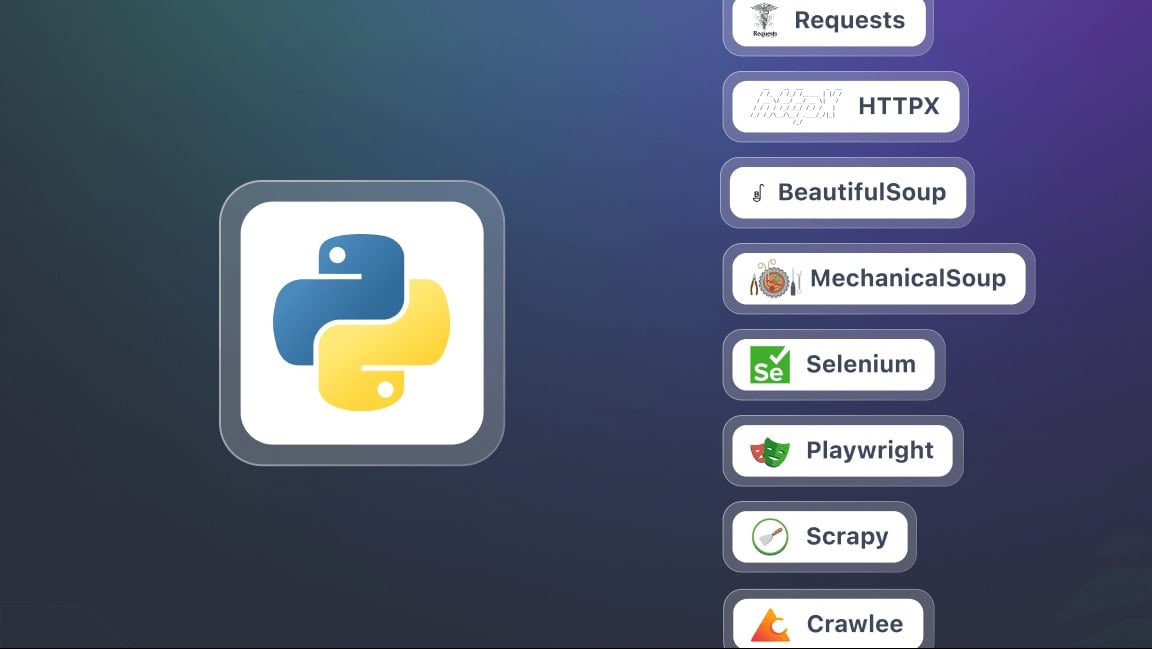

Hvad er de vigtigste værktøjer til webscraping med Python?

For at komme i gang med webscraping med Python skal du forberede dit miljø.

1. Installation af Python

Til installationen anbefales det at bruge pip. Det er et værktøj til pakkehåndtering, der bruges til nemt at installere alle de biblioteker, du har brug for.

2. Forberedelse af et virtuelt miljø

Hvert projekt kan have sine egne biblioteker, uafhængigt af andre programmer på din computer. Det virtuelle miljø vil gøre det muligt at’isolere biblioteker af dit Python-projekt uden at påvirke andre programmer eller din maskine.

3. Installer de vigtigste biblioteker til scraping

I denne sammenhæng er en bibliotek er et sæt forudprogrammerede værktøjer og funktioner, som du kan bruge direkte i din Python-kode. Det sparer dig for at skulle skrive alting selv og gør visse opgaver lettere. Her er blot nogle få af dem.

- Forespørgsler : til at sende HTTP-anmodninger og hente indholdet af websider. Dette er grundlaget for al scraping.

- SmukSuppe til at analysere HTML-kode og udtrække information. Den tilbyder metoder (eller selektorer) som find(), find_all(), select().

- Selen : nyttigt, når sidens indhold genereres dynamisk med JavaScript. Det gør det muligt at simulere en komplet browser og interagere med siden.

- lxml En meget hurtig HTML- og XML-parser. Mere kraftfuld end BeautifulSoup, men lidt mere kompleks at bruge.

- Dramatiker et mere moderne og ofte hurtigere alternativ til Selenium.

- Skrot En kraftfuld ramme til store scraping-projekter. Det gør det nemt at administrere flere sider og websteder på samme tid.

Hvordan kan jeg lave webscraping med Python?

I denne vejledning ser vi trin for trin på, hvordan man kommer i gang med webscraping i Python.

Trin 1: Installation af bibliotekerne (requests og beautifulsoup4)

For at komme i gang skal du bruge to Python-biblioteker : anmodninger og beautifulsoup4. Installer dem med pip på én gang:

pip install requests beautifulsoup4Når du bruger begge biblioteker, skal du huske at starte dit script med:

importere anmodninger

fra bs4 import BeautifulSoup

Trin 2: Lav en HTTP-anmodning og hent indholdet

Når biblioteker er installeret, kan du sende en HTTP-anmodning til en webside og vise dens indhold. Brug den fulde URL til målsiden. Du bruger følgende script til en anmodning:

importanmodninger

url = "https://exemple.com"

side = requests.get(url)

print(page.text) # Viser sidens HTML-kode

Her, side.tekst indeholder al HTML for det websted, du skal analysere.

Trin 3: Parsing af HTML med Beautiful Soup

Nu hvor du har hentet indholdet fra siden, kan du analysere det med SmukSuppe ved hjælp af følgende script:

fra bs4 import BeautifulSoup

soup = BeautifulSoup(page.text, "html.parser")

# Eksempel: vis sidens titel

print(soup.title.string)

Trin 4: Udtræk specifikke data (titler, links osv.)

Tak til SmukSuppeDu kan målrette mod specifikke HTML-tags: titler, links, afsnit osv.

# Udtræk alle titler <h2>

for title in soup.find_all("h2"):

print(title.get_text())

# Udtræk alle links <a>

for lien i soup.find_all("a"):

print(link["href"])

Trin 5: Gem data (CSV, JSON)

Når dine data er trukket ud, kan du gemme dem i en fil, så de kan bruges igen.

Eksempel i CSV :

importere csv

titles = [title.get_text() for title in soup.find_all("h2")]

med open("results.csv", "w", newline="", encoding="utf-8") som f:

writer = csv.writer(f)

writer.writerow(["Titel"])

for t i titler:

writer.writerow([t])

Eksempel i JSON :

import json

liens = [lien["href"] for lien in soup.find_all("a")]

med open("liens.json", "w", encoding="utf-8") som f:

json.dump(liens, f, indent=4, ensure_ascii=False)

⚠️ Bemærkning Denne vejledning er til et lille projekt som f.eks. at scrape et statisk websted. Men i praksis er web scraping med Pythonkan du hurtigt løbe ind i yderligere udfordringer som f.eks:

- Håndtering af paginering Automatiser scraping på tværs af flere sider.

- Håndtering af formularer Send data for at få resultater.

- At komme uden om restriktioner ved hjælp af brugeragenter og fuldmagter.

Hvorfor webscraping med Python?

det web scraping med Python er en stærk evne, der åbner op for mange muligheder. Her er et par konkrete anvendelser, som gør denne praksis særlig interessant.

- Prisovervågning og e-handel

Scrape produktfiler for at overvåge prisudviklingen, sammenligne konkurrenternes tilbud og hurtigt identificere de bedste muligheder.

- Sentiment-analyse

Saml kundeanmeldelser fra forskellige websteder for at identificere tendenser, forstå forbrugernes forventninger og forbedre deres produkter eller tjenester.

- Samling af indhold

Centraliser blogartikler eller nyheder fra flere kilder for at skabe en platform, der altid er opdateret og rig på information.

- Akademisk forskning og overvågning

Indsaml data til undersøgelser, for at overvåge publikationer eller en bestemt sektor.

Hvad er den bedste praksis for webscraping med Python?

Webscraping handler ikke kun om at udtrække data. Det handler også om at gøre det på en effektiv, ansvarlig og bæredygtig måde.

For at undgå flaskehalse, holde sig inden for lovens rammer og opnå pålidelige resultater er det vigtigt at følge visse gode fremgangsmåder:

- 🤖 Respekter robots.txt-filen

- ⏳ Vedtag et rimeligt tempo for anmodninger

- 🕵️♂️ Brug en relevant User-Agent

- ⚠️ Håndtering af fejl og undtagelser

- 🌐 Brug af proxyservere og IP-rotatorer

- 📉 Minimering af anmodninger

- 🔍 Vær gennemsigtig i dine anmodninger

- 📂 Adskil udtrækning fra sikkerhedskopiering af data

- 🛠️ Brug robuste selektorer

- 📖 Dokumentér din kode

Ofte stillede spørgsmål

Hvad er det bedste framework til webscraping i Python?

Der findes ikke ét enkelt “bedste” framework, da det hele afhænger af Projektets kompleksitet.

Til enkle udtrækninger, Forespørgsler og SmukSuppe er mere end nok. Når et websted bruger meget JavaScript, Selen Hvor Dramatiker er ved at blive afgørende. Endelig til store projekter, Skrot anbefales på grund af dens ydeevne og robuste struktur.

Hvordan scraper jeg en hjemmeside i Python?

Processen med web scraping med Python er baseret på tre hovedfaser:

- Afsendelse af en HTTP-anmodning

- Analyse af HTML-struktur

- Udtræk af data

Hvad er webscraperens rolle?

det Webscraperens rolle er at gennemgå websider automatisk for at udtrække præcise data, uanset om det drejer sig om tekster, priser, billeder eller links. Den fungerer som mellemled mellem webstedet og brugeren ved at omdanne rå information til brugbare data.

Hvordan bruger jeg Beautiful Soup i Python?

SmukSuppe er et bibliotek, der er udviklet til at analysere en sides HTML-kode og gøre det lettere at finde de tags, der indeholder de oplysninger, der skal udtrækkes.

Du skal blot kombinere en HTTP-anmodning med Requestsog derefter analysere indholdet med BeautifulSoup for at navigere i strukturen og hente de data, du har brug for.

Hvordan scraper jeg en hjemmeside med JavaScript?

Nogle sites er meget afhængige af JavaScript for at vise deres indhold. I dette tilfælde er klassiske løsninger som Requests ikke tilstrækkelige. Det er derfor nødvendigt at bruge værktøjer, der kan simulere en rigtig browser. Vi nævner Selen og Dramatiker, for at indlæse og interagere med siden.

Hvad er det mest almindelige sprog, der bruges til webscraping?

Python er i dag det mest populære sprog til webscraping takket være dets enkelhed og dets omfattende specialiserede biblioteker.

Det er dog muligt at automatisere’Dataudtræk med PHPselvom denne teknik er mindre udbredt.

Er webscraping lovligt?

Det Lovligheden af webscraping er et komplekst spørgsmål. Det afhænger af, hvordan det praktiseres, overholdelsen af betingelserne for brug af webstederne og arten af de indsamlede data.

I Frankrig er web scraping er tilladt i visse tilfælde. Men det kan blive ulovligt, hvis det krænker adgangsrettigheder, vilkår for brug af et websted eller lovgivningen om personoplysninger.

Kort sagt åbner webscraping med Python en verden af utrolige muligheder. Hvad er dine erfaringer eller spørgsmål? Del dem i kommentarfeltet, vi glæder os til at høre fra dig!