la raspado web es una técnica de recogida de datos en línea. Puede realizarse utilizando herramientas específicas.

En este artículo veremos cómo extraer datos con Python.

Requisitos previos para el scraping con Python

Hay algunas condiciones que deben cumplirse antes de poder utilizar Python para el web scraping.

1. Conocimientos básicos de programación

En primer lugar, debe tener en cuenta ciertas fundamentos de programación variables, estructuras de control, funciones, diccionarios, manipulación de archivos, módulos, bibliotecas, etc.

Estos conceptos le ayudarán a comprender la lógica de script, manipular los datos recuperados, automatizar tareas repetitivas y gestionar errores y excepciones.

2. Dominar la estructura de una página web (HTML, CSS)

Python no ve las páginas web como nosotros. Sólo ve el codificado que compone esta página. Por lo tanto, si desea recuperar una información concreta, debe saber en qué parte del código se encuentra.

Sin entender esto, Python no puede extraer lo que quiere.

3. Entender las peticiones HTTP (GET, POST)

Antes de poder leer el código de una páginaPython tiene que solicitarlo al sitio mediante una consulta. A Solicitud GET permite recuperar la página y una solicitud POST permite enviar datos al sitio.

Sin saber cómo funcionan las consultas, su script no podrá obtener la página ni la información que contiene.

En resumen, la estructura de la página le indica dónde buscar los datos. Visite Peticiones HTTP le permiten solicitar estos datos al sitio.

💡 Recuerdo : el web scraping es diferente del crawling. Este último consiste en recorrer todas las páginas de un sitio web para recopilarlas y analizarlas. El scraping, por su parte, se centra únicamente en información específica. Esta distinción es importante para planificar correctamente el trabajo.

⚠️ Observación : Antes de rastrear una página, envías una solicitud HTTP para obtener su contenido. Sin embargo, no todos los sitios permiten que todas sus páginas se recuperen automáticamente. Ahí es donde entra en juego el archivo robots.txt. Indica qué páginas se pueden rastrear y cuáles están prohibidas. Debes respetar este archivo para cumplir con la ley y la ética.

¿Cuáles son las herramientas esenciales para el web scraping con Python?

Para empezar a hacer web scraping con Python, necesitas preparar tu entorno.

1. Instalación de Python

Para la instalación, se recomienda utilizar pip. Es una herramienta de gestión de paquetes que se utiliza para instalar fácilmente todas las bibliotecas que necesitarás.

2. Preparar un entorno virtual

Cada proyecto puede tener sus propias bibliotecas, independientemente de las demás aplicaciones de su ordenador. El entorno virtual permitiráaislar bibliotecas de tu proyecto Python sin afectar a otros programas o a tu máquina.

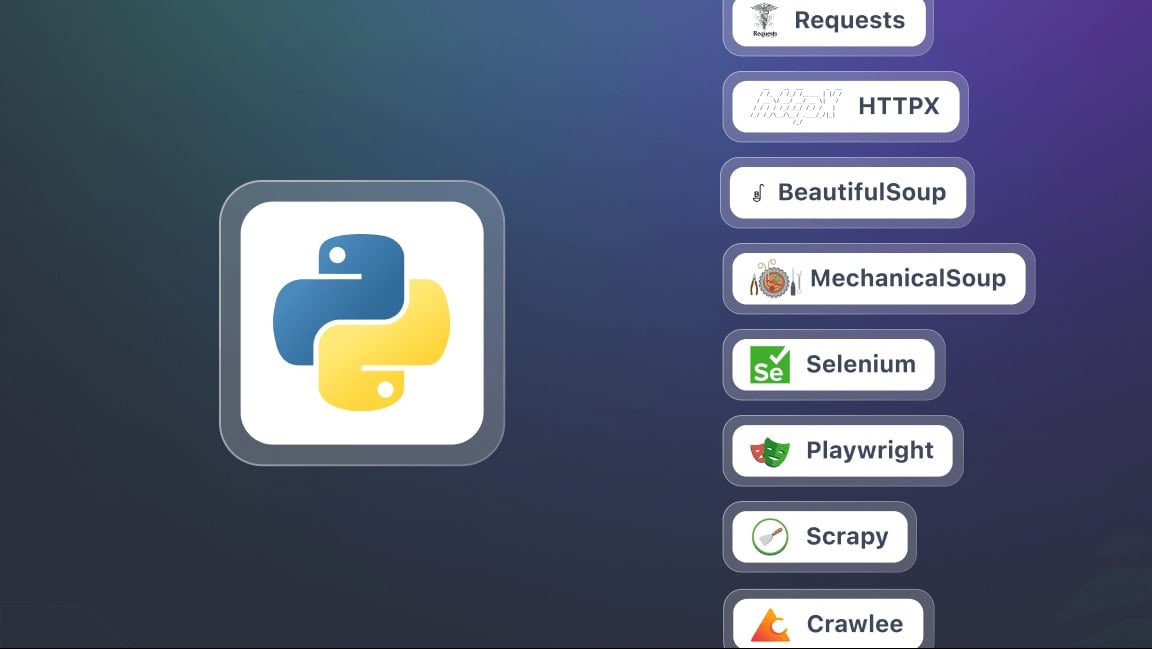

3. Instalar las bibliotecas clave para el scraping

En este contexto, un biblioteca es un conjunto de herramientas y funciones ya programadas que puede utilizar directamente en su Código Python. Te ahorra tener que escribirlo todo tú mismo y facilita ciertas tareas. He aquí algunas de ellas.

- Solicitudes : para enviar solicitudes HTTP y recuperar el contenido de las páginas web. Es la base de cualquier operación de scraping.

- BeautifulSoup para analizar código HTML y extraer información. Ofrece métodos (o selectores) como find(), find_all(), select().

- Selenio : útil cuando el contenido de la página se genera dinámicamente con JavaScript. Permite simular un navegador completo e interactuar con la página.

- lxml Un analizador HTML y XML muy rápido. Más potente que BeautifulSoup, pero ligeramente más complejo de usar.

- Dramaturgo una alternativa más moderna y a menudo más rápida que Selenium.

- Chatarra Un potente marco para proyectos de scraping a gran escala. Facilita la gestión simultánea de varias páginas y sitios.

¿Cómo puedo hacer web scraping con Python?

En este tutorial, veremos paso a paso cómo empezar con el web scraping en Python.

Paso 1: Instalación de las bibliotecas (requests y beautifulsoup4)

Para empezar, necesitas dos bibliotecas de Python : peticiones y beautifulsoup4. Instálalos con pip de una sola vez:

pip install peticiones beautifulsoup4Cuando utilice ambas bibliotecas, recuerde comenzar su script con:

importar peticiones

from bs4 import BeautifulSoup

Paso 2: Realizar una petición HTTP y recuperar el contenido

Una vez instaladas las bibliotecas, puede enviar una solicitud HTTP a una página web y mostrar su contenido. Utilice la URL completa de la página de destino. Para realizar una solicitud, utilice el siguiente script:

solicitudes de importación

url = "https://exemple.com"

página = requests.get(url)

print(page.text) # Muestra el código HTML de la página

Toma, página.texto contiene todo el HTML del sitio que va a analizar.

Paso 3: Analizar el HTML con Beautiful Soup

Ahora que ha recuperado el contenido de la página, puede analizarlo con BeautifulSoup utilizando el siguiente script:

from bs4 import BeautifulSoup

soup = BeautifulSoup(página.texto, "html.parser")

# Ejemplo: mostrar el título de la página

print(sopa.titulo.cadena)

Paso 4: Extraer datos específicos (títulos, enlaces, etc.)

Gracias a BeautifulSouppuede dirigirse a etiquetas HTML específicas: títulos, enlaces, párrafos, etc.

# Extraer todos los títulos <h2>

for title in soup.find_all("h2"):

print(titulo.obtener_texto())

# Extraer todos los enlaces <a>

for lien in soup.find_all("a"):

print(enlace["href"])

Paso 5: Guardar datos (CSV, JSON)

Una vez extraídos los datos, puedes guardarlos en un archivo para reutilizarlos.

Ejemplo en CSV :

importar csv

titles = [title.get_text() for title in soup.find_all("h2")]

with open("resultados.csv", "w", nueva línea="", codificación="utf-8") as f:

writer = csv.writer(f)

writer.writerow(["Título"])

para t en títulos

writer.writerow([t])

Ejemplo en JSON :

importar json

liens = [lien["href"] for lien in soup.find_all("a")]

with open("liens.json", "w", encoding="utf-8") as f:

json.dump(liens, f, indent=4, ensure_ascii=False)

⚠️ Observación Este tutorial es para un proyecto pequeño como el scraping de un sitio estático. Sin embargo, en la práctica web scraping con Pythonpuede encontrarse rápidamente con retos adicionales como :

- Gestión de la paginación Automatice el raspado en varias páginas.

- Gestión de formularios Enviar datos para obtener resultados.

- Evitar las restricciones utilizando usuarios-agentes y proxies.

¿Por qué hacer web scraping con Python?

la web scraping con Python es una habilidad poderosa que abre muchas posibilidades. He aquí algunos usos concretos que hacen que esta práctica sea especialmente interesante.

- Seguimiento de precios y comercio electrónico

Recopilar fichas de productos para supervisar la evolución de los precios, comparar las ofertas de la competencia e identificar rápidamente las mejores oportunidades.

- Análisis del sentimiento

Recopilar opiniones de clientes de diferentes sitios para identificar tendencias, comprender las expectativas de los consumidores y mejorar sus productos o servicios.

- Agregación de contenidos

Centralice artículos de blog o noticias de varias fuentes para crear una plataforma siempre actualizada y rica en información.

- Investigación académica y seguimiento

Recoger datos para estudios, para hacer un seguimiento de las publicaciones o de un sector específico.

¿Cuáles son las mejores prácticas para el web scraping con Python?

El web scraping no consiste solo en extraer datos. También se trata de hacerlo de manera eficaz, responsable y sostenible.

Para evitar atascos, respetar la ley y obtener resultados fiables, es esencial seguir ciertas buenas prácticas:

- 🤖 Respetar el archivo robots.txt

- ⏳ Adoptar un ritmo razonable de solicitudes

- 🕵️♂️ Utilizar un User-Agent pertinente

- ⚠️ Gestión de errores y excepciones

- 🌐 Utilizar proxies y rotadores de IP

- 📉 Minimizar las solicitudes

- 🔍 Sé transparente en tus peticiones

- 📂 Separar la extracción de la copia de seguridad de los datos

- 🛠️ Utilice selectores robustos

- 📖 Documenta tu código

preguntas frecuentes

¿Cuál es el mejor framework para web scraping en Python?

No existe un único «mejor» marco de trabajo, ya que todo depende de la complejidad del proyecto.

Para extracciones simples, Solicitudes y BeautifulSoup son más que suficientes. Cuando un sitio web utiliza mucho JavaScript, Selenio Donde Dramaturgo son cada vez más esenciales. Por último, para los proyectos a gran escala, Chatarra se recomienda por su rendimiento y robusta estructura.

¿Cómo hacer scraping de un sitio web en Python?

El proceso de web scraping con Python se basa en tres etapas principales:

- Envío de una solicitud HTTP

- Análisis de la estructura HTML

- Extracción de datos

¿Cuál es la función del web scraper?

la papel del web scraper es recorrer automáticamente las páginas web para extraer datos precisos, ya sean textos, precios, imágenes o enlaces. Actúa como intermediario entre el sitio web y el usuario, transformando la información bruta en datos explotables.

¿Cómo se utiliza Beautiful Soup en Python?

BeautifulSoup es una biblioteca diseñada para analizar el código HTML de una página y facilitar la búsqueda de etiquetas que contienen la información que se desea extraer.

Basta con combinar un Solicitud HTTP con Requestsa continuación, analizar el contenido con BeautifulSoup para navegar por la estructura y recuperar los datos que necesita.

¿Cómo se raspa un sitio web con JavaScript?

Algunos sitios se basan en gran medida en JavaScript para mostrar su contenido. En este caso, las soluciones clásicas como Requests no son suficientes. Por lo tanto, es necesario utilizar herramientas capaces de simular un navegador real. Citamos Selenio y Dramaturgo, para cargar e interactuar con la página.

¿Cuál es el lenguaje más utilizado para el web scraping?

Python Es actualmente el lenguaje más popular para el web scraping gracias a su simplicidad y a la riqueza de sus bibliotecas especializadas.

Sin embargo, es posible automatizar elextracción de datos con PHPaunque esta técnica está menos extendida.

¿Es legal el web scraping?

Él legalidad del web scraping es una cuestión compleja. Todo depende de cómo se practique, del respeto de las condiciones de uso de los sitios web y de la naturaleza de los datos recopilados.

En Francia, el web scraping se tolera en algunos casos. Sin embargo, puede ser ilegal si viola los derechos de acceso, las condiciones de uso de un sitio web o la legislación sobre datos personales.

En resumen, el web scraping con Python abre un mundo de posibilidades increíbles. ¿Cuáles son tus experiencias o preguntas? Compártelas en los comentarios, ¡estamos deseando conocerlas!