a raspagem da web é uma técnica de recolha de dados em linha. Pode ser efectuada utilizando ferramentas específicas.

Neste artigo, veremos como extrair dados com Python.

Pré-requisitos para o scraping com Python

Existem algumas condições que devem ser cumpridas antes de poder utilizar Python para a recolha de dados da Web.

1. Conhecimentos básicos de programação

Antes de mais, é necessário ter em conta certos noções básicas de programação variáveis, estruturas de controlo, funções, dicionários, manipulação de ficheiros, módulos, bibliotecas, etc.

Estes conceitos ajudá-lo-ão a compreender o lógica do guião, manipular os dados recuperados, automatizar tarefas repetitivas e gerir erros e exceções.

2. Dominar a estrutura de uma página web (HTML, CSS)

Python não vê as páginas web da mesma forma que nós. Ele apenas vê o codificado que compõe esta página. Por isso, se quiser obter uma informação específica, precisa de saber onde ela se encontra no código.

Sem compreender isto, o Python não pode extrair o que pretende.

3. Compreender os pedidos HTTP (GET, POST)

Antes de poder ler o código de uma páginaO Python tem de o solicitar ao sítio através de uma consulta. A Pedido GET permite recuperar a página e uma solicitação POST permite enviar dados para o site.

Sem saber como funcionam as solicitações, o seu script não conseguirá obter a página nem as informações que ela contém.

Em suma, a estrutura da página diz-lhe onde procurar os dados. Visitar Pedidos HTTP permitir-lhe solicitar estes dados ao sítio.

💡 Lembrar : o web scraping é diferente do crawling. Este último consiste em percorrer todas as páginas de um site para as recensear e analisar. O scraping, por sua vez, visa apenas informações específicas. Esta distinção é importante para planear corretamente o trabalho.

⚠️ Observação : Antes de fazer o scraping de uma página, você envia uma solicitação HTTP para obter o seu conteúdo. No entanto, nem todos os sites permitem que todas as suas páginas sejam recuperadas automaticamente. É aí que entra o ficheiro robots.txt. Ele indica quais páginas podem ser exploradas e quais são proibidas. Você deve respeitar esse ficheiro para permanecer dentro da legalidade e da ética.

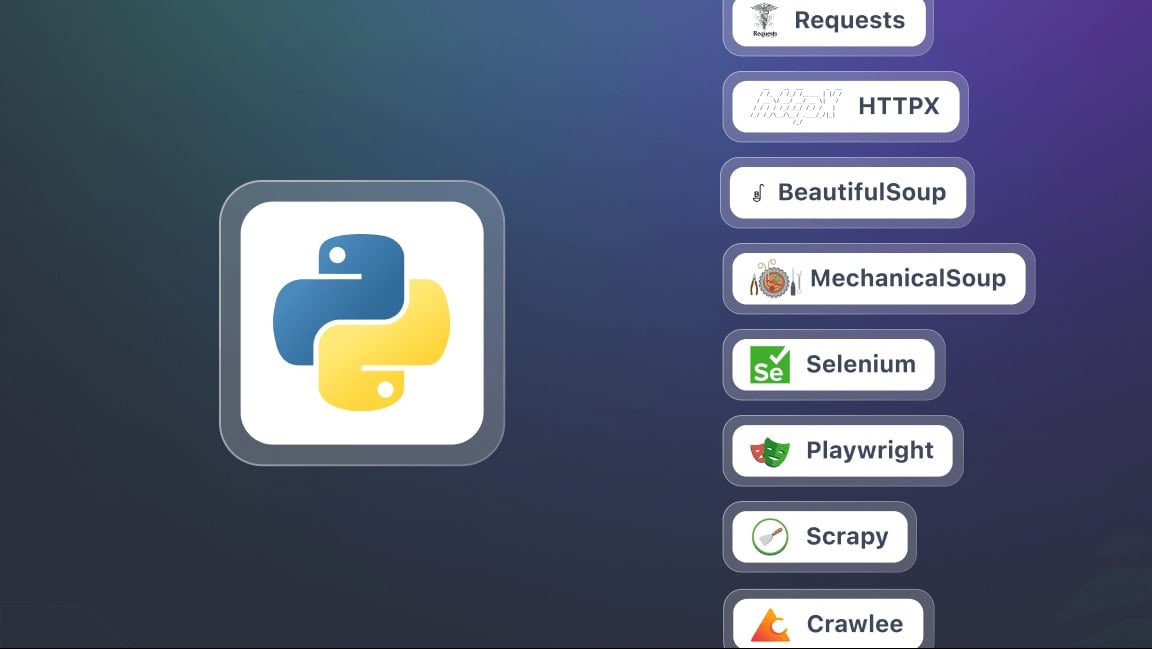

Quais são as ferramentas essenciais para a recolha de dados da Web com Python?

Para iniciar a recolha de dados da Web com Python, é necessário preparar o ambiente.

1. Instalar o Python

Para a instalação, recomenda-se utilizar tubagem. É uma ferramenta de gestão de pacotes utilizada para instalar facilmente todas as bibliotecas de que necessita.

2. Preparar um ambiente virtual

Cada projeto pode ter as suas próprias bibliotecas, independentemente das outras aplicações no seu computador. O ambiente virtual permitiráisolar bibliotecas do seu projeto Python sem afetar outros programas ou a sua máquina.

3. Instalar as principais bibliotecas para raspagem

Neste contexto, um biblioteca é um conjunto de ferramentas e funções já programadas que pode utilizar diretamente no seu Código Python. Evita que tenha de escrever tudo sozinho e facilita certas tarefas. Eis apenas algumas delas.

- Pedidos : para enviar pedidos HTTP e recuperar o conteúdo das páginas web. É a base para qualquer operação de scraping.

- Bela Sopa para analisar o código HTML e extrair informações. Oferece métodos (ou selectores) como find(), find_all(), select().

- Selénio : útil quando o conteúdo da página é gerado dinamicamente com JavaScript. Permite simular um navegador completo e interagir com a página.

- lxml Um analisador de HTML e XML muito rápido. Mais poderoso que o BeautifulSoup, mas ligeiramente mais complexo de usar.

- Dramaturgo uma alternativa mais moderna e frequentemente mais rápida ao Selenium.

- Sucata Uma estrutura poderosa para projectos de raspagem em grande escala. Permite gerir facilmente várias páginas e sítios em simultâneo.

Como é que posso fazer web scraping com Python?

Neste tutorial, veremos passo a passo como começar a usar o web scraping em Python.

Passo 1: Instalar as bibliotecas (requests e beautifulsoup4)

Para começar, precisa de duas bibliotecas Python : solicitações de e beautifulsoup4Instale-os com o pip de uma só vez:

pip install requests beautifulsoup4Ao utilizar as duas bibliotecas, não se esqueça de iniciar o seu script com:

importar pedidos

from bs4 import BeautifulSoup

Passo 2: Fazer um pedido HTTP e recuperar o conteúdo

Depois de instalar as bibliotecas, pode enviar uma solicitação HTTP para uma página web e exibir o seu conteúdo. Use o URL completo da página de destino. Usará o seguinte script para uma solicitação:

pedidos de importação

url = "https://exemple.com"

página = requests.get(url)

print(page.text) # Apresenta o código HTML da página

Aqui, página.texto contém todo o HTML do sítio que vai analisar.

Etapa 3: Analisando o HTML com Beautiful Soup

Agora que recuperou o conteúdo da página, pode analisá-lo com Bela Sopa utilizando o seguinte guião:

from bs4 import BeautifulSoup

soup = BeautifulSoup(página.texto, "html.parser")

# Exemplo: mostrar o título da página

print(soup.title.string)

Etapa 4: Extrair dados específicos (títulos, ligações, etc.)

Graças a Bela Sopapode selecionar etiquetas HTML específicas: títulos, ligações, parágrafos, etc.

# Extrair todos os títulos <h2>

for title in soup.find_all("h2"):

print(title.get_text())

# Extrair todas as ligações <a>

for lien in soup.find_all("a"):

print(link["href"])

Passo 5: Guardar dados (CSV, JSON)

Uma vez extraídos os seus dados, pode guardá-los num ficheiro para reutilização.

Exemplo em CSV :

importar csv

títulos = [title.get_text() for title in soup.find_all("h2")]

com open("results.csv", "w", newline="", encoding="utf-8") as f:

escritor = csv.writer(f)

writer.writerow(["Título"])

for t in titres:

writer.writerow([t])

Exemplo em JSON :

importar json

liens = [lien["href"] for lien in soup.find_all("a")]

with open("liens.json", "w", encoding="utf-8") as f:

json.dump(liens, f, indent=4, ensure_ascii=False)

⚠️ Observação Este tutorial destina-se a um pequeno projeto, como a recolha de dados de um sítio estático. No entanto, na prática de recolha de dados da Web com Pythonpode rapidamente deparar-se com desafios adicionais, tais como :

- Gerir a paginação Automatize a recolha de dados em várias páginas.

- Gerir formulários Enviar dados para obter resultados.

- Contornar as restrições utilizando agentes de utilizadores e proxies.

Porquê fazer web scraping com Python?

a recolha de dados da Web com Python é uma competência poderosa que abre muitas possibilidades. Eis algumas utilizações concretas que tornam esta prática particularmente interessante.

- Controlo de preços e comércio eletrónico

Extrair fichas de produtos para acompanhar a evolução dos preços, comparar as ofertas dos concorrentes e identificar rapidamente as melhores oportunidades.

- Análise de sentimentos

Recolher as opiniões dos clientes de diferentes sítios para identificar tendências, compreender as expectativas dos consumidores e melhorar os seus produtos ou serviços.

- Agregação de conteúdos

Centralize artigos de blogues ou notícias de várias fontes para criar uma plataforma sempre actualizada e rica em informações.

- Investigação académica e acompanhamento

Recolher dados para estudos, para acompanhar publicações ou um sector específico.

Quais são as melhores práticas para a recolha de dados da Web com Python?

O web scraping não consiste apenas em extrair dados. Trata-se também de fazê-lo de forma eficaz, responsável e sustentável.

Para evitar estrangulamentos, respeitar a lei e obter resultados fiáveis, é essencial seguir certas boas práticas:

- 🤖 Respeitar o ficheiro robots.txt

- Adotar um ritmo razoável de pedidos

- 🕵️♂️ Utilizar um User-Agent relevante

- ⚠️ Gestão de erros e excepções

- 🌐 Utilizar proxies e rotadores de IP

- Minimizar os pedidos

- Ser transparente nos seus pedidos

- 📂 Separar a extração da cópia de segurança dos dados

- 🛠️ Utilizar selectores robustos

- Documentar o seu código

Perguntas frequentes

Qual é a melhor estrutura para a recolha de dados da Web em Python?

Não existe um único framework "melhor", pois tudo depende da complexidade do projeto.

Para extracções simples, Pedidos e Bela Sopa são mais do que suficientes. Quando um site utiliza muito JavaScript, Selénio Onde Dramaturgo estão a tornar-se essenciais. Por último, para os projectos de grande envergadura, Sucata é recomendado pelo seu desempenho e estrutura robusta.

Como é que eu faço scrape de um sítio web em Python?

O processo de recolha de dados da Web com Python baseia-se em três fases principais:

- Envio de uma solicitação HTTP

- Análise da estrutura HTML

- Extração de dados

Qual é o papel do "web scraper"?

a papel do "web scraper é percorrer automaticamente as páginas web para extrair dados precisos, sejam eles textos, preços, imagens ou links. Ele atua como um intermediário entre o site e o utilizador, transformando a informação bruta em dados utilizáveis.

Como é que eu uso o Beautiful Soup em Python?

Bela Sopa é uma biblioteca concebida para analisar o código HTML de uma página e facilitar a pesquisa de tags que contêm as informações a extrair.

Basta combinar um Pedido HTTP com Pedidose, em seguida, analisar o conteúdo com o BeautifulSoup para navegar na estrutura e obter os dados de que necessita.

Como é que eu faço scraping de um sítio web com JavaScript?

Alguns sítios dependem fortemente de JavaScript para exibir o seu conteúdo. Nesse caso, as soluções clássicas, como Requests, não são suficientes. É necessário, então, utilizar ferramentas capazes de simular um navegador real. Citamos Selénio e Dramaturgo, para carregar e interagir com a página.

Qual é a linguagem mais comum utilizada para a recolha de dados da Web?

Python é hoje a linguagem mais popular para web scraping, graças à sua simplicidade e à riqueza das suas bibliotecas especializadas.

No entanto, é possível automatizar oextração de dados com PHPembora esta técnica esteja menos difundida.

A raspagem da Web é legal?

o legalidade da recolha de dados na Web é uma questão complexa. Tudo depende da forma como é praticado, do respeito pelas condições de utilização dos sites e da natureza dos dados recolhidos.

Em França, a raspagem da Web é tolerado em certos casos. Mas pode tornar-se ilegal se violar os direitos de acesso, as condições de utilização de um site ou a legislação sobre dados pessoais.

Em suma, a recolha de dados da Web com Python abre um mundo de possibilidades incríveis. Quais são as tuas experiências ou perguntas? Partilhe-as nos comentários, estamos ansiosos por saber a sua opinião!

![Quais são os melhores jogos de cavalos para Switch? [Top 15]](https://www.alucare.fr/wp-content/uploads/2025/12/www.alucare.fr-quels-sont-les-meilleurs-jeux-de-cheval-sur-switch-top-15-Quels-sont-les-meilleurs-jeux-de-cheval-sur-Switch-Top-15-150x150.jpg)