Le web scraping est une technique qui permet de collecter des données en ligne. Il peut se faire à travers des outils spécifiques.

Nous allons voir dans cet article comment extraire des données avec Python.

Prérequis pour faire du scraping avec Python

Il existe quelques conditions à remplir pour pouvoir faire du web scraping avec Python.

1. Avoir des notions en programmation

Vous devez, avant tout, connaître certaines bases en programmation : variables, structures de contrôle, fonctions, dictionnaires, manipulation de fichiers, modules, bibliothèques, etc.

Ces notions vous permettront de comprendre la logique des scripts, de manipuler les données récupérées, d’automatiser des tâches répétitives et de gérer les erreurs et les exceptions.

2. Maîtriser la structure d’une page web (HTML, CSS)

Python ne voit pas les pages web comme nous. Il voit juste le code qui compose cette page. Donc, si vous souhaitez récupérer une information précise, vous devez savoir où elle se trouve dans ce code.

Sans comprendre cela, Python ne peut pas extraire ce que vous voulez.

3. Comprendre les requêtes HTTP (GET, POST)

Avant de pouvoir lire le code d’une page, Python doit le demander au site via une requête. Une requête GET permet de récupérer la page et une requête POST permet d’envoyer des données au site.

Sans savoir comment fonctionnent les requêtes, votre script ne pourra pas obtenir la page ni les infos qu’elle contient.

En résumé, la structure de la page vous dit où chercher les données. Les requêtes HTTP vous permettent de demander ces données au site.

💡 Rappel : le web scraping est différent du crawling. Ce dernier consiste à parcourir toutes les pages d’un site pour les recenser et les analyser. Le scraping, lui, cible uniquement des informations précises. Cette distinction est importante pour planifier correctement le travail.

⚠️ Remarque : Avant de scraper une page, vous envoyez une requête HTTP pour obtenir son contenu. Cependant, tous les sites ne permettent pas que toutes leurs pages soient récupérées automatiquement. C’est là qu’intervient le fichier robots.txt. Il indique quelles pages peuvent être explorées et quelles pages sont interdites. Vous devez respecter ce fichier pour rester légal et éthique.

Quels sont les outils indispensables pour le web scraping avec Python ?

Pour commencer le web scraping avec Python, il est nécessaire de préparer votre environnement.

1. Installer Python

Pour l’installation, il est recommandé d’utiliser pip. C’est un outil de gestion de paquets utilisé pour installer facilement toutes les bibliothèques dont vous aurez besoin.

2. Préparer un environnement virtuel

Chaque projet peut avoir ses propres bibliothèques, indépendamment des autres applications sur votre ordinateur. L’environnement virtuel permettra d’isoler les bibliothèques de votre projet Python sans affecter les autres programmes ou votre machine.

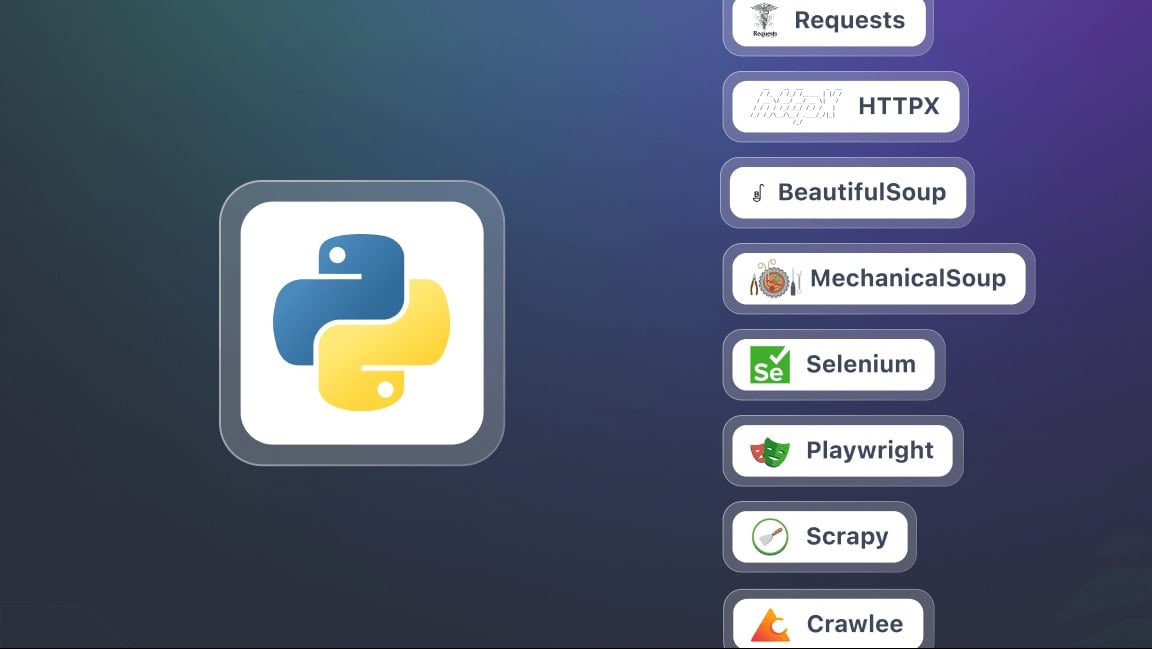

3. Installer les bibliothèques clés pour le scraping

Dans ce contexte, une bibliothèque est un ensemble d’outils et de fonctions déjà programmés que vous pouvez utiliser directement dans votre code Python. Elle vous évite de tout écrire vous-même et facilite certaines tâches. En voici quelques-unes.

- Requests : pour envoyer des requêtes HTTP et pour récupérer le contenu des pages web. C’est la base pour toute opération de scraping.

- BeautifulSoup : pour analyser le code HTML et extraire les informations. Elle propose des méthodes (ou sélecteurs) comme find(), find_all(), select().

- Selenium : utile lorsque le contenu de la page est généré dynamiquement avec JavaScript. Il permet de simuler un navigateur complet et d’interagir avec la page.

- lxml : un analyseur de HTML et XML très rapide. Plus performant que BeautifulSoup, mais légèrement plus complexe à utiliser.

- Playwright : une alternative plus moderne et souvent plus rapide à Selenium.

- Scrapy : un framework puissant pour des projets de scraping à grande échelle. Il permet de gérer facilement plusieurs pages et sites simultanément.

Comment faire du web scraping avec Python ?

Dans ce tutoriel, nous allons voir pas à pas comment débuter le web scraping avec Python.

Étape 1 : Installation des bibliothèques (requests et beautifulsoup4)

Pour commencer, vous avez besoin de deux bibliothèques Python : requests et beautifulsoup4. Installez-les avec pip d’un seul coup :

pip install requests beautifulsoup4Lorsque vous utilisez les deux bibliothèques, n’oubliez pas de commencer votre script par :

import requests

from bs4 import BeautifulSoup

Étape 2 : Faire une requête HTTP et récupérer le contenu

Une fois les bibliothèques installées, vous pouvez envoyer une requête HTTP vers une page web et afficher son contenu. Utilisez l’URL complète de la page cible. Vous utiliserez le script suivant pour une requête :

import requests

url = "https://exemple.com"

page = requests.get(url)

print(page.text) # Affiche le code HTML de la page

Ici, page.text contient tout le HTML du site que vous allez analyser.

Étape 3 : Parser le HTML avec Beautiful Soup

Maintenant que vous avez récupéré le contenu de la page, vous pouvez l’analyser avec BeautifulSoup en utilisant le script suivant :

from bs4 import BeautifulSoup

soup = BeautifulSoup(page.text, "html.parser")

# Exemple : afficher le titre de la page

print(soup.title.string)

Étape 4 : Extraire des données spécifiques (titres, liens, etc.)

Grâce à BeautifulSoup, vous pouvez cibler des balises HTML précises : titres, liens, paragraphes, etc.

# Extraire tous les titres <h2>

for titre in soup.find_all("h2"):

print(titre.get_text())

# Extraire tous les liens <a>

for lien in soup.find_all("a"):

print(lien["href"])

Étape 5 : Sauvegarder les données (CSV, JSON)

Une fois vos données extraites, vous pouvez les sauvegarder dans un fichier pour les réutiliser.

Exemple en CSV :

import csv

titres = [titre.get_text() for titre in soup.find_all("h2")]

with open("resultats.csv", "w", newline="", encoding="utf-8") as f:

writer = csv.writer(f)

writer.writerow(["Titre"])

for t in titres:

writer.writerow([t])

Exemple en JSON :

import json

liens = [lien["href"] for lien in soup.find_all("a")]

with open("liens.json", "w", encoding="utf-8") as f:

json.dump(liens, f, indent=4, ensure_ascii=False)

⚠️ Remarque : ce tuto concerne un petit projet comme le scraping d’un site statique. Toutefois, dans la pratique du scraping web avec Python, vous pouvez rapidement rencontrer des défis supplémentaires comme :

- Gérer la pagination : automatiser le scraping sur plusieurs pages.

- Gérer les formulaires : envoyer des données pour obtenir des résultats.

- Contourner les restrictions : utiliser des user-agents et des proxies.

Pourquoi faire du web scraping avec Python ?

Le web scraping avec Python est une compétence puissante qui ouvre de nombreuses possibilités. Voici quelques usages concrets qui rendent cette pratique particulièrement intéressante.

- Suivi de prix et e-commerce

Scraper des fiches produits pour surveiller l’évolution des tarifs, comparer les offres des concurrents et identifier rapidement les meilleures opportunités.

- Analyse de sentiment

Récupérer les avis clients sur différents sites pour dégager des tendances, comprendre les attentes des consommateurs et améliorer leurs produits ou leurs services.

- Agrégation de contenu

Centraliser les articles de blogs ou les actualités provenant de plusieurs sources pour créer une plateforme toujours à jour et riche en informations.

- Recherche académique et veille

Collecter des données pour des études, pour surveiller des publications ou un secteur spécifique.

Quelles sont les bonnes pratiques pour du web scraping avec Python ?

Le web scraping ne consiste pas seulement à extraire des données. Il s’agit aussi de le faire de manière efficace, responsable et durable.

Pour éviter les blocages, rester dans la légalité et obtenir des résultats fiables, certaines bonnes pratiques sont essentielles à respecter :

- 🤖 Respecter le fichier robots.txt

- ⏳ Adopter un rythme de requêtes raisonnable

- 🕵️♂️ Utiliser un User-Agent pertinent

- ⚠️ Gérer les erreurs et les exceptions

- 🌐 Utiliser des Proxies et des Rotateurs d’IP

- 📉 Minimiser les requêtes

- 🔍 Être transparent dans vos requêtes

- 📂 Séparer l’extraction de la sauvegarde des données

- 🛠️ Utiliser des sélecteurs robustes

- 📖 Documenter votre code

FAQ

Quel est le meilleur framework pour le web scraping en Python ?

Il n’existe pas de “meilleur” framework unique, car tout dépend de la complexité du projet.

Pour des extractions simples, Requests et BeautifulSoup suffisent largement. Lorsqu’un site utilise beaucoup de JavaScript, Selenium ou Playwright deviennent indispensables. Enfin, pour des projets de grande envergure, Scrapy est recommandé grâce à ses performances et sa structure robuste.

Comment scraper un site web en Python ?

Le processus de scraping web avec Python repose sur trois étapes principales :

- Envoi d’une requête HTTP

- Analyse de la structure HTML

- Extraction des données

Quel est le rôle du web scraper ?

Le rôle du web scraper est de parcourir automatiquement les pages web afin d’extraire des données précises, qu’il s’agisse de textes, de prix, d’images ou de liens. Il agit comme un intermédiaire entre le site et l’utilisateur en transformant l’information brute en données exploitables.

Comment utiliser Beautiful Soup en Python ?

BeautifulSoup est une bibliothèque conçue pour analyser le code HTML d’une page et faciliter la recherche des balises qui contiennent les informations à extraire.

Il suffit de combiner une requête HTTP avec Requests, puis de parser le contenu avec BeautifulSoup pour naviguer dans la structure et récupérer les données souhaitées.

Comment scraper un site web avec JavaScript ?

Certains sites reposent fortement sur JavaScript pour afficher leur contenu. Dans ce cas, les solutions classiques comme Requests ne suffisent pas. Il est alors nécessaire d’utiliser des outils capables de simuler un vrai navigateur. On cite Selenium et Playwright, afin de charger et d’interagir avec la page.

Quel est le langage le plus utilisé pour le web scraping ?

Python est aujourd’hui le langage le plus populaire pour le web scraping grâce à sa simplicité et à la richesse de ses bibliothèques spécialisées.

Toutefois, il est possible d’automatiser l’extraction de données avec PHP, bien que cette technique soit moins répandue.

Est-ce que le web scraping est légal ?

La légalité du web scraping est une question complexe. Tout dépend de la manière dont il est pratiqué, du respect des conditions d’utilisation des sites et de la nature des données collectées.

En France, le web scraping est toléré dans certains cas. Mais il peut devenir illégal s’il viole les droits d’accès, les conditions d’utilisation d’un site ou la législation sur les données personnelles.

Bref, le web scraping avec Python ouvre un monde de possibilités incroyables. Et vous, quelles sont vos expériences ou vos questions ? Partagez-les en commentaires, on a hâte de vous lire !